Kraeuterbutter

Admiral

- Registriert

- Nov. 2007

- Beiträge

- 8.271

man hört eigentlich relativ wenig in den Medien von dieser Firma..

mir scheint aber, dass die Technik und Möglichkeiten bezüglich Auflösung alles andere in den Schatten stellen könnte..

hier ein Beispielbild:

Blick in ein Flugzeugcockpit:

links Rift, rechts Varjo

zum Vergleich:

Pixel-Dichte jeh Grad:

Rift und Vive: 9 Pixel / Grad

Oculus Go: 12 Pixel / Grad

Vive Pro / Odyssey: 13 Pixel / Grad

Pimax 5k: 13 Pixel / Grad

Pimax 8k: 19 Pixel / Grad

also der Unterschied zwischen der alten Vive und der Pimax 8k sind - Pixeldichte bezogen - 9 Pixel mehr jeh Grad bzw. ca. eine Verdoppelung horizontal

bei der Varjo kommen wir aber im - nennen wir es - Sweetspot dann auf über 60Pixel / Grad !!!

der REchenaufwand hält sich aber in Grenzen, weil ja nur ein recht kleines Bild - vergleichbar mit der alten Vive - gerendert werden muss

im folgenden Video lief die Demo auf einem Laptop

laut Aussage im Video:

wäre bei einer normalen Brille das komplette Display mit so einer Auflösung ausgerüstet, entspräche das 16k PRO AUGE !

(Pimax 8k hat 4K Auflösung pro Auge)

hier das Video:

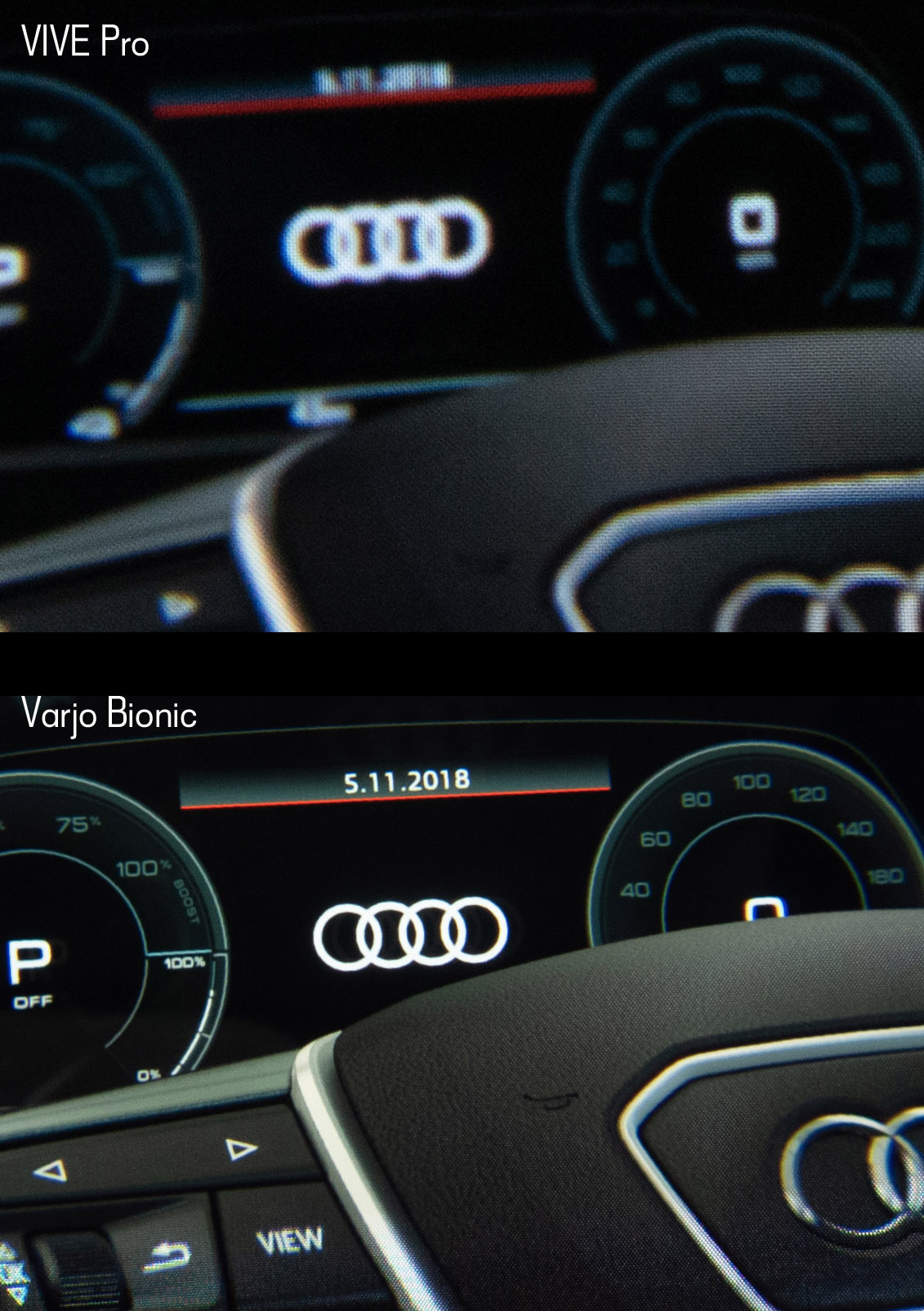

hier noch ein Vergleich, durch die Linsen abfotografiert:

vive Pro vs. Varjo

was haltet ihr davon?

ich denke: die nächsten 10 Jahre oder noch länger, werden wir keine Displays sehen, die an das hier rankommen könnten

dafür bräuchte es Displays mit ca. 30mal sovielen Pixel wie die Pimax 5k bietet

bin gespannt ob die nächsten Jahre sowas wie die Varjo tatsächlich auch für Consumerbereich bezahltbar wird

ich meine nicht Riftkiller, sondern Pimax-Killer..

und klar: es wird kein Killer sein - da sie sich zeitlich und vom Preis her in anderen BEreichen bewegen

mir scheint aber, dass die Technik und Möglichkeiten bezüglich Auflösung alles andere in den Schatten stellen könnte..

hier ein Beispielbild:

Blick in ein Flugzeugcockpit:

links Rift, rechts Varjo

zum Vergleich:

Pixel-Dichte jeh Grad:

Rift und Vive: 9 Pixel / Grad

Oculus Go: 12 Pixel / Grad

Vive Pro / Odyssey: 13 Pixel / Grad

Pimax 5k: 13 Pixel / Grad

Pimax 8k: 19 Pixel / Grad

also der Unterschied zwischen der alten Vive und der Pimax 8k sind - Pixeldichte bezogen - 9 Pixel mehr jeh Grad bzw. ca. eine Verdoppelung horizontal

bei der Varjo kommen wir aber im - nennen wir es - Sweetspot dann auf über 60Pixel / Grad !!!

der REchenaufwand hält sich aber in Grenzen, weil ja nur ein recht kleines Bild - vergleichbar mit der alten Vive - gerendert werden muss

im folgenden Video lief die Demo auf einem Laptop

laut Aussage im Video:

wäre bei einer normalen Brille das komplette Display mit so einer Auflösung ausgerüstet, entspräche das 16k PRO AUGE !

(Pimax 8k hat 4K Auflösung pro Auge)

hier das Video:

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

hier noch ein Vergleich, durch die Linsen abfotografiert:

vive Pro vs. Varjo

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

was haltet ihr davon?

ich denke: die nächsten 10 Jahre oder noch länger, werden wir keine Displays sehen, die an das hier rankommen könnten

dafür bräuchte es Displays mit ca. 30mal sovielen Pixel wie die Pimax 5k bietet

bin gespannt ob die nächsten Jahre sowas wie die Varjo tatsächlich auch für Consumerbereich bezahltbar wird

Ergänzung ()

ich meine nicht Riftkiller, sondern Pimax-Killer..

und klar: es wird kein Killer sein - da sie sich zeitlich und vom Preis her in anderen BEreichen bewegen