News Flash-Speicher: Intel liefert Server-SSDs mit 64-Layer-3D-NAND aus

- Ersteller MichaG

- Erstellt am

- Zur News: Flash-Speicher: Intel liefert Server-SSDs mit 64-Layer-3D-NAND aus

Folge dem Video um zu sehen, wie unsere Website als Web-App auf dem Startbildschirm installiert werden kann.

Anmerkung: Diese Funktion ist in einigen Browsern möglicherweise nicht verfügbar.

Auch SSDs sind wie HDDs nicht frei von unkorrigierbaren Bitfehlern, daher wird dafür auch in der JESD eine UBER angegeben die nicht überschritten werden soll:Gerk schrieb:Für mich ist Haltbarkeit aber die Zeit bis zum ersten unkorrigierbaren Bit auf der SSD. Danach kann ich die SSD an die Wand klatschen, weil der Schaden durch eine verfälschte Datei oder ein verfälschtes Programm unbezahlbar sein kann.

Das ist kein hübscher Kommentar, sondern eine Frage auf die es eine einfache Antwort gibt. Die JESD218 spezifiziert auch die Zeit wie lange die Daten in den NANDs erhalten bleiben, 12 Monate bei 30°C Lagertemperatur bei Client SSDs. Die Temperatur ist wichtig, da die Zeit sich je 5° / 10°C (unterschiedliche Quellen gegeben da unterschiedliche Werte an) mehr halbiert, da die Isolierschicht bei höheren Temperaturen durchlässiger wird. Dieser Wert ist bis zum Erreichen der TBW einzuhalten, sofern der Hersteller die JESD 218 einhält, was nicht zwangsläufig bei jedem Hersteller der Fall sein muss.Gerk schrieb:Ich habe mir einen hübschen Kommentar zu dem Thema gemerkt:

"1000 Schreibzyklen ja, aber wie lange hält es die Ladung?"

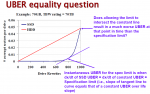

Nein, weder HDDs noch SSDs arbeiten 100% fehlerfrei und die Hersteller geben die UBER an, bei SSDs meist 1:10^16 oder 1:10^17, bei 1:10^16 ist also pro 10^16 gelesener Bits, was etwa 1200TB (1,2PD) entspricht, dann ein unkorrigierbarer Bitfehler im Rahmen der Spezifikationen liegt.Gerk schrieb:Ich stelle mir schon lange die Frage, ist es ein Garantiefall, wenn die erste Datei beschädigt wurde?

Für die Datensicherheit hat man immer selbst zu sorgen und für den medizinischen Einsatz ist Consumer HW sowieso nicht zugelassen.Gerk schrieb:Dass mir keiner den vielleicht katastrophalen Schaden ersetzt, der indirekt durch den Datenverlust ensteht, es kann ja dadurch jemand auf einer Intensivstation sterben, ist klar.

Lies deren AGBs!Gerk schrieb:Welche Haftung übernehmen eigentlich diese Cloud-Anbieter für meine Daten?

Den Eindruck haben ich allerdings auch, nur arbeiten auch die nicht 100%ig fehlerfrei, die UBER ist dort schlechter als bei SSDs und deshalb wählt man bei kritischen Daten auch ein RAID und zwar ein echtes mit Redundanz und kein RAID 0, welches eigentlich ein AID 0 ist. Bei einem echten RAID gibt es praktisch keine unkorrigierbaren Bitfehler, denn wenn der Controller von einer Platte einen Lesefehler statt der Daten bekommt, dann liest er die Daten von der/den anderen Platten und es ist extrem unwahrscheinlich das dort auch ein Lesefehler auftritt. Damit rekonstruiert er die Daten und überschreibt den Sektor auf der Platte die den Lesefehler gemeldet hat und dies führt dazu, dass bei HDDs ggf. ein Reservesektor verwendet wird. Da RAIDs keine Backups ersetzen, gehört dazu noch eine ordentliche Backupstrategie.r4yn3 schrieb:Bitte bleib bei HDDs. Diese Paranoia ist ja kaum auszuhalten.

Holt schrieb:die UBER ist dort [bei HDDS] schlechter als bei SSDs

Bei Google Allmachtphantasien kann ich mir gut vorstellen, dass die ihre FW und vielleicht sogar die HW selbst entwickelt haben, nur, deren Qualität kann man wohl nicht also gut einschätzen, denn folgende Fehler passieren bei modernen SSD Controller überhaupt nicht mehr:The drives in our study are custom designed high performance

solid state drives, which are based on commodity

flash chips, but use a custom PCIe interface, firmware

and driver. We focus on two generations of drives, where

all drives of the same generation use the same device

driver and firmware. That means that they also use the

same error correcting codes (ECC) to detect and correct

corrupted bits and the same algorithms for wearlevelling.

Außerdem gibt es dort offenbar eine Unterscheidung die HDDs und heutige SSDs gar nicht unterscheiden:Final write error: A write operation experiences an error

that persists even after retries.

Meta error: An error accessing drive-internal metadata.

Timeout error: An operation timed out after 3 seconds.

Die geben in aller Regel nur die unkorrigierbaren Lesefehler die auch bei wiederholten Versuchen nicht korrigiert werden konnten, nur die zählen letztlich wirklich zu UBER mit. Dann ist die Frage wie stark die ECC bei den SSDs war? Wie gut wurden die Vorgaben der Hersteller der NANDs bzgl. Spannungen und Timings beim Lesen, Löschen und Programmieren der NANDs eingehalten, zumal ja auch unterschiedliche NAND Typen verwendet wurden? Werden wir alles nie erfahren, aber ich halte diese Daten für absolut nicht auf die halbwegs aktuellen Consumer und Enterprise SSDs der großen Hersteller, also der NAND Hersteller selbst, übertragbar. Das viele der frühen Anbieter von SSDs und SSD Controllern praktisch vom Markt verschwunden sind, spricht auch Bände über die Qualität von deren Produkte.Uncorrectable error: A read operation encounters more

corrupted bits than the ECC can correct.

Final read error: A read operation experiences an error,

and even after retries the error persists.

Wenn Du aber meinst die Daten von Google wären immer noch relevant, bleibt beim Rat von r4yn3 und halte Dich an HDDs, statt SSDs zu verwenden.