Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test Grafikkarten-Stromverbrauch: Leistungsaufnahme und Spitzenlast in Spielen neu ermittelt

Couch-Potatoe

Lt. Junior Grade

- Registriert

- Apr. 2023

- Beiträge

- 256

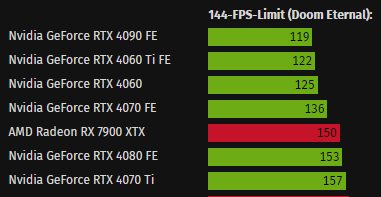

Naja für die 4090 ist es vielleicht nicht so spannend. Aber bei 4k 60 sieht man dann vielleicht die anderen Karten nochmal in einem neuen Licht. Und man kann vielleicht auch sehen, wie sich die Karten im Vergleich zu ihren Vorgängern schlagen. Bei 144fps rödeln ja fast alle schon am Limit. Wie will man da die Effizienz vergleichen?

Robo32

Fleet Admiral

- Registriert

- Sep. 2006

- Beiträge

- 24.114

Ja, allerdings nicht nur auf den ersten Blick, wir wissen es und können es auch interpretieren, allerdings jemand der nur kurz 1x in 3 Jahren reinschaut...ShiftC schrieb:Einige Vorschläge/Hinweise:

Bei den Charts zur Leistungsaufnahme irritiert auf den ersten Blick...

Das Problem ist, dass GPUs welche die Limitierten fps erst gar nicht erreichen nicht fett und mit deren echtem fps Limit markiert werden.

Der Stromverbrauch einer Grafikkarte hängt stark vom verwendeten Treiber sowie dem Spiel ab. Ein krasses Beispiel:

Victoria 3 - Auflösung WQHD, gelockt auf 60 Hz.

Victoria 3 - Auflösung WQHD, gelockt auf 60 Hz.

- Radeon Software 21.10.2 vom 5.10.2021: Stromverbrauch im Schnitt 90W

- Radeon Software 23.2.1 vom 14.2.2023: Stromverbrauch im Schnitt 190W (also mehr als das Doppelte!)

Vincent Hanna

Cadet 1st Year

- Registriert

- Apr. 2016

- Beiträge

- 10

Jepp, das ist es. Unabhängig davon und auf jeden Fall aber: Danke an euch für diese interessanten, neuen Einblicke durch die neuen Tests!Wolfgang schrieb:Schnell und einfach wäre natürlich, im Karussell ein weiteres Diagramm mit den erreichten FPS einzubinden. Aber ist das auch eine gute Lösung?

- Registriert

- Mai 2011

- Beiträge

- 22.759

…dem traue ich auch zu, dass er Überschriften von Diagrammen sowie die Einheit am Ende lesen kann.Robo32 schrieb:Ja, allerdings nicht nur auf den ersten Blick, wir wissen es und können es auch interpretieren, allerdings jemand der nur kurz 1x in 3 Jahren reinschaut...

Auf der anderen Seite hatten wir hier in letzter Zeit aber auch schon Leute die seit 10 Jahren hier sind und dachten, die Performanceratings zeigen FPS…

Pleasedontkill

Lieutenant

- Registriert

- Nov. 2008

- Beiträge

- 597

Den Test hätte ich gern etwas früher gesehen.ultravoire schrieb:Die rx 6800 und rx 6800xt sind miteinander verwandt und dann doch so verschieden bei diesem test. kaum zu glauben.

Habe auch eine 6800xt und mit 750W hat mein System sich immer wieder verabschiedet. War aber als das Min. angegen!

Auch UV und reduktion der Leistungsverfügbarkeit hat nicht genug Stabilität gebracht.

Ist mit 1000W, nicht mehr der Fall.

Aber gut zu sehen, dass ich mich doch besser gegen die RTX3080 entschieden habe. Das Resultat ist katastrophal!

Ergänzung ()

Kann nicht genug spielen in 5Jahren damit ich das raus holen kann.danyundsahne schrieb:Danke CB für diese Messreihe! Klasse!

Nach dem Test sieht es für RDNA3 gar nicht mal so schlecht aus wie viele behaupten:

Nvidias Ada-Lovelace-Generation hat bei dieser Messreihe nach wie vor die Nase klar vorne, kann sich aber nicht mehr so enorm von den Konkurrenzmodellen absetzen, AMDs RDNA 3 hält in Full HD und WQHD gut dagegen.

Teilweise (im FPS Limit) ist die 7900XTX sogar effizienter als eine 4070ti/4080. War so nicht ganz zu erwarten.

Da sind es auch eher die RTX30 Karten, die absolut am meisten saufen...

Unterm Strich sind die Unterschiede garnicht so eklatant bei den neuesten Generationen beider Hersteller.

AMDs verbrauchen etwas mehr, dafür sind die Karten teilweise hunderte Euros günstiger. Das macht über ein paar Jahre Nutztungsdauer eigentlich nichts aus was die Kosten betrifft.

Würde mich auch weniger auf, wohlmöglich gespart stürzen als ganz sicher nicht ausgegeben.

Dazu kommt, AMD braucht weniger Strom mit weniger Spitzen 6800xt vs 3080.

Immer wenn NV im Lead ist wird das Stromsparen hochgehalten, schon komisch.

Zuletzt bearbeitet:

Taxxor schrieb:Ohne das UV Profil siehts schon etwas anders aus

Mit OC Profil kommt man auf warme 550Watt.

Pleasedontkill

Lieutenant

- Registriert

- Nov. 2008

- Beiträge

- 597

Ps: Gutes Netzteil kann Spulenfipen auf der Grafikkarte vermeiden.Tom_111 schrieb:Kondensatoren glätten die Spannung, Spulen den Strom.

Tom_111

Banned

- Registriert

- Juli 2018

- Beiträge

- 560

Das habe ich schon öfter gehört. Ich hatte noch nie Probleme mit Spulenfiepen und verwende nur noch hochwertige Netzteile. Viele PC-Bauer knausern leider am Netzteil. Mit Super Flower Netzteilen habe ich gute Erfahrungen gemacht.Pleasedontkill schrieb:Ps: Gutes Netzteil kann Spulenfipen auf der Grafikkarte vermeiden.

Zuletzt bearbeitet:

mgutt

Commander

- Registriert

- März 2009

- Beiträge

- 2.075

Ok, jetzt hätte ich gerne eine 4090 Light. Also eine 4090, aber mit dem 250W TDP Limit der Workstation RTX 5000. Die Karte hätte nur 2 Slots und ich bräuchte kein fettes Netzteil. Echt erstaunlich wie effizient die 4090 eigentlich ist, wenn man sich das 144 FPS @ WQHD Limit bei Doom anschaut. Und wie ineffizient im Vergleich eine RTX 4070 TI ist. Die läuft wohl extrem außerhalb ihres Sweet Spot.

Darf man annehmen, dass die RTX 4060 TI die 144 FPS bei WQHD gepackt hat? Diese Angabe fehlt mir tatsächlich auch in dem Test. Das wurde ja bereits angemerkt, dass das verwirrend für den Leser ist, insbesondere bei den 4K Ergebnissen. Meiner Ansicht nach sollten die Karten dann mit "nicht erreicht" und ohne Watt-Zahl aufgeführt werden.

Wobei ich ehrlich gesagt nicht verstehe wie die 4090 es schafft effizienter als die 4060 Ti zu sein:

Ich mein beide haben komplett unterschiedlich große Dies mit komplett unterschiedlicher Anzahl von Kernen usw.

https://www.techpowerup.com/gpu-specs/nvidia-ad102.g1005

https://www.techpowerup.com/gpu-specs/nvidia-ad106.g1014

Schaltet der 4090 einfach die Kerne komplett ab, die er nicht nutzt? Und wenn ja, warum machen das dann nicht auch 4080 & Co?

Oder macht PCIe X8 bei der 4060 so viel aus? Wäre das nicht mal ein interessanter Test? Also was verbraucht/leistet zB eine 4080, wenn man die Hälfte der Pins abklebt?

Darf man annehmen, dass die RTX 4060 TI die 144 FPS bei WQHD gepackt hat? Diese Angabe fehlt mir tatsächlich auch in dem Test. Das wurde ja bereits angemerkt, dass das verwirrend für den Leser ist, insbesondere bei den 4K Ergebnissen. Meiner Ansicht nach sollten die Karten dann mit "nicht erreicht" und ohne Watt-Zahl aufgeführt werden.

Wobei ich ehrlich gesagt nicht verstehe wie die 4090 es schafft effizienter als die 4060 Ti zu sein:

Ich mein beide haben komplett unterschiedlich große Dies mit komplett unterschiedlicher Anzahl von Kernen usw.

https://www.techpowerup.com/gpu-specs/nvidia-ad102.g1005

https://www.techpowerup.com/gpu-specs/nvidia-ad106.g1014

Schaltet der 4090 einfach die Kerne komplett ab, die er nicht nutzt? Und wenn ja, warum machen das dann nicht auch 4080 & Co?

Oder macht PCIe X8 bei der 4060 so viel aus? Wäre das nicht mal ein interessanter Test? Also was verbraucht/leistet zB eine 4080, wenn man die Hälfte der Pins abklebt?

Zuletzt bearbeitet: