- Registriert

- Aug. 2004

- Beiträge

- 12.250

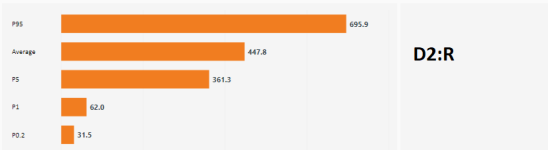

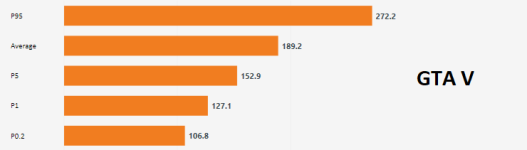

YAAB ist halt ein 1a RAM Bench, aber ein miserabler CPU benchOPUS-AMP schrieb:Schade, dass ARMA 3 YAAB nicht Teil des Testparcours ist, klar ist halt echt alt. Wird hier dann hoffentlich bald im Community Forum geschehen.