Es ist schon etwas länger, dass ich ein System gebaut habe.

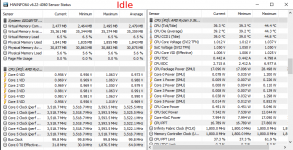

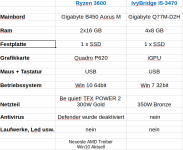

Jetzt habe ich mir einen Rechner mit Ryzen 3600 gebaut und da mein Gehäuse etwas klein ist, musste ich dies und jenes etwas anpassen. Aus reiner Neugier habe ich ein Energiekosten-Messgerät angeschlossen. Der Ryzen Rechner läuft jetzt ohne PBO und die TDP ist auf 45W in Bios herabgesetzt worden. Der Rechner braucht idle 30W. Bei Musik abspielen ist mir aber aufgefallen, dass es gleich auf 45W steigt. Ich hatte in Erinnerung dass mein alter Rechner mit IvyBridge (4 Kerne) weniger braucht. Alten Rechner angeschlossen und es in Teillast verglichen. Ryzen 3600 idle 30W Ivy Bridge 28W. Musik abspielen AMD 45W und Intel 28W.

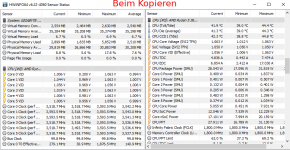

Beim Kopieren von einem USB Stick über USB 3.0 AMD 50W und Intel 34W. Meine Frage ist jetzt ob bei alle aktuellen CPUs bei Teillast der Verbrauch so steigt, oder ist es nur bei AMD so? Der Ivy Bridge ist von 2012 und ich hätte eigentlich gedacht, dass neue Architektur zumindest in Teillast nicht schlechter ist. Es macht kein Unterschied ob Energiesparplan AMD Balanced oder Windows Balanced. Kann mir da jemand dabei helfen meine Wissenslücke zu schließen?

Wie verhält sich z.B. ein i7 8700 in Teillast?

Jetzt habe ich mir einen Rechner mit Ryzen 3600 gebaut und da mein Gehäuse etwas klein ist, musste ich dies und jenes etwas anpassen. Aus reiner Neugier habe ich ein Energiekosten-Messgerät angeschlossen. Der Ryzen Rechner läuft jetzt ohne PBO und die TDP ist auf 45W in Bios herabgesetzt worden. Der Rechner braucht idle 30W. Bei Musik abspielen ist mir aber aufgefallen, dass es gleich auf 45W steigt. Ich hatte in Erinnerung dass mein alter Rechner mit IvyBridge (4 Kerne) weniger braucht. Alten Rechner angeschlossen und es in Teillast verglichen. Ryzen 3600 idle 30W Ivy Bridge 28W. Musik abspielen AMD 45W und Intel 28W.

Beim Kopieren von einem USB Stick über USB 3.0 AMD 50W und Intel 34W. Meine Frage ist jetzt ob bei alle aktuellen CPUs bei Teillast der Verbrauch so steigt, oder ist es nur bei AMD so? Der Ivy Bridge ist von 2012 und ich hätte eigentlich gedacht, dass neue Architektur zumindest in Teillast nicht schlechter ist. Es macht kein Unterschied ob Energiesparplan AMD Balanced oder Windows Balanced. Kann mir da jemand dabei helfen meine Wissenslücke zu schließen?

Wie verhält sich z.B. ein i7 8700 in Teillast?