Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Erster „Direct Compute“-Benchmark aufgetaucht

- Ersteller Wolfgang

- Erstellt am

- Zur News: Erster „Direct Compute“-Benchmark aufgetaucht

kayroellig

Cadet 4th Year

- Registriert

- Nov. 2005

- Beiträge

- 73

kayroellig

Cadet 4th Year

- Registriert

- Nov. 2005

- Beiträge

- 73

mir fällt auf das sehr unterschiedliche ergebnisse entstehen je nach HW und konfig

kayroellig

Cadet 4th Year

- Registriert

- Nov. 2005

- Beiträge

- 73

mal sehen wann amd ergenisse kommen

und womit erklärst Du dann das folgende Ergebnis?FloW3184 schrieb:...Das liegt daran, dass direct-compute noch nicht in hardware von der GPU berechnet werden kann bei ner ATI... wird also noch in software berechnet... also genau das, was der CPU-Wert ausspuckt...

in der Readme, die ebenfalls im Zip-File des Benches steckt, ist auch von einem Ergebnis von 10.000-11.000 Punkten für eine HD 5870 die Rede.

Die werden doch nicht auch zufällig mit einem Core i7 gebencht haben, der auf 4 GHz ohne SMT läuft.

Aber das bei ATI zu Beginn nur die Berechnung über die CPU integriert war, war mir bekannt. Wenn man sieht, wie sich die ATI-GPUs aktuell schlagen, dann wird einem vielleicht auch klar, warum.

P.S. nehmt mir den letzten Satz nicht übel. Irgendwie muss ich mich über meine niedrige PPD hinweg trösten.

Edit

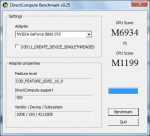

hier die 0.25er Version des Benches:

in der neuen Readme wird kein ATI-Ergebnis mehr genannt.

achja, der aktuelle Catalyst unterstützt laut der neuen Readme nur bei DX10/10.1 GPUs kein DirectCompute.

und hier noch ein Screen als Ergänzung:

Zuletzt bearbeitet:

kayroellig

Cadet 4th Year

- Registriert

- Nov. 2005

- Beiträge

- 73

Konti

Banned

- Registriert

- Apr. 2005

- Beiträge

- 6.421

Ich find's gut, daß in der Richtung (GPU-computing) jetzt auch Benchmark-technisch mal was passiert.

Allerdings sehen die Werte im Moment noch relativ willkürlich aus ... bis man da wirklich aussagekräftige Zahlen rausbekommt, wird's wohl noch ein paar Versionsnummern dauern.

Allerdings sehen die Werte im Moment noch relativ willkürlich aus ... bis man da wirklich aussagekräftige Zahlen rausbekommt, wird's wohl noch ein paar Versionsnummern dauern.

ka wie einige so hohe CPU Werte bekommen. Hab q6600@3.33ghz.

ca 20k bei ner gtx285 halte ich für realistisch, da ne gtx260 schon gut doppelt so schnell wie meine Karte ist.

PS: seh grad über mir ne 88gt mit 13000. kann fast nicht glauben, dass der g92 doppelt so schnell sein soll wie der g80.

ca 20k bei ner gtx285 halte ich für realistisch, da ne gtx260 schon gut doppelt so schnell wie meine Karte ist.

PS: seh grad über mir ne 88gt mit 13000. kann fast nicht glauben, dass der g92 doppelt so schnell sein soll wie der g80.

Anhänge

Zuletzt bearbeitet:

silent-efficiency

Banned

- Registriert

- Aug. 2004

- Beiträge

- 5.253

Zombiez schrieb:PS: seh grad über mir ne 88gt mit 13000. kann fast nicht glauben, dass der g92 doppelt so schnell sein soll wie der g80.

Die Karten mit G92 setzen auf einen doppelt so schnellen PCIe-Interface, also auf PCIe 2.0, während die G80-Karten auf PCIe 1 noch setzen. Wenn im Benchmark die Daten von CPU zu GPU hin und her bewegt werden und dies bewertet wird, dann kann es hier schon zu erheblichen Unterschieden kommen... (zudem hat die 8800 GT immerhin 150 GFLOPs mehr als die 8800 GTS G80)

Zuletzt bearbeitet:

Krautmaster

Fleet Admiral

- Registriert

- Feb. 2007

- Beiträge

- 24.238

w0mbat schrieb:Dann bist du aber ziemlich auf das NV-Marketing reingefallen. NV kann froh sein wenn sie im GPGPU-Bereich mit Fermi auf Cypress aufschließen.

nunja, dazu hätte ich gerne eine Quelle. Welches Marketing? Schonmal von Tesla etc gehört? PhysX ist im Grunde nichts anderes als eine GPGPU Anwendung. Ich finde dass bei Nvidia im Bereich Computing viel viel mehr Aktivität herrscht als bei AMD, warum wohl? Siehe GPU unterstützte Videokonvertierung.

Marius schrieb:Was ist daran wundersames wenn eine GTX260 einen 5870 schlägt?

Die G200 sind dezitierte GPGPU Prozessoren, die halt AUCH Spiele darstellen können, während ATI NUR Spiele darstellen kann und sonst nix reißt und darum im GPGPU so gut wie gar nicht zur Anwendung kommt.

Sieh Profibereich von Nvidia: Quadroplex(Grafik/GPGPU), Tesla (Supercomputer)

Nvidia setzt jetzt alles daran im GPGPU Bereich Oberwasser zu behalten, gegen Intels Larabee, der auch eine dezitierte GPGPU Karte ist.

richtig. Was AMD hier leistet ist bis jetzt noch äußerst ungewiss.

dMopp schrieb:Also ein völlig sinnfreies Benchmarktool..

Im übrigen bieten die ATi GPUs eine WEITAUS höhere GPGPU Rohleistung als die NV Konkurrenz, deshalb sind die Ergebnisse eher Blödsinn von dem Tool (siehe einige Lustige Ergebnisse hier)

Das mit der höheren Rohleistung weiß jeder. Und daraus auf die Leistung für Grafikdarstellung und Computing zu schließen und schlichtweg naiv und dumm. Bei der Rohleistung handelt es sich nach wie vor um einen Peak der erreichbar ist, bei AMD aber aufgrund der Shaderarchitektur (5D) viel schwerer erreichbar ist als bei Nvidia. Ich behaupte GFlops lassen sich auch in Zukunft nicht einfach auf die Computing Leistung umrechnen.

0xffffffff schrieb:Selten so einen Schwachsinn gelesen. Beweis durch Behauptung?

Quelle

Die Zahl der Transistoren beläuft sich auf satte 1,4 Milliarden, womit man die Schaltkreise gegenüber dem G80 mehr als verdoppelt hat – ein Großteil davon wurde in die Verbesserung der GPU-Computing-Fähigkeiten gesteckt.

...

So gibt es den „Graphics Processing Mode“ (GPM), der in einer herkömmlichen 3D-Anwendung zum Einsatz kommt, sowie einen „Parallel Compute Mode“ (PCM) für GPU-Computing-Berechnungen mittels CUDA.

In vielerlei Hinsicht wurde aus der reinen 3D Karte 8800 GTX schrittweise eine immer mehr für Computing brauchbare Recheneinheit. Die speziellen Änderungen dahingehend erreichen mit dem G300 einen neuen Höhepunkt.

Man muss nicht besonders hell sein um zu sehen dass der G300 immer mehr in Richtung Extrem Multicore CPU tendiert während der RV870 eigentlich nur ein überholter RV600 ist. Das ist auch nicht weiter schlimm, das kommt uns ja zur Gute den wir zocken in erster Linie mit unserer Grafikkarte und was anderes muss sie - bis jetzt, nicht wirklich können.

Der G200 ist der Zwischenschritt. Warum wurde wohl beim Release zum ersten mal das GPGPU Benchmark mit in den Testparcour genommen?

Will ich AMD an den Pranger stellen, nein will ich nicht. Allerdings ist es einfach so dass AMD die Leistungsfähigkeit und ihrer ach so tollen hohen GFlops bisher wenig zur Schau stellen konnte. GPU Computing steckt noch alles in den Kinderschuhen und vermutlich auch das meiste von der Programmierung ab. Wirklich vergleichen kann man die Grafikkarten mit diesem Tool jedoch noch nicht.

Zuletzt bearbeitet:

silent-efficiency

Banned

- Registriert

- Aug. 2004

- Beiträge

- 5.253

@Krautmaster

Ja schön, dass du hier CB zitierst, wo CB erzählt, dass die nVidia-Graka auch für GPU-Computign optimiert worden ist.

Nur leider hat CB aus zeitlichen Gründen nicht geschafft, dies auch beim Cypress hinzuschreiben, obwohl dort ebenfalls viel für GPU-Computing getan wurde

Siehe dazu diesen Thread: https://www.computerbase.de/forum/threads/opencl-auf-amds-grafikkarten-von-cb-ignoriert.650231/

Ja schön, dass du hier CB zitierst, wo CB erzählt, dass die nVidia-Graka auch für GPU-Computign optimiert worden ist.

Nur leider hat CB aus zeitlichen Gründen nicht geschafft, dies auch beim Cypress hinzuschreiben, obwohl dort ebenfalls viel für GPU-Computing getan wurde

Siehe dazu diesen Thread: https://www.computerbase.de/forum/threads/opencl-auf-amds-grafikkarten-von-cb-ignoriert.650231/

Krautmaster

Fleet Admiral

- Registriert

- Feb. 2007

- Beiträge

- 24.238

das ist ja auch schön und gut so. Aber umsetzten lässt sich das noch nicht. Es gibt schlichtweg noch nichts dafür. Deswegen schrieb ich auch dass sich die Leistung dahingehend noch garnicht abschätzen läasst da jeder grad noch sein eigenes Süppchen kocht. Erst wenn es einen transparenten - AMD NV unabhängigen Dx11 Computing Benchmark gibt lässt sich eventuell eher etwas über die GPGOU Leistung sagen.

Mit dem Zitat wollte ich lediglich klarstellen dass der G200 eben auch wegen der Computing Geschichte so groß ausfällt und ich bin überzeugt dass sich NV weiter in diese Richtung begeben wird.

Will man heute ein 2 GB Video in HD mit einer GPU herunterkomprimieren. Wie geh ich da vor?

Bisher habe ich die Lösungen seitens Nvidia für weiter und komfortabler gehalten.

Aussagekraft hätte nur eine Software die mit einer transparenten Schnittstelle ein Video komprimiert, sodass das Ergebnis 100% exakt gleich ausfällt und die Zeit dann ein Indiz für die GPGPU Leistung im Bereich Videokomprimierung ist.

Das wäre ein Fall bei dem ich persönlichen Nutzen daraus ziehen würde.

Steam und Cuda kannamn einfach nicht gegenüber stellen.

Mit dem Zitat wollte ich lediglich klarstellen dass der G200 eben auch wegen der Computing Geschichte so groß ausfällt und ich bin überzeugt dass sich NV weiter in diese Richtung begeben wird.

Will man heute ein 2 GB Video in HD mit einer GPU herunterkomprimieren. Wie geh ich da vor?

Bisher habe ich die Lösungen seitens Nvidia für weiter und komfortabler gehalten.

Aussagekraft hätte nur eine Software die mit einer transparenten Schnittstelle ein Video komprimiert, sodass das Ergebnis 100% exakt gleich ausfällt und die Zeit dann ein Indiz für die GPGPU Leistung im Bereich Videokomprimierung ist.

Das wäre ein Fall bei dem ich persönlichen Nutzen daraus ziehen würde.

Steam und Cuda kannamn einfach nicht gegenüber stellen.

Zuletzt bearbeitet:

- Registriert

- Nov. 2002

- Beiträge

- 8.630

Artikel-Update: Mittlerweile gibt es eine neue Version von dem Tool (v0.25), die primär offensichtlich die GPU-Performance stark erhöht hat.

Ähnliche Themen

- Antworten

- 26

- Aufrufe

- 1.921

Leserartikel

Kühler- gegen Steckergate: DevPandis Hin und Her

- Antworten

- 72

- Aufrufe

- 16.346

- Antworten

- 83

- Aufrufe

- 16.897

- Antworten

- 8

- Aufrufe

- 3.321

- Antworten

- 3.076

- Aufrufe

- 239.988