Ray Donovan schrieb:

Meine Xbox Series X verbraucht ~210W unter Vollast. Da sieht man ja das Potenzial was möglich ist (was würde die RTX4090 mit einem Cap auf 210W erreichen? wobei man den reinen CPU-Verbrauch der Xbox Series X ja noch abziehen müsste, also müsste man den Cap sogar noch weiter unten ansetzen). Aber da spielt man 4k auch nicht in >144 Hz.

Wenn die RTX 4090 nur 210 Watt brauchen würde hätte sie sicherlich auch noch eine sehr gute Leistung aber das würde die Karte obsolet machen, denn wer sich solch eine Karte in den PC zimmert der hat normalerweise keine Sorgen, wenn es um Stromverbrauch und Leistungsaufnahme geht. Die Karte ist und bleibt etwas für Enthusiasten.

Undervolting hat bei den Nvidia Karten eigentlich schon immer gut funktioniert. Meine letzte Nvidia (RTX 2070 Super) von Gigabyte war ja schon eine sehr per Bios hochgeprügelte Karte mit einer Leistungsaufnahme bis hin zu 250 Watt.

Das konnte man per MSI Afterburner aber so gut konfigurieren, das man durch Undervolting und gleichzeitiger Übertaktung die GPU gerade mal 180 Watt verbaucht hat plus den Rest des Systems noch hinzu addiert.

Meine jetzige Karte, eine AMD RX 6800 im Referenzdesign ist auch eine sehr gute und effiziente Karte, wenn es um 4k Gaming geht, aber so gut wie die RTX 2070 Super bekomme ich es bei der Radeon nicht hin.

Ray Donovan schrieb:

Ich denke, dass da deutlich mehr gehen würde, wenn man Effizienz priorisieren würde. Man hat mit KI aber einen anderen Ansatz und kann die Rohleistung vernachlässigen. Dazu noch RT was auch noch Leistung on mass zieht.

Ich finde nicht das RT so sehr an Leistung frisst, sondern eher an Performance. Leistungsaufnahme steigt enorm an, wenn du einen Gaming Monitor hast, der so wie meiner neben den üblichen 60Hz auch 120Hz und 165Hz anbietet. Was da die 2070 Super auch an Spulenfiepen erzeugt hat, war für meine Ohren schon zu viel. Das konnte ich damals nur mit Undervolting & Overclocking in den Griff kriegen. Als ich mir den Gigabyte Gaming Monitor G32QC Ende November 2020 zugelegt habe, wollte ich auch mal das ganze Potenzial von G-Sync & Co austesten ohne darüber nachzudenken wie sehr dadurch der Stromverbauch ansteigt. Es war einfach nicht zu Ende gedacht und zu wenig Recherche die ich da betrieben habe. Wenn du dann auch noch HDR 400 Rendering beim Monitor in Anspruch nimmst frisst das alleine schon 40 Watt mehr an Leistung. Der Monitor hat eine native 1440p Auflösung, wir sprechen hier also nicht einmal von nativen 2160p.

Ray Donovan schrieb:

Es geht ja gar nicht mehr um Effizienz sondern die letzten fps rausquetschen. Dabei wird die Grafik erst mit enormen Aufwand durch RT verbessert nur um es dann nativ runterskalieren zu müssen (weil die Leistung nicht reicht) damit die KI es dann anschließend mit künstlichen Bilder (in Echtzeit, was zwangsläufig - gerade bei sehr schnellen Bewegungen - zu lags führt und G-Sync/FreeSync eigentlich absolet macht) wieder hochskalieren kann. Wie gesagt, ich kann mit dieser Entwicklung nichts anfangen.

Ich mittlerweile auch nichts mehr. Es kommt aber auch darauf an, wie gut diese Features in die Spiele implementiert werden in der Zukunft. Ich ertappe mich dabei immer wieder, das ich FSR2.0 sowie FSR2.1 in den Games die ich habe und dies unterstützen schon mal anteste und es natürlich schön ist, das die FPS dadurch konstanter werden oder auch spürbar ansteigen, aber für mich ist der Leistungsschub eher zu vernachlässigen weil ich mit meinen Augen leider auch eine Verschlechterung der Bildqualität feststelle. Da mag auch an meinem VA Panel liegen aber im Gegensatz zu FSR sah DLSS egal ob hoch oder runterskaliert auf der RTX 2070 Super um längen besser aus.

Ray Donovan schrieb:

Muss man 4k denn mit > 144 hz spielen? Ist das nötig oder das nicht eigentlich auch ein "Luxus-Problem"?

Es ist und bleibt eine optionale Möglichkeit, die bei dem einen oder anderen Game sicherlich Spaß bereitet. Ich gebe dir aber recht. Es ist eher ein Luxusproblem.

Ich spiele in erster Linie Renn sowie Jump & Run Spiele auf meinen 4k TV und da langen mir die 60 FPS die der Bildschirm max ausgeben kann vollkommen aus. Dadurch bleibt die Leistungsaufnahme der RX 6800 im Rahmen und tut der Spielfreude keinen Abbruch.

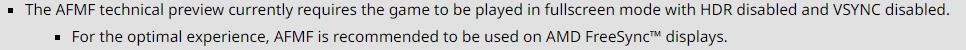

Aber Spiele wie Doom 2016 oder Doom Eternal machen auf dem Gaming Monitor mit 120Hz bzw 165Hz schon Spaß. Das HDR Feature ist eine nette Nebensache, aber wenn es Verbindung mit FSR 3 mit FMF noch solche Probleme bereitet dann kann man selbst in der Beta befindlichen Treiberentwicklung von keinem echten Gegenspieler zu DLSS sprechen.

Schön ist, das AMD es für Nvidia Karten mitentwickelt und ich wäre Nvidia dankbar wenn man DLSS auch etwas quelloffener gestalten würde.

Vor dem Gigabyte Monitor hatte ich einen AOC 4k 75Hz AMD Freesync Monitor in 27 Zoll aber da empfand ich damals alles zu klein von der Auflösung im Verhältnis zu Zollgröße.

Meine Glupscher werden auch immer schlechter seit 5 Jahren. Die Last der Älterwerdens halt 🤓