Servus Leute,

ich hab zwar gefühlt das ganze Forum durchgearbeitet, aber leider keine genaue Antwort auf das eventuell zugrunde liegende Problem in meinem Anwendungsfall gefunden. Aber ich vermute dass es einfach etwas total simples ist was ich einfach übersehe...

Situation:

Workstation Rechner im Büro:

CPU: AMD Ryzen 3800x

RAM: 32GB

NIC: ASUS XG-C100C (auf PCI-E 1x 2.0) (neuster Treiber von Asus)

OS: Windows 10 Pro x64

Controller: LSI MegaRAID 9260-16i (auf PCI-E 8x 2.0)

HDDs: 8x WD Purple 14TB

Backup Server im Keller:

CPU: Intel Xeon E5-2630v2

RAM: 64GB

NIC: Broadcom BCM57711 NetXtreme II (auf PCI-E 8x 2.0)

OS: Windows Server 2008 R2 Enterprise

Controller: LSI MegaRAID 9260-4i (auf PCI-E 8x 2.0)

Backplane: LSI SAS Expander in Supermicro Server Gehäuse

HDDs: 24x 3TB Hitachi Enterprise SAS

Netzwerk:

Switch: Cisco SG350X-24

Server <> Switch: SFP+ 10G-SR zu SFP+ 10G-SR, 3m OM4 Kabel

Workstation <> Switch: RJ45, 15m Cat6a S/FTP Patchkabel

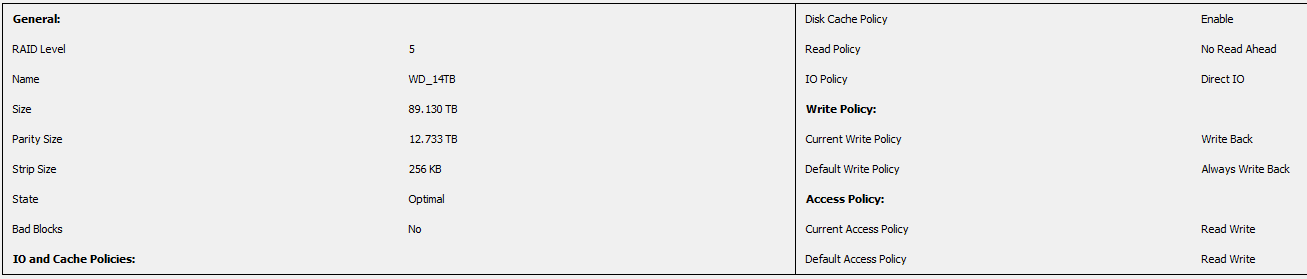

Einstellungen RAID auf Workstation:

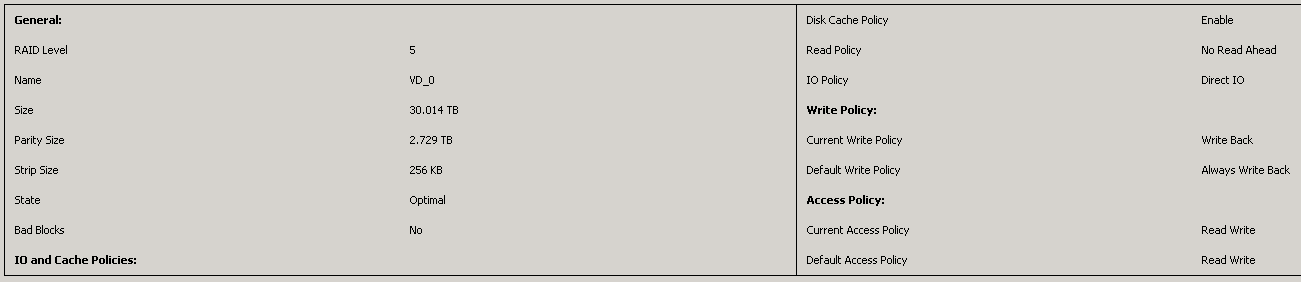

Einstellungen RAID auf Server:

Einstellungen NIC Workstation & NIC Server:

Flow Control Rx & Tx Enabled

Jumbo Packet 9014 Bytes

Alles andere auf Standard

Einstellung auf Switch: Jumbo Frames: Enabled (global setting)

Nun zum Ergebnis: File Transfer via Windows Explorer von Server -> Workstation (10GB+ per file): 280mb/s avg

Das erscheint mir mit dem Setup ehrlich gesagt etwas zu wenig. Mir ist zwar durchaus bewusst dass aufgrund des PCI-E 1x 2.0 für die 10G NIC in der Workstation ein Bottleneck bei ca 500mb/s besteht (abzüglich Overhead), aber mehr als 280mb/s sollten schon irgendwie drin sein.

Hat jemand eine Idee was ich übersehen haben könnte?

Beste Grüße

ich hab zwar gefühlt das ganze Forum durchgearbeitet, aber leider keine genaue Antwort auf das eventuell zugrunde liegende Problem in meinem Anwendungsfall gefunden. Aber ich vermute dass es einfach etwas total simples ist was ich einfach übersehe...

Situation:

Workstation Rechner im Büro:

CPU: AMD Ryzen 3800x

RAM: 32GB

NIC: ASUS XG-C100C (auf PCI-E 1x 2.0) (neuster Treiber von Asus)

OS: Windows 10 Pro x64

Controller: LSI MegaRAID 9260-16i (auf PCI-E 8x 2.0)

HDDs: 8x WD Purple 14TB

Backup Server im Keller:

CPU: Intel Xeon E5-2630v2

RAM: 64GB

NIC: Broadcom BCM57711 NetXtreme II (auf PCI-E 8x 2.0)

OS: Windows Server 2008 R2 Enterprise

Controller: LSI MegaRAID 9260-4i (auf PCI-E 8x 2.0)

Backplane: LSI SAS Expander in Supermicro Server Gehäuse

HDDs: 24x 3TB Hitachi Enterprise SAS

Netzwerk:

Switch: Cisco SG350X-24

Server <> Switch: SFP+ 10G-SR zu SFP+ 10G-SR, 3m OM4 Kabel

Workstation <> Switch: RJ45, 15m Cat6a S/FTP Patchkabel

Einstellungen RAID auf Workstation:

Einstellungen RAID auf Server:

Einstellungen NIC Workstation & NIC Server:

Flow Control Rx & Tx Enabled

Jumbo Packet 9014 Bytes

Alles andere auf Standard

Einstellung auf Switch: Jumbo Frames: Enabled (global setting)

Nun zum Ergebnis: File Transfer via Windows Explorer von Server -> Workstation (10GB+ per file): 280mb/s avg

Das erscheint mir mit dem Setup ehrlich gesagt etwas zu wenig. Mir ist zwar durchaus bewusst dass aufgrund des PCI-E 1x 2.0 für die 10G NIC in der Workstation ein Bottleneck bei ca 500mb/s besteht (abzüglich Overhead), aber mehr als 280mb/s sollten schon irgendwie drin sein.

Hat jemand eine Idee was ich übersehen haben könnte?

Beste Grüße