Nein! Doch! Oh!xexex schrieb:Erzähle keinen Blödsinn!!! Siehe meinen vorherigen Link oder diesen:

[...]

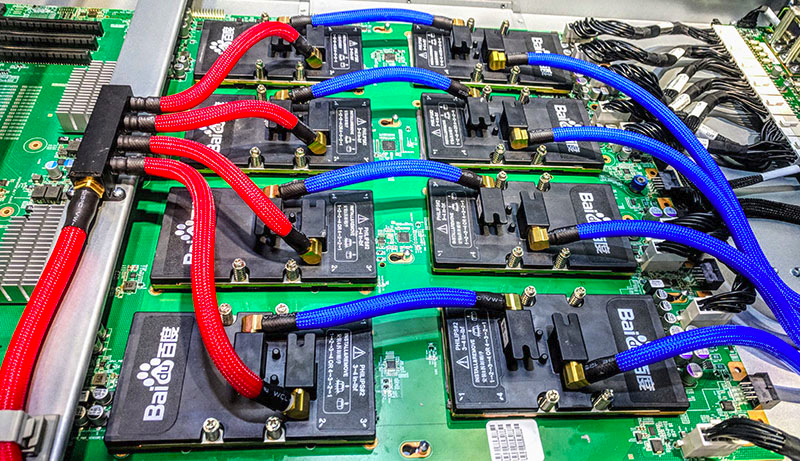

(Quelle: https://www.servethehome.com)

Der typische Anwendungsfall ist direkte Wasserkühlung, da der Kühlaufwand so einer Kiste enorm ist und mehrere dieser Kisten mit regulärer Luftkühlung kaum (effizient) zu bändigen sind.

Das entspräche gut 40 kW pro Rack.

Solche Systeme existieren schon seit Jahren und Servernetzteile mit 1000W und mehr sind problemlos und bezahlbar erhältlich. Was glaubst du was die professionellen Nvidia Lösungen so verballern?

Dass es Netzteile mit 1+ kW gibt, ist hinlänglich bekannt, allerdings verbaut man die eher selten, weil normale Systeme damit völlig überdimensioniert sind. D.h. es kostet Geld und Effizienz (also noch mehr Geld).

Sie sind im Regelfall auch nicht dafür gebaut eine einzelne Komponente mit 500 Watt Abwärme aufzunehmen.

Typische GPUs enden...

https://images.nvidia.com/content/t...volta-v100-datasheet-update-us-1165301-r5.pdf

mit eienr TDP von 300 Watt. Davon werden dann nach Bedarf mehr verbaut.

Erst meckern, dass das Ding ineffizient sei...[...]

Mit 500W für 4096 Shader, wäre Intels Lösung auf dem Papier aber nicht wirklich effizient. Tesla V100 protz mit 5120 Shadern und einer TDP von 300W:

...dann feststellen, dass das lediglich eine Zahl ist und sie ohne weitere Details nichts aussagt.Muss aber natürlich nicht viel bedeuten, die Anzahl der Shader allein ist nicht entscheidend.

Mein persönlicher Held.