Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Radeon VII mit Vega 20: Laut AMD RTX-2080-Leistung für 699 USD ab 7. Februar

@scootiewolff22

Vom Strom merkt man schon ordentlich etwas, allerdings auch nur wenn man überall darauf achtet und eben entsprechende Nutzungsdauer hat.

War bei der 1080 für mich auch ein Kaufkriterium Performance/Watt, wenn gleich auch nur ein kleiner Teil der gesamten Summe - aber bare Münzen kamen bei mir in 3 stelligen Höhen zurück nachdem ich alles Stromfressende aussortiert habe (mit Ausnahme meines neuen Monitors nun ).

).

Viele haben Nachzahlungen, nur wenige Rückzahlungen - bei den ständigen Preiserhöhungen kommt eben auf Jahre gesehen eine riesen Urlaubs Summe zusammen.

Muss aber Jeder für sich selbst entscheiden was ihm wichtig ist und wofür er die Produkte überhaupt benötigt und ob es sich auch wirklich lohnt, rechnen lohnt sich aber oftmals.

Vom Strom merkt man schon ordentlich etwas, allerdings auch nur wenn man überall darauf achtet und eben entsprechende Nutzungsdauer hat.

War bei der 1080 für mich auch ein Kaufkriterium Performance/Watt, wenn gleich auch nur ein kleiner Teil der gesamten Summe - aber bare Münzen kamen bei mir in 3 stelligen Höhen zurück nachdem ich alles Stromfressende aussortiert habe (mit Ausnahme meines neuen Monitors nun

Viele haben Nachzahlungen, nur wenige Rückzahlungen - bei den ständigen Preiserhöhungen kommt eben auf Jahre gesehen eine riesen Urlaubs Summe zusammen.

Muss aber Jeder für sich selbst entscheiden was ihm wichtig ist und wofür er die Produkte überhaupt benötigt und ob es sich auch wirklich lohnt, rechnen lohnt sich aber oftmals.

.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.666

Ja- Weil AMD den API Support dafür auf Eis gelegt hat, bevor der überhaupt erschienen ist.SKu schrieb:Mit Turing kam ja auch Mesh Shading, quasi ein Pendant zu AMDs Primitive Shader - letzteres hat ja nie wirklich Anwendung gefunden.

Sie haben gesagt, dass sich die Programmierer selber ihre Pfade dafür schreiben müssen.

Zudem sind die Primitive Shader nur ein rudimentärer Vorgänger der Mesh Shader.

Es war klar, dass das Feature (leider) verhungert, wenn AMD selbst das ganze fallengelassen hat.

Es gab ja sogar Spekulationen, dass die Primitive- Shader Pipeline einen unkorrigierbaren Hardwarefehler hatte und die Technik deswegen fallengelassen wurde.

Verstanden hat das keiner so recht. Ich fand das aber immer schon schade.

[Allgemein]

Ansonsten zu den Karten. Schöne Technik, die das Umsetzt, was der Großteil der Kunden im RTX NVIDIA- Erscheinungsthread gefordert haben/fordern -> Mehr vom Alten, dafür schneller.

Wie ich aber schon immer schrieb und was aber keiner Wahrhaben will, ist, dass wir fertigungs-/designtechnisch an Grenzen stoßen, die nicht mehr so einfach zu umschiffen sind, wie bei den alten Generationen. Der Technologiewechsel ist unabdingbar, soll es in Zukunft wieder Leistungssprünge geben.

Es bestätigt zudem die Entwicklung, dass man sich langsam vom Gedanken verabschieden kann, die paradoxe Situation von früher (mehr Leistung, weniger Geld) noch als "Normalfall" anzusehen.

Fertigungskosten explodieren, Entwicklungskosten explodieren, DIE Größen steigen an und und und....

Grüße

Zero

Zuletzt bearbeitet:

Caramelito

Admiral

- Registriert

- Juni 2016

- Beiträge

- 9.111

das hat damit genau gar nix zu tun.BTICronox schrieb:Eine 780ti bricht bei The Division aber sowieso ein, unabhängig vom RAM. Meine 1080 bei entsprechender Auflösung übrigens auch.

Und was soll heißen "wäre gut gewesen mit mehr RAM"? Eine 1080 ist gut 2,5x schneller als eine 780ti, auch ohne entsprechende Auslastung des RAM.

Zu dem Zeitpunkt als die 780ti kam, waren 3gb VRAM ausreichend. 1-2j später gab es hier und da schon Problemchen. Darum geht es.

Meine 1080 bricht auch nicht ein, aber wenn man in 2019 700€ ausgibt und dafür nur 8gb VRAM mitnimmt, ist man selbst schuld

pupsi11

Banned

- Registriert

- Dez. 2008

- Beiträge

- 12.473

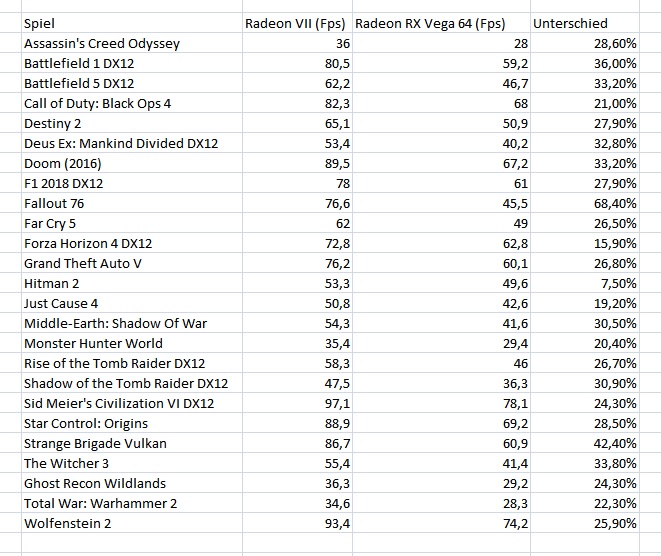

amd hat in einer mitteilung weitere games zwischen VII und vega 64 preisgegeben.

http://ir.amd.com/news-releases/new...eo-dr-lisa-su-reveals-coming-high-performance

http://ir.amd.com/news-releases/new...eo-dr-lisa-su-reveals-coming-high-performance

- Registriert

- Jan. 2018

- Beiträge

- 20.703

PhysoX512 schrieb:Die Radeon VII kann aber kein Raytracing, also sinnlos...

Und? Vor ein paar Jahren hielt man Grafikkarten mit Raytracing für überflüssig, jetzt ist es ein absolutes „must have“?

Laufen die Spiele nicht mehr ohne?

Minutourus

Lt. Commander

- Registriert

- Feb. 2003

- Beiträge

- 1.174

Wie viele doch sich wegen dem Strom Verbrauch als Aufhänger gegen AMD aufregen und auf der anderen Seite dann zb. n 380 Watt BIOS flashen und/oder diese bis zur Kotzgrenze übertakten inkl. CPU wobei der Verbrauch dadurch auch nicht gerade ohne ist und die Energieeffizient flöten geht...

Hatte früher mehrere Crossfire und SLI Konfigs die durchaus schön brav 800 Watt Plus gefressen haben (gesamt) und habe am Ende des Jahres nicht mal ansatzweise etwas bei der Abrechnung mitbekommen, eventuell wenn man 24*7 die GPU/CPU auf 100% laufen lässt, dann könnte man es vielleicht auch merken aber man sollte ab und zu die Kirche im Dorf lassen...

Aber bitte das ist auch meine persönliche Meinung, soll sich keiner dadurch angesprochen fühlen, ich berichte aus dem eigenen Bekannten Kreis wo genau so etwas vorgekommen ist bis ich mal ein Strom Messgerät angehängt habe und die Gesichter immer länger wurden...

Die 16GB VRam sind mal Top, für mich würde auch die Leistung auf 2080 Niveau reichen, Strom Verbrauch vernachlässigbar, gibt andere Baustellen wo man mehr Strom über das Jahr sparen könnte...

Abwarten und Tee trinken bis die Tests kommen..

Wünsche euch noch einen schönen Abend..

Hatte früher mehrere Crossfire und SLI Konfigs die durchaus schön brav 800 Watt Plus gefressen haben (gesamt) und habe am Ende des Jahres nicht mal ansatzweise etwas bei der Abrechnung mitbekommen, eventuell wenn man 24*7 die GPU/CPU auf 100% laufen lässt, dann könnte man es vielleicht auch merken aber man sollte ab und zu die Kirche im Dorf lassen...

Aber bitte das ist auch meine persönliche Meinung, soll sich keiner dadurch angesprochen fühlen, ich berichte aus dem eigenen Bekannten Kreis wo genau so etwas vorgekommen ist bis ich mal ein Strom Messgerät angehängt habe und die Gesichter immer länger wurden...

Die 16GB VRam sind mal Top, für mich würde auch die Leistung auf 2080 Niveau reichen, Strom Verbrauch vernachlässigbar, gibt andere Baustellen wo man mehr Strom über das Jahr sparen könnte...

Abwarten und Tee trinken bis die Tests kommen..

Wünsche euch noch einen schönen Abend..

- Registriert

- Jan. 2018

- Beiträge

- 20.703

Und wieder einmal spielen wir unser gefährliches Spiel. Ein Schachspiel gegen unseren wohlbekannten Gegner: die amerikanische nvidia.

Jahrelang haben eure Kollegen und Vorgänger dieses Spiel gespielt, und sie haben es gut gespielt.

Aber heute hat sich das Spiel verändert. Das erinnert mich an die herrlichen Zeiten einer Radeon 9700, als die Welt vor dem Klang unserer leisen Lüfter erzitterte. Und sie wird wieder erzittern, beim Klang unserer tech. Daten. - frei nach „Jagd auf Roter Oktober“

Jahrelang haben eure Kollegen und Vorgänger dieses Spiel gespielt, und sie haben es gut gespielt.

Aber heute hat sich das Spiel verändert. Das erinnert mich an die herrlichen Zeiten einer Radeon 9700, als die Welt vor dem Klang unserer leisen Lüfter erzitterte. Und sie wird wieder erzittern, beim Klang unserer tech. Daten. - frei nach „Jagd auf Roter Oktober“

.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.666

Ja- Letztenedes können moderne Grafikkarten, wenn man deren Compute-Fähigkeiten nutzt, alle entsprechende Berechnungen durchführen.IXI_HADES_IXI schrieb:Heißt also auch AMD kann ganz klar Raytracing. Die Frage ist nur wie schnell. Zumindest da eine RTX 2080 TI solche Cores besitzt finde ich es mehr als lachhaft gegen eine Titan V schlecht dazustehen die keine solchen Raytracingkerne hat.

Ist alles nur eine Frage der Geschwindigkeit.

Nur ist die TitanV trotz irrwitziger Shaderzahl deutlich langsamer mit RT on als eine 2080TI.

Nur nicht so deutlich, weil gerade BFV ein Shader- Monster ist.

Da auch RT Berechnungen auf die Shader angewiesen sind, kann in der derzeitigen Form der Engine keine höhere Geschwindigkeit erreicht werden. Würde man die Software von Anfang an mit RT im Hinterkopf programmieren, würde der Abstand 2080 deutlich ansteigen...

Grüße

Zero

Ergänzung ()

RT wurde in Battlefield nie heruntergeschraubt. Man hat nur durch einen Sortieralgorithmus geschaffen, die Strahlen, die keine Chance haben einen Treffer zu landen gar nicht erst abzuschiessen, sondern auf die Bereiche zu konzentrieren, wo eine hohe Abtastung Sinn ergibt.Chismon schrieb:(fuer Battlefield V etwa nachtraeglich herunter geschraubter) Umsetzun

Die prozentuale Anteil der Bildpunkte, die mit RT maximal erfasst werden und der specular threshold sind von Anfang an immer gleich gewesen.

Grüße

Zero

Ergänzung ()

Man muss da ein wenig differenzieren. Ich denke auch, dass die Konsolen mit 16GB Hauptspeicher kommen könnten. Allerdings gibt es auch bei Konsolen inzwischen ein immer mehr aufgeblähtes OS im Hintergrund und zudem stehen ja nicht die vollen 16GB als Grafikspeicher zur Verfügung. Der Programmcode, der ja auch erheblich Speicher frisst, muss ja auch noch irgendwo hin.vatikan666 schrieb:Die neuen Konsolen werden aus Architekturgründen wohl auch so viel Speicher haben und der wird definitiv genutzt werden. Bei AMD war der Speicher btw immer in etwa so was auch maximal gebraucht wird, bei Nvidia dagegen bei günstigen Modellen immer zu wenig oder zu sehr auf Kante, weswegen man die Karten nach 1 Jahr entsorgen muss. Interessiert komischerweise immer nur niemand. Wünsch den Leuten mit 6 GB oder 4 GB Karte jedenfalls viel Spaß, wohlgemerkt Neukauf bei Nvidia im Jahr 2019.

Grüße

Zero

Zuletzt bearbeitet:

Verak

Banned

- Registriert

- Sep. 2004

- Beiträge

- 2.346

SKu schrieb:Herzlichen Glückwunsch, natürlich pickst du die Spiele heraus, die auch sehr gut auf AMD laufen

Ich hab da gar nichts rausgepickt. Ich hab im Post #437 nur deine schwachsinnige Aussage hier widerlegt das 90% der Games unter Nvidia besser laufen und dies chronologisch mit den 10 letzt veröffentlichten AAA Titeln.

SKu schrieb:Nvidia hat AMD im Prinzip schon die Show vermasselt als sie den Support für Adaptive Sync bekannt gegeben haben. Hinzu kommt noch, dass gut 90% der Spiele in aller Regel schneller auf Nvidia GPUs laufen - gerade auch bei Spielen mit Unity oder Unreal Engine.

.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.666

Gab vor etlichen Jahren Grafikkarten mit Tseng- Labs Chip und:SIM Sockel.Cool Master schrieb:Bei der 2060 wird gemeckert es ist zu wenig hier wird gemeckert es ist zu viel... Am besten wir stellen einfach alle Grafikkarten ein und setzen nur noch auf iGPU die auf den normalen RAM aufbauen da kann sich dann jeder selber so viel rein stecken wie er will :X

Da konnte man einfach nen RAM Riegel reinstecken und schon hatte man mehr VRAM.

Eigentlich keine schlechte Sache. So könnte jeder selbst entscheiden, wieviel VRAM er auf seiner Karte haben möchte....

GDDR- Chips einfach sockeln und austauschbar machen.

S

Sinthuria

Gast

Das wäre mal eine klasse Entwicklung oder Neuerung.

Aber zum Thema: Man kann sich noch lang genug virtuell die Köpfe einschlagen, wie es hier zum Teil passiert. Das bringt nur nichts.

Vonden Daten liest sich das ganze erst einmal ganz gut. Aber letztendlich muss man abwarten. Wenn sie in etwa die gleiche Leistung wie die RTX 2080 bietet, würde ich der AMD wohl auch den Vorzug geben. Zwar sind 16 GB überzogen und mit sicherheit wird eher der Chip limitieren als dass man 16 GB wirklich benötigt, aber 8 GB sind eben deutlich weniger und lassen sich bestimmt ziemlich gut füllen bzw können wesentlich schneller limitieren. Aber wie gesagt erst einmal abwarten und schauen wie sich die Karte wirklich schlägt.

Aber zum Thema: Man kann sich noch lang genug virtuell die Köpfe einschlagen, wie es hier zum Teil passiert. Das bringt nur nichts.

Vonden Daten liest sich das ganze erst einmal ganz gut. Aber letztendlich muss man abwarten. Wenn sie in etwa die gleiche Leistung wie die RTX 2080 bietet, würde ich der AMD wohl auch den Vorzug geben. Zwar sind 16 GB überzogen und mit sicherheit wird eher der Chip limitieren als dass man 16 GB wirklich benötigt, aber 8 GB sind eben deutlich weniger und lassen sich bestimmt ziemlich gut füllen bzw können wesentlich schneller limitieren. Aber wie gesagt erst einmal abwarten und schauen wie sich die Karte wirklich schlägt.

nicK--

Captain

- Registriert

- Aug. 2004

- Beiträge

- 4.060

RB6istGut schrieb:Hi, ich hab nen 6700k und bevor ich mir nen 9900k kauf gewöhn ich mir lieber das Zocken ab. Aber schön dass du alle, die mit Tatsachen kommen, unter pauschalverdacht stellst komplette Heuchler zu sein.

Warum ists für manche Menschen so schwer zuzugeben, dass etwas stimmt, das auf Fakten und Zahlen basiert?

Die Karte ist etwas ineffizient und daher nicht so beeindrucken, wie sie hätte sein können. Wir haben uns von 7nm mehr erwartet.

Vermutlich ist die Vega Architektur einfach eine Einbahnstraße?!

Oder willst du mir was andres erzählen?

Hier im Forum hat einer 43€ im jahr unterschied vorgerechnet bei mäßig intensiver Nutzung.

Solange Papa/Mama den Strom zahlen ist das kein Argument, da haste Recht...Für jeden vernunftbegabten und verantwortungsvollen Menschen jedoch, sollte etwas ökonomischeres und damit ökologischeres Herangehen an solche Überlegungen durchaus als zumutbar betrachtet werden.

Weiß nicht ob das Argument so zieht,

ich vergleiche beim Sportwagen auch nicht was der verbraucht sondern wie die Leistungen sind und ob der Wagen das bietet was ich brauche. Was kümmert mich ob die Konkurrenz 2L weniger braucht wenn es nicht das ist was ich brauche und haben will. 43€ auf ein ganzes Jahr sind praktisch nichts... viele Menschen gehen nach Ikea und brauchen nur ein Teil und kommen mit 6 raus ... das bitter ....

R

RB6istGut

Gast

der mehrverbauch ist ja kein nogo, aber wenn die Leistung gleich ist, sollte er schon miteinbezogen werden in die entscheidungsfindung.

Dass 40€ als ncihts bezeichnet werden, finde ich etwas pikant.

Dass 40€ als ncihts bezeichnet werden, finde ich etwas pikant.

T3rm1

Lieutenant

- Registriert

- Nov. 2005

- Beiträge

- 792

Du bist ein ahnungsloser Troll und solltest dein Leben in den Griff bekommen oder vernünftig argumentieren, warum Raytracing auch nur annähernd relevant sein sollte in den nächsten zwei Jahren.PhysoX512 schrieb:Die Radeon VII kann aber kein Raytracing, also sinnlos...

Berserkervmax

Banned

- Registriert

- Apr. 2004

- Beiträge

- 3.118

Das heist AMD hast jetzt entlich ne 1080TI gebaut bzw die Leitung einer RTX 2080 geschafft

die 1080TI ist wann erschienen ? Anfang 2017?

Zumindes 16GB VRam das ist mal eine Ansage !

die 1080TI ist wann erschienen ? Anfang 2017?

Zumindes 16GB VRam das ist mal eine Ansage !

Daniel1337

Lieutenant

- Registriert

- Jan. 2014

- Beiträge

- 936

Im Mindstar wird ja zur Zeit eine Karte nach der anderen rausgehauen. Die aktuellen Generationen scheinen wohl nicht gerade der Kassenschlager zu sein.

.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.666

Wie oben bereits schon einmal von mir angesprochen. Die 16GB der Konsolen werden durch das Betriebssystem und dann das Programm selbst stark beschnitten. Die 16GB stehen nicht dediziert Texturen zur Verfügung, sondern ein deutlich geringerer Anteil.AlanK schrieb:Spätestens ab der Playstation 5 werden wieder sehr viele Titel so entwickelt das sie mit 8GB, geschweige 6GB nicht klar kommen und 16GB bei 4k und ähnlichen Auflösungen verlangen.

Daher könnte es jetzt der richtige Schritt sein doch auf 16GB zu warten.

Und wie auch schon einmal erleutert:Irgendwann gibt es auch beim VRAM eine Sättigung, nämlich dann, wenn Du den gesamten Bildschirm mit hochaufgelösten Asset- Texturen vollgeladen hast. Es steht auflösungsbedingt nunmal nur eine gewisse Anzahl an Pixeln zur Verfügung, um diese zu "tapezieren".

Texturen werden zwangsweise zudem entweder per Format (Mip Maping), oder durch die GPU in LOD Stufen unterteilt, so dass die meisten Texturen erst garnicht in voller Auflösung in den VRAM geladen werden müssen.

Zudem geht der weg weg von Atlas- Texturen zum virtual- Texturing, welches wiederum Effizienzvorteile hat (bandbreitenschonend, qualitativ bessere Texturen und speichereffizient).

Somit ist in diesem bereich der "viel hilft viel"- Ansatz nicht durchgängig gültig.

Beruhigt kann man bei den 16GB dahingehend sein, als dass man davon ausgehen kann, dass diese Speichergrenze auf unbestimmte Zeit nicht gesprengt werden wird.

Zuletzt bearbeitet:

Compu-Freak

Banned

- Registriert

- Dez. 2018

- Beiträge

- 705

Ich wollte mir eigentlich eine 2080 kaufen. Aus Protest wegen der Preispolitik habe ich es seingelasen.

Die Radeon VII gefällt mir wegen den 16 GB Ram. Bei 600,- euro kaufe ich sie mir.

Die Radeon VII gefällt mir wegen den 16 GB Ram. Bei 600,- euro kaufe ich sie mir.

.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.666

Dazu schonmal ein wenig anschauliche Lektüre:Cpt.Willard schrieb:Werde mich aber interessehalber, am langen We, mal mit der Situation im Vergleich zu den letzten Jahren auseinandersetzen, vllt. Kommt dann mehr Akzeptanz.

https://www.extremetech.com/computing/272096-3nm-process-node

https://semiengineering.com/how-much-will-that-chip-cost/

Grüße

Zero