Anisotrope Filterung im Test: AMD und Nvidia opfern Qualität für Leistung

Einleitung

Der anisotrope Filter gehört seit langer Zeit zu einer modernen Grafikkarte dazu. Während er vor etlichen Jahren mit einer simplen und dennoch durchaus bereits effektiven zwei-fachen Filterung angefangen hat, folgte der erste große Entwicklungsschritt mit einer acht-fachen Filterung, die mehrere Jahre lang halten mussten. Mittlerweile sind die Karten bei einer 16-fachen Filterung angelangt, die in den meisten (aber nicht allen) Szenen ausreichend ist.

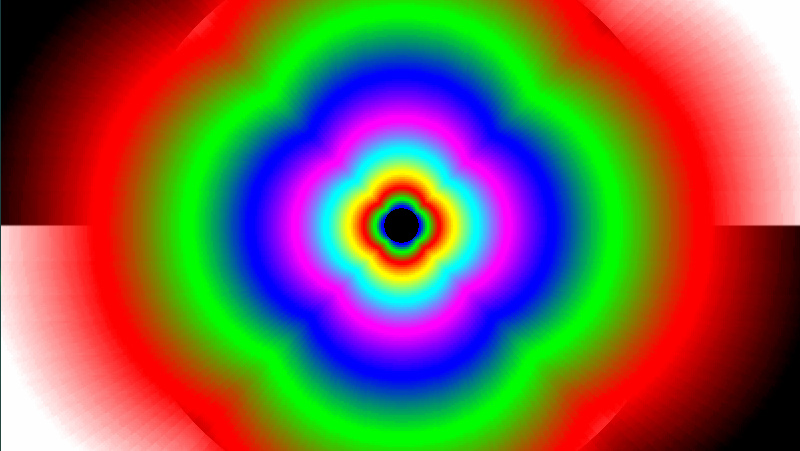

Anders als bei der MSAA-Kantenglättung gibt es beim anisotropen Filter diverse Möglichkeiten, diesen in die Hardware und nur in den Treiber zu implementieren. Da ein perfekter Filter-Algorithmus allerdings sehr teuer wäre (sprich viele Transistoren benötigt) und zudem die Texturfüllrate zum Frühstück verspeisen würde, haben sowohl ATi als auch Nvidia so genannte „Optimierungen“ eingebaut, die die Geschwindigkeit verbessern, gleichzeitig aber die Bildqualität mindern.

Die Anzahl der möglichen Optimierungen ist groß, weshalb auch das Endergebnis bei beinahe jeder GPU-Generation anders aussieht. Dabei hat der Hersteller die Wahl, entweder weniger Performance zu verlieren und dafür eine nicht ganz so gute Qualität zu liefern, oder genau die gegenteilige Strategie zu fahren. Aus Sicht der Hardwarehersteller hat beides seine Vor- und Nachteile, den für die Kunden und den Hersteller goldenen Mittelweg scheint es (zumindest derzeit) noch nicht zu geben.

In diesem Artikel beschäftigt sich ComputerBase nun mit dem aktuellen Stand der Dinge, sprich mit den Optimierungen auf den Grafikchips RV7x0 und GT200, die bei der Radeon-HD-4000- beziehungsweise der GeForce-GTX-200-Serie eingesetzt werden. Wer bietet die bessere Bildqualität? Und wer verliert am wenigsten Rechenleistung? Das klären wir auf den nächsten Seiten.