Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Test 3DMark Steel Nomad im Test: Das kann der neue Benchmark und so schnell läuft er

- Ersteller Jan

- Erstellt am

- Zum Test: 3DMark Steel Nomad im Test: Das kann der neue Benchmark und so schnell läuft er

TheInvisible

Commander

- Registriert

- Jan. 2022

- Beiträge

- 2.112

4090 lässt die Muskeln spielen, so eine Skalierung wäre in Games auch immer nett

- Registriert

- Juli 2021

- Beiträge

- 3.798

Doch, genau DAS war die Neuerung von Turing. Man halbierte die Shader-Kerne pro SM von 128 in 4 Tiles auf 64 + 64. Entsprechende Grafiken und die Thematik habe ich. bereits aufgearbeitet: https://www.computerbase.de/artikel...-2#abschnitt_pascal_vs_turing_radikaler_umbauDark Soul schrieb:Ja, aber diese können nicht parallel zusätzlich zu FP32 ausgeführt werden?

Bereits seit Tesla - GeForce 8800 GTX - gibt es für CUDA verschiedene Datentypen, darunter auch INT. Bis einschließlich Pascal konnten die GeForce-Grafikkarten aber nicht von Asynchronen-Shadern - als Beispiel - profitieren, weil die gesamte SM an einen Datentyp gebunden war, damit mussten alle 4 Tiles bei Pascal die WARPs mit FP oder alle 4 Tiles WARPs mit INT bearbeiten.Dark Soul schrieb:Dachte Turing hätte da nur die Möglichkeit erhalten INT32 und FP32 in der selben Einheit zu rechnen.

Alles, was du schreibst, ist weitgehend falsch.Dark Soul schrieb:In einem SM können also maximal 64 Operationen ausgeführt werden - statt wie vorher nur 64xFP32, geht nun zB: 10xINT32 und 54xFP32 - oder stimmt das nicht?

In Pascal können 8 WARPs (Operationen) zu 32 Werten/Tasks/Threads ausgeführt werden. In Pascal gibt es ein "Datenpfad", wodurch die SM an einen Datentyp gebunden ist. Eine SM kann also 8 FP-Operationen durchführen zu 32 Werten.

Mit Turing wurden die 4 Tiles der SM beibehalten, nur dass die vier Tiles nicht mehr aus 32 Skalaren-Units bestehen, die alle die gleiche Operation ausführen, sondern aus 16 Skalaren-Units, die an einem Datenpfad hängen und weiteren 16 Skalaren-Units, die an einem zweiten Datenpfad hängen. Es können jetzt 8 WARPs ausgeführt werden, von denen 4 WARPs den Datentyp INT haben können, die anderen 4 können wie bisher FP oder INT haben. Der zweite Datenpfad ermöglicht es jetzt, dass ohne Kontextswitch - der bisher notwendig war - zwei Datentypen verarbeitet werden können.

Das war bei Pascal so, die die ganze SM war an einen Datentyp gebunden, für einen anderen Datentyp musste ein Kontextswitch erfolgen. Der fällt weg.Dark Soul schrieb:Bis hier hin ok - aber eben, man hat 64 Einheiten und die Rechnen entweder float oder int.

Und was du im Kopf hast, ist weitgehend falsch. Siehe dazu die Grafiken für die SM.Dark Soul schrieb:Haha ebenTuring kann wenn ich es eben richtig im Kopf habe nicht doppelt so schnell sein. Denn eine Einheit kann entweder FP32 oder INT32.

Falsch. 4 * FP, 4 * INT bei Turing, bei Pascal waren es 8 * FP. Seit Ampere sind es 8 * FP oder 4 * FP + 4 * INT.Dark Soul schrieb:Bei Turing hat man wie oben erwähnt FP32 oder INT32. Bei Ampere hat man diesen Block wohl um einen weiteren FP32 Pfad erweitert. Somit geht 2xFP32, 1x FP32 & 1x INT32 oder nur 1x INT32.

Doch, genauso wie ich es schreiben ist es richtig.Dark Soul schrieb:Somit stimmt aber eben diese Aussage nicht? Ist erst ab Ampere wahr. Bei Arc keine Ahnung - hatte ich noch nie in den Händen

Dafür, dass du mir hier unterstellst, dass ich falsch liege, lieferst du nur hier nur Halbwissen aus dem Kopf und weite Teile deiner Eklärungen passen so gar nicht zum SIMT/SIMD-Prinzip.

Hast recht, war aus Versehen in der Time Spy Spalte.Epistolarius schrieb:Ich sehe im Test nicht, wo sich RDNA3 von Ada absetzen kann.

Zuletzt bearbeitet:

Keine Ahnung was du da installiert hast aber das sollten mehrere Gigabyte sein.SupaKevin schrieb:Wollte gerade nochmal TimeSpy laufen lassen. Nach der 3DMark installation (nur 3 MB) bekomme ich eine Fehlermeldung beim Starten.

Timespy allein hat bei mir laut Steam schon 1,8GB.

Die Fehlermeldung sagt ja auch, dass der Benchmark selber nicht installiert ist.

Kannst sonst alternativ ja den Download von hier nehmen.

https://www.computerbase.de/downloads/benchmarks/ul-3dmark/

AthlonXP

Captain

- Registriert

- Apr. 2003

- Beiträge

- 3.291

ich würde für den kurzen test auch schnell mal den 3dmark hier von computerbase ladenSupaKevin schrieb:Hat wer so spontan eine Idee an was das liegt?

der Unzensierte

Vice Admiral

- Registriert

- Juni 2009

- Beiträge

- 7.146

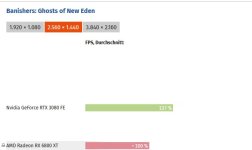

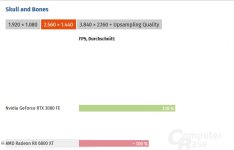

Wenn denn die Ergebnisse von RDNA2 so ausfallen wie CB festgestellt hat dann bildet der Benchmark schon einmal nicht die Realität ohne RT ab. Denn da ist eine RTX3080Ti sicher nicht um 26% vor einer RX6950XT. Eine RX6800XT liegt in der Realität ja auch mehr oder weniger auf einem Niveau mit der RTX3080.

Nope: "High-End-Hardware ohne Raytracing-Einsatz", gleich unter der Headline.Crifty schrieb:Raytracing?

- Registriert

- Feb. 2009

- Beiträge

- 10.913

Ich würde das nicht alternativ sondern bevorzugt vorschlagen.gustlegga schrieb:Kannst sonst alternativ

Zuerst Steam aufzustarten um einen Benchmark durchzuführen spricht gegen jegliche regeln der Vernunft.

Zumal die Standalone version auch einen integrierten Updated hat!

Dieses Jahr hat es aber schon etliche male ziemlich mau ausgesehen....gleichauf sehe ich da nix.....der Unzensierte schrieb:Eine RX6800XT liegt in der Realität ja auch mehr oder weniger auf einem Niveau mit der RTX3080.

Tornavida

Banned

- Registriert

- Okt. 2020

- Beiträge

- 6.298

Bei PCGH liegt die 4080 S 7-9 % vor der 7900xtx und die 4070ti S 8-11% vor der 7900xt bei diesem aktuellen Rasterbenchmark. Erst mit 400W OC kommt die 7900xtx an der 4080 S stock hauchdünn vorbei.

Bin auf die Communitybenches gespannt ,da sich die Werte/Tendenzen ja doch stark unterscheiden und hier auf CB die 7900xtx wie man es erwarten würde vorne liegt.

Bin auf die Communitybenches gespannt ,da sich die Werte/Tendenzen ja doch stark unterscheiden und hier auf CB die 7900xtx wie man es erwarten würde vorne liegt.

Steel Nomand ist nur Rasterising.Crifty schrieb:Raytracing?

- Registriert

- Feb. 2009

- Beiträge

- 4.593

@Jan, ich finde es eigenartig, dass im Diagramm "3DMark Steel Nomad (DirectX 12)" der i3 konstant mit jeder Grafikkarte ein paar Punke vorne liegt. Der einzige vorteil vom i3 ist der 300MHz höhere Basis takt. Da der Benchmark aber vermutlich nicht alle Cores nutzt sollte der Boost des i9 höher sein als Boost des i3.

Gibt es da ne Erklärung für?

Gibt es da ne Erklärung für?

Millennial_24K

Lt. Commander

- Registriert

- Dez. 2021

- Beiträge

- 1.636

Dass der Intel Core i3 in dem Benchmark sehr gut performt, liegt auch an DX12 und die Abwesenheit von Raytracing. Den Messwerten zufolge würde er die RTX 4090 selbst in WQHD mit ausreichend FPS beliefern.

Zuletzt bearbeitet:

@Jan

Zusammen mit Steel Nomad kommen auch 5 neue Achievements:

Ray tracer

Run all Ray Tracing benchmarks (Speed Way, Port Royal, Solar Bay).

Great Upscaler

Run two of the three upscaling feature tests (DLSS, FSR, XeSS).

Catchy Tune

Deliver a result of Steel Nomad with audio.

Steel Explorer

Use Explorer Mode to discover all secret areas in the world of Steel Nomad with all its hidden treasures.

Sun and Moon

Run Steel Nomad during the day (06:00 - 18:00), and Steel Nomad Light during the night (18:00 - 06:00).

Diese werden laut UL zusammen mit Steel Nomand scharf geschalten.

Quelle:

https://steamcommunity.com/app/223850/discussions/0/6197594259713743676/

Zusammen mit Steel Nomad kommen auch 5 neue Achievements:

Ray tracer

Run all Ray Tracing benchmarks (Speed Way, Port Royal, Solar Bay).

Great Upscaler

Run two of the three upscaling feature tests (DLSS, FSR, XeSS).

Catchy Tune

Deliver a result of Steel Nomad with audio.

Steel Explorer

Use Explorer Mode to discover all secret areas in the world of Steel Nomad with all its hidden treasures.

Sun and Moon

Run Steel Nomad during the day (06:00 - 18:00), and Steel Nomad Light during the night (18:00 - 06:00).

Diese werden laut UL zusammen mit Steel Nomand scharf geschalten.

Quelle:

https://steamcommunity.com/app/223850/discussions/0/6197594259713743676/

Zuletzt bearbeitet:

- Registriert

- Aug. 2011

- Beiträge

- 13.207

Auf Grund dessen:

Andererseits hat AMD genug Infos zur RDNA2-Architektur und Hinweise, wie man darauf optimieren kann, unter veröffentlicht. Aber ich möchte ja auch UL Software nix falsches unterstellen, bestimmt haben sie ihr bestes gegeben, um den Benchmark zu implementieren.

Könnte eine Lösung auch sein, dass es hier wirklich ein Problem bei RDNA(2) gibt und AMD per Treiber-Update dem auf die Sprünge helfen wird.Derzeit im Vergleich zu Time Spy deutlich ins Hintertreffen geraten die Radeon RX 6950 XT sowie die Radeon RX 6700 XT auf Basis von RDNA 2.

Andererseits hat AMD genug Infos zur RDNA2-Architektur und Hinweise, wie man darauf optimieren kann, unter veröffentlicht. Aber ich möchte ja auch UL Software nix falsches unterstellen, bestimmt haben sie ihr bestes gegeben, um den Benchmark zu implementieren.

- Registriert

- Juli 2021

- Beiträge

- 3.798

An der Stelle ist es schwer, dafür müsste man mit den Devtools von AMD oder Nvidia mal die Aufrufe vom Benchmark an den Treiber und Grafikkarte prüfen und was da alles ankommt. Damit könnte man dann sich ansehen, woran das liegt und ob hier einfach von Ampere und Ada sowie eben RDNA 3 das mehr an Shader/Dual-Issues besser genutzt wird und daher RDNA 2 einfach zurück fällt.Faust2011 schrieb:Aber ich möchte ja auch UL Software nix falsches unterstellen, bestimmt haben sie ihr bestes gegeben, um den Benchmark zu implementieren.

Millennial_24K

Lt. Commander

- Registriert

- Dez. 2021

- Beiträge

- 1.636

Deine These bezüglich der Dual-Issue Recheneinheiten ist sehr wahrscheinlich. Mit Sicherheit hat der Entwickler die Fähigkeiten der neusten GPU-Architekturen in die Programmierung des neusten Rasterizing-Benchmarks einfließen lassen. Das heißt RDNA 2 hat demzufolge etwas das Nachsehen.DevPandi schrieb:Damit könnte man dann sich ansehen, woran das liegt und ob hier einfach von Ampere und Ada sowie eben RDNA 3 das mehr an Shader/Dual-Issues besser genutzt wird und daher RDNA 2 einfach zurück fällt.

Zuletzt bearbeitet:

DarkSoul

Commander

- Registriert

- Aug. 2008

- Beiträge

- 2.855

Irgendwie schade, dass es keine kostenlosen Versionen mehr gibt, oder täusche ich mich da?gustlegga schrieb:letzes Jahr mal im Sale zugeschlagen

Und wann gibt es den Sale? Zur Black Friday-Zeit?