VaniKa schrieb:

Das ist ja eben der Grund für die Kalibrierung mittels Test-Programm wie "DisplayHDR Test". Das ist ja nichts anderes als die Logo-Kalibrierung in Spielen. Damit kann man einmalig zum Gerät mit den aktuellen Einstellungen (möglichst im HGiG-Modus, damit das Tone-Mapping nicht dazwischenfunkt) die Nit-Obergrenzen für den 10-%- und 100-%-Weiß-Test ermitteln, also ab wann es ins Clipping geht.

Oh man .. du hast absolut recht ... ich hatte das VESA Dsiplay HDR Tool bzgl der anderen Tests ( ausser dem Viereck Test ) dort immer nur in Verbindung mit einem Colormeter gesehen.

Ich glaub ich muss doch nochmal anfangen mich damit nochmal genauer auseinander zu setzen

hatte die ganze Geschichte nun eigentlich für mich abgeharkt als "alles passt" aber

du hast ja recht das man mit dem Tool die Settings ja überprüfen kann per Sicht Prüfung.

Also 10 % Weiss und 100 % Weissbild sagst du soll man drauf achten ?

Und wie merkt man dann das es dort dann clipping gibt ?

( Sorry falls du das schonmal geschrieben hattest )

Bei den SchwarzViereck Test is das ja relativ einfach zu sehen sowie auch bei dem

Bunten Viereck Test was Jason aus dem AVS genommen hat was aber auf

einer Kalibier CD in Video Form vorhanden ist.

Oh man .. hätte auch nich gedacht das ich nun zu einem "Kalibrirer" werden

wobei das ja nur der Grundkurs is damit bin ich fein ... aber ich will nich zu

den gehören die nun da penible alles mit dem Colormeter abchecken und dann bei

Rot auf -3 und Blau +5 usw gehen. Hab das bisher immer Frei schnauze gemacht.

Aber hier mach ich mal ne kleine Ausnahme und schau mir zumindest diese Clipping

Geschichte nochmal genauer an.

VaniKa schrieb:

Ich möchte halt vermeiden, immer an dem Regler herumspielen zu müssen, daher möchte ich da lieber ein gutes Mittelmaß finden. Toll wäre natürlich, wenn man auch pro Anwendung die SDR-Helligkeit regeln könnte, sodass z.B. bei Filmen im Vollbild die Helligkeit höher ausfiele als auf dem Desktop.

Mein Mittelmass is mom 20 ... ich musste mal auf 0 weil da irgendwas nich stimmte .. das war so die anfangs Zeit wo ich begonnen hab mich damit zu befassen hier im Thread.

Erst war 40 ok dann musste ich mal auf 0 gehen und irgendwas hatte ich dann geändert in CRU oder so

und seit dem passt 20 bisher nun so ziemlich gut für mich.

Aber wie du auch gesehen hast nehmen manche auch 0 oder 12 ... hattest du ja in dem Bild gesehen wo

es um den Stromverbrauch ging.

VaniKa schrieb:

Wo ich gerade darüber nachdenke, wenn ich HGiG nutze und du dynamisches Tone-Mapping, dann ist dein Bild ja bei ansonsten gleichen Einstellungen deutlich heller als meines, also auch beim Desktop. D.h. dass meine 40er-Einstellung beim SDR-Regler ggf. gar nicht so viel heller ist als deine 20er-Einstellung, bzw. meine 20er-Einstellung deutlich dunkler als bei dir.

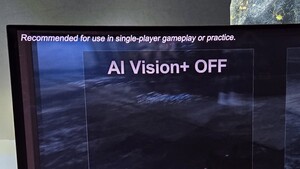

Das kann gut sein ... aber ich wechsel halt auch mal auf HGIG .. hatte gesagt ich bin da so 80:20

je nach Game. Aber gute Beobachtung !!

Werd da nacher mal schauen ob es einen unterschied macht .. hatte da bisher nich drauf geachtet

sondern halt einfach auf 20 gelassen.

VaniKa schrieb:

und eben auch nicht ständig zwischen HGiG und dynamischem Tone-Mapping hin und her wechseln möchte.

Ich hab da kein Prob mit ,, zur Not geht das sogar mit 2 - 3 Maus Clicks wenn man Color Control verwendet.

Ich mach das aber mit der Fernbedienung.

VaniKa schrieb:

Ja, ich bin da zwar nie drauf eingegangen, aber ich habe den Slider schon benutzt und finde die maximale Intensität am besten. Ich bin mir aber nicht sicher, ob das nicht auch die Standardeinstellung ist.

Ne Standart war damals bei mir Mitte mein ich ... sofern ich mich recht erinnere war der Slider auf der Mitte als ich ihn das erste mal angeschaltet hatte.

VaniKa schrieb:

Ohne den Regler je berührt zu haben, ist da ja noch gar keine Einstellung sichtbar. Vom ersten Eindruck her würde ich sagen, war Default und Maximum eigentlich ziemlich gleich. Aber das kann auch täuschen, wenn man keinen direkten Vergleich hat,

Also wenn ich dich nun richtig verstehe siehst du keinen Unterschied wenn du den Auto HDR Regler verstellst ?

VaniKa schrieb:

(Weißt du, wie man den Wert wieder auf Default zurücksetzt beim jeweiligen Spiel? Ist vermutlich irgendein Wert in der Registry.)

Ehrlich gesagt kann ich dir da grad nich ganz folgen ... bist du noch beim Auto HDR Slider ?

Is das nich egal was da Default war ?

OK grad nochmal geschaut .. ich war nun die ganze Zeit über mit HGIG unterwegs und da passt 20.

Bei Dynamisches Tone Mapping an muss ich auf 10 - 15 runtergehen damit das Bild in etwa dem Bild von OLED Light 35 gleich is.

Ich bin aber auch bei "Fine Tune Dark Areas" ( Feineinstellung Dunkler Bereiche ) auf -5

Das is ja wegen dieser VRR Black Crush Geschichte.

Ich würde natürlich auch lieber ein helleres Bild in SDR haben aber ich mach das ja aus einem Grund so dunkel eben als Vorbeugung gegen den Burn Out. Da bist du ja anders drauf und nich so vorsichtig wie ich.

Aber so war ich anfangs auch mal drauf bis dann das umdenken kamm. Hatte vorher auch bei SDR immer OLED light 100.

Aber Ich möchte ( falls der 42" OLED nix wird bzgl der 1000 Nits ) den 48CX für 5 Jahre nutzen

erst dann kommt ein neuer ... daher muss ich mit ihm schonend umgehen.

Ich nutze den OLED aber nun seit Juni 2021 für alles ( Surfen , Youtube , Gaming , Filme )

hatte den 48CX von Juni 2020 - Juni 2021 aber auch nur fürs Gaming genutzt.

Aber nun nach 1 Jahr schonfrist nutze ich ihn für alles ... und der alte BenQ wird nur noch

angemacht wenn der OLED seinen kleinen Pixel Refresh nach 4 std machen muss.

So siehts bei meinem 48CX momentan aus :

2530 Betriebsstunden

553 Kleine Pixel Refreshes

1 Großer Pixel Refresh

2530 : 553 = 4,57 ... also alle 4,57 std läuft bei mir der kleine Refresh.