QUOTE="Tanzmusikus, post: 28965197, member: 513461"]

Entweder ist die SpieleEngine global auf 200FPS begrenzt ... es gibt ein FPS-Limit (MSI AB, Radeon-Software, usw.) ... oder der R5 3600 schafft einfach nicht mehr.

[/QUOTE]

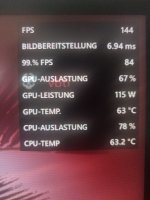

Wie kommst auf die 200 FPS? Ich komme doch nicht über 120 FPS. Denke aber, dass wie du schreibst die CPU ist der limitierender Faktor.

MehlstaubtheCat schrieb:

Der 5800X3D kann man leicht Undervolten was dazu noch Leistung bringt und die 6900XT auf 250 Watt beschränken und mit dem MorePowerTool, auch Undervolten.

Dann sollte das auch bei deinem Netzteil locker gehen.

Das wäre super, da ich Softwaremäßig kein Genie bin. Die Graka habe ich mittlerweile auf 250-260W

Tanzmusikus schrieb:

Ich hab meinen 5800X3D sogar auf nur 100W limitiert. So könntest Du nochmals mehr für die GPU rausholen.

Natürlich RAM-OC und CurveOptimizer -30 vorher eingestellt.

Ansonsten finde ich, 200FPS sind schon extrem viel FPS. 🤓👍

Bin aber auch SinglePlayer-Spieler. 😉

Habe mich irgendwo vertippt? Warum schreibt ihr alle was vom 200 FPS 😯

Mein Monitor schafft 144Hz und übertaktet 165Hz, das reicht mir auch.

Reich nicht UV bei der graka und CPU?

Warum RAM OC ? Habe noch niemals gemacht und glaube geht bei der Bausteinen kaum was. Mit -30 meinst die Lüfterkurve?

Hat mir niemals gestört, höre die Lüfter kaum und die Temps scheinen wirklich gut zu sein.

So, jetzt erinnere mich, ich hatte in-game auf 120 Hz eingestellt, da die Karte sowieso nicht viel mehr schafft und so wollte ich nach Empfehlung etwas darunter fahren um die Drops zu verhindern.

Die bei neu erschienenen Treibern automatische Optimierung ( siehe Foto) funktioniert nicht im custom, daher...

Update

Nach dem ich die 120Hz Sperre aufgehoben habe, scheint alles viel flüssiger zu funktionieren, merkwürdig aber war.