Calid schrieb:

Ich hab deinen Post schon verstanden, keine Sorge. Und deine Cherry-Picking (Watt-Erbsenzählerei, Ram) sind vlt im absoluten Spezialfall interessant, OK, aber für den Haupteinsatzzweck (Grafik, Videoschnitt, Rendern, etc.) völlig nebensächlich. Du glaubst doch wohl nicht ernsthaft, dass sich das jemand anschaut? Wenn du das glaubst, kann ich dich von deiner Illusion befreien: da schaut kein Schw*** drauf (OK, in DE vlt der eine oder andere, mit eurer tollen Energiepolitik).

Du glaubst doch nicht ernsthaft, dass niemand sich für stromverbrauch interessiert, nur weil DU es nicht tust.

Wenn du das glaubst, kann ich dich von deiner Illusion befreien: Viele schauen drauf.

Und auch auf den damit verbundenen Hitzeausstoß und Lautstärke.

Zumal es völlig irrelevant ist, wen es interessiert. Der Unterschied ist technisch da, und MUSS mit einbezogen werden, wenn man Leistung vergleicht.

Wenn eine RTX 4090 3 mal so schnell ist, aber 6 mal so viel Strom verbraucht, gehört das hier eben dazu.

Was meinst du, warum Computerbase bei jedem GPU Test auch den Stromverbrauch misst? Weil kein Schw*** drauf schaut?

Calid schrieb:

Fakt ist, mit einem Highend PC System bist du bei gleicher Investitionssumme besser bedient. Bei Apple zahlst du die Apple-Tax. Ist einfach nur teuer das Trum, sonst keinerlei wirkliche Vorteile. Das Argument mit dem großen Speicher:

Das ist kein Fakt, sondern subjektive Präferenz.

Aber wenn du jemand bist, den nichts interessiert außer Benchmark-Balken, dann magst du das sicher anders sehen.

Es gibt mehr als genug, bei denen jedes PC System wegfällt, weil das falsche OS drauf läuft.

Es gibt viele Aspekte bei der Wahl eines Computers.

Der Tellerrand ist für manche wohl doch ein wenig höher. Das ist Schade.

Calid schrieb:

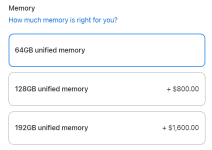

Zeig mir mal bitte den Usecase, der von den 192GB unified Speicher gebrauch macht (der für 0,001% der User interessant ist LOL)

Zeig mir mal bitte die Studie, dass "kein Schw***" sich für Stromverbrauch interessiert.

Calid schrieb:

Ich finde es ja auch lustig, das Apple der reinen RAM Kapazität diesen gewaltigen Rückschritt gemacht hat - vorher waren immerhin 1,5TB möglich, jetzt ist bei 0,19TB Schluss. Jede Wette, dass 1,5TB RAM damals als die ganz große und tollste Sacher der Welt beworben wurde

- Apple hald.

Das findet jeder lustig, und schade.

Aber du kommst hier nicht seriöser rüber, wenn du deinem verblendeten Apple-Hass hier raus lässt.

Ist es so schwer, sachlich zum Thema zu bleiben?

Calid schrieb:

Lügen wie gedruckt bei den Keynotes (machen andere Firmen auch, aber Apple ist schon ziemlich dreist). Diese ganzen Performence Metrics von kann man getrost vergessen.

Zeig mir eine Lüge.

Cherrypicking ist keine Lüge, man stellt sich selbst nur positiver da, als es durchschnittlich der Fall ist.

Das macht AMD, Intel und Nvidia ebenfalls.

Nicht schön, aber alle tun das. Auch bei Smartphones die ganzen hersteller, oder sonst wo.

Calid schrieb:

Mit dem Thema Aufrüsten fange ich gar nicht erst an. Ach ja: PCIE4.0 ist auch ein Scherz. Gibts ja nicht erst seit 4(!!) Jahren. Typisch Apple. Zu geizig für PCIE5 (oder technisch nicht möglich > huch wie fortschrittlich LOL)

Mit so einwürfen wie LOL ROFL und Co machst du deinen Standpunkt weder deutlicher, noch bringt es der Argumentation irgendwas.

Zumindest nichts, was über sinnfreies gehate hinaus geht.

Also genau das gegenteil von einem verblendeten Fanboy. Muss das sein?

Unabhängig davon, ob PCIe 4.0 heute Unsinn ist, wenn es 5.0 gibt, kannst mir eine Einschränkung erläutern?

Außer, wenn jemand PCIe 5.0 SSDs einbauen will, wobei auch da fraglich ist, wie sehr man effektiv davon profitiert.

Calid schrieb:

Völlig verrückt was die Dinger kosten.

Absolut. Ich finde die Aufpreise ja noch VIEL verrückter. Die Basispreise sind "ok", außer die 3000€ Aufpreis für die PCIe Slots. Alles andere ist halbwegs okay.

Wenn du in der Windows Welt etwas möglichst vergleichbares zu einem Macbook Air willst, zahlst du auch Macbook Air Preise. Teilweise sogar mehr.

late Edit:

Das eigentlich "lustige" hier ist ja, dass ich an sich auch denke, dass für die überwiegende Mehrheit, ein PC-basiertes Setup bei 6000-12000€~ sinnvoller bzw. besser geeignet wäre.

Aber es ist Quatsch die positiven Aspekte unter den Teppich zu kehren. Die sind da, und es ist 100% valid, wenn sie jemandem wichtig sind. Und wenn es am Ende nur das OS ist.