Ameisenmann schrieb:

früher waren es 4-6GHz, heute sind es vielleicht 8GHz die das physikalisch Machbare darstellen die mit modernster Halbleitertechnik möglich wären... von mehr als 10GHz sind wir auch nach vielen Jahren Lichtjahre entfernt!

@

WillardBL wer will denn diese Scheisse spielen?

Popey900 schrieb:

Wir wären heute locker bei 6-8Ghz, doch dann kam (glücklicherweise) Multicore.

Ich Vermute das die Hersteller lieber in richtung 12,16,32 Kerne gehen, als in richtung 10Ghz.

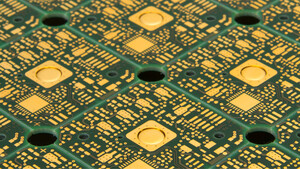

Das interessanteste an den News ist, das wir hoffentlich mal, das endliche Silicium ersetzen könnten.

Naja die 8GHz sind bereits mehrfach gefallen beim Extrem-Übertakten, aber das nicht gerade dank modernster Technik

Ich sage nur

Pentium 4 und Celeron C3xx.

Ist klar, dass sich das eher in Richtung Multicore entwickelt hat, da die physikalische Grenze natürlich irgendwann erreicht ist und logischerweise auch der Stromverbrauch ins exorbitante steigt, da

1. die benötigte Spannung irgendwann in keinem vernünftigen Verhältnis zur erreichten Leistung steht (die oben aufgeführten CPUs dürften alleine gute 1000W geschluckt haben unter Belastung und ~8GHz - kein Tippfehler)

2. der Stromverbrauch bei mehr Takt linear und bei mehr Spannung exponentiell ansteigt.

Somit gab es auf Siliciumbasis gar keine andere Möglichkeit, als auf Multicore-Technologie zu gehen. Statt 1x5GHz sind 2x2,5GHz eben doch ökologisch und ökonomisch wesentlich sinnvoller.

Ich bin auch mal sehr gespannt, was aus dem "Wundermaterial" Graphen noch so alles werden wird.

Auch wenn man noch keine Schaltungen in bestehende PCs integrieren kann, wird sich vllt mal eine neue, andersartige PC-Technik auf Basis des Graphens entwickeln und die Siliciumtechnik nach und nach ersetzen.

Ich würde das Zeug auch nicht daraufhin entwickeln, dass irgendwann mal Windows drauf läuft, sondern es eben für eine neue Art des Personal Computers zugrundelegen.