Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Blackwell (5070/5080/5090) Overclocking/Undervolting Sammelthread

- Ersteller Goozilla

- Erstellt am

Zuchtmaista schrieb:Finde Heraus Wo Das Problem Liegt.

Naja, zumindest habe ich durch dich Gewissheit, dass ich nicht der einzige bin, dass da Leistung fehlt. Ich möchte die Dinge auch gerne nachvollziehen, auch wenn der Benchmark egal sein kann. Update auf den Hotfix-Treiber 576.66, Windows-Update und Bios-Update keine Änderung. Die Leistung verschwand schon, während die 3 Dinge nicht geändert wurden.

Ergänzung ()

Was du aber mal machen kannst, die Karte auf ~0.89V mit ~2800-2850MHz stellen und dann nochmal Steel Nomad.

MehlstaubtheCat

Vice Admiral

- Registriert

- Sep. 2013

- Beiträge

- 6.301

Hi@all!

Die Lüfterkurve/Steuerung von Zotec ist auch mit Fan Control bisher nicht "überschreibbar".

Eine dauerhaft fixe Drehzahl wären die minimalen 30 % mit 1200RPM

und das ist für mich sinnfrei, wenn sie auch dauerhaft 0 RPM halten könnte.

Die Karte schaltet bei genau 40 Grad auf 30 % also die 1200 RPM, das ist nicht einstellbar.

Hier mal drei Screenshots, die das in Fan Control verdeutlichen (leichte Grafiklast, damit sie einschaltet):

Zum Thema Garantie, die ist mir persönlich schon immer "relativ" egal gewesen!

Ich warte bestimmt nicht so lange, bis ich eine Grafikkarte "anzufassen darf",

nur, weil eine Garantie nach 3-5 Jahren abgelaufen ist.

Ich für mich selber kann unmöglich so lange die Finger still halten!

Mit dem Wissen, dass die Karte nicht "perfekt" ist.

Keine Karte ist perfekt, jeder Hersteller spart an den Modellen,

der eine mehr, der andere weniger, ergo ich werde nachhelfen.

Ich hatte bisher ganze 5 Garantiefälle (nach meinen Tests)

in meiner ganzen Zeit als Selbständiger (10 Jahre).

Bei der Menge an Hardware, die ich jedes Jahr in den Finger halte,

ist das Prozentual gesehen einfach sehr wenig.

Keinen dieser Garantiefälle hat eine Grafikkarte betroffen.

(Irgendwann wird dies auch sicher mal eintreffen,

dann hab ich auch damit kein Problem!)

Meine Vorgehensweise ist einfach,

ich teste jede Komponente, die ich verbaue, vorher einzeln,

bevor ich den Rechner zusammen baue,

dafür habe ich eine, ich nenne es mal "Wärmekammer"

(begehbar, diese hat etwa 20 Kubikmeter an Luftvolumen) gebaut.

Diese Kammer kann ich einstellen, sodass immer über 32 Grad gehalten werden.

Hiermit kann ich dann mit OC z. B. eine warme Sommerwohnung simulieren.

Stresstests über sehr viele Stunden sind hier für mich Pflicht.

Spätestens wenn hier Hardware ausfallen sollte,

kann ich die Garantie geltend machen,

bevor ich eben einen ganz zusammen gebauten PC ausliefere.

Würde ich so nicht vorgehen, könnte es sicher ganz anders aussehen.

Ich kann nicht mal eben einen PC, den ich nach Kuwait verschickt habe,

auf meine eigenen Kosten zurück hohlen.

Darum teste ich bis zum Umfallen,

die Kammer ist 24 Stunden 365 Tage im Jahr im Betrieb.

Netter Nebeneffekt im Winter, ich kann mit der Abwärme meine komplette Werkstatt (182 m²)

problemlos damit heizen.

Eine weitere Regel, ich warte 1-2 Wochen wie sich z. B. die Grafikkarten verhalten und laufen,

ob irgendwelche "Auffälligkeiten"sich zeigen.

Mit Auffälligkeiten meine ich z. B., ob sie vom Monitor immer sofort erkannt werden.

Etwa beim Rechner Neustart auch sofort ein Bild gebracht wird.

Hier verwende ich verschiedene Monitor Typen zum Testen.

Da hatte ich in der Vergangenheit mit den RTX 3000 so meine Probleme,

dies Karten gingen dann sofort zurück.

Wenn wir schon beim Thema "Temperatur" gelandet sind.

Ich möchte noch ein Thema zum Nachdenken da lassen!

Das Thema heißt "Hotspot-Temperatur"!

Nvidia hat bekanntlich die Hotspot-Temperatur bei den 5000er-Karten nicht mehr auslesbar gemacht,

mit den zur Verfügung stehenden Tools, die wir alle kennen.

Man kann jetzt viel spekulieren, warum und weshalb,

das bringt aber niemand wirklich weiter.

Ich für meinen Teil habe hier eine Theorie und auch paar Tests,

die ich euch nicht vorenthalten möchte.

Ich nehme hier die "ASUS GeForce RTX 4070 Ti Super TUF" als Testobjekt!

Warum eine "Ada Lovelace" (4000) Karte werdet ihr euch vielleicht fragen!

Ganz einfach, da das Fertigungsverfahren exakt gleich geblieben ist zu den

aktuellen "Blackwell" (5000) Karten.

Diese Karte habe ich bisher 16-mal verbaut und hier sehr viele Daten dazu gesammelt.

Dazu gehört sie zu den besten 4070 Ti Super Karten was den Kühler angeht!

Das sind alle 16 Datensätze zusammengefasst zu einer Durchschnittskurve,

logisch auf die Raumtemperatur normiert.

Was bei der Karte ein verhalten ist, dass ab etwa 90-92 Grad Hotspot die "Auto" Lüfterkurve bedeutend aggressiver agierte und auch ab hier Leistung in Benchmarks etwas einbrechen.

Ich gehe davon aus, dass ab hier Chiptakt etwas zurückgenommen wird,

kann ich aber anhand von den Softwaretools nicht sicher feststellen,

da das "heruntertakten" viel zu schnell geht, so dass die Tools nicht reagieren.

Man kann aber davon ausgehen, dass die "Blackwell" Architektur sich

etwas schlechter temperaturtechnisch verhält als noch "Ada".

Soll heißen die GPU Temperatur zu Hotspot "Schere" geht schneller etwas weiter auf.

Bei geringer GPU Temperatur wird schon ein etwas höherer Hotspot erreicht als noch bei "Ada"

Aber ab ca. 70-72 Grad GPU-Temp geht der Hotspot schneller auseinander,

meine Vermutung, die schwer nachzustellen ist,

da hier meist im Powertarget und der Takt dadurch auch zurückgenommen wird.

In der Theorie sollte Blackwell ab ca. 71-73 GPU-Temp mit dem Hotspot schon so warm sein,

dass aufgrund dieser Tatsache allein schon Takt zurückgenommen wird,

vorausgesetzt Blackwell verhält sich wie Ada.

"Theoretische" Temperatur verhalten "Blackwell" keine Messdaten!

Ich werde weiter Daten sammeln und vielleicht komme ich noch hinter

das Hotspot "Geheimnis" von "Blackwell".

Was ich aber soweit sagen kann, ich persönlich würde zusehen,

dass ich unter 70 Grad GPU Temperatur bleiben würde,

auch mit dem Hinblick das eben viele in einer Wohnung direkt unter dem Dach leben

und im Sommer dort hohe 30er-Grad Zahlen erreicht werden.

Die günstigen Karten erreichen schon die 70 Grad GPU Temperatur im Normalbetrieb,

somit würde ich hier unbedingt UV empfehlen.

Es hat wohl schon seinen Sinn, warum Nvidia die Hotspot-Temperatur nicht auslesbar gemacht hat!

Es würde wohl zu viele Kunden schocken, wenn Sie eine Hotspot-Temperatur

dauerhaft im dreistellige Bereich sehen müssten.

Ich mache wieder bubu!

Gruß

Mehlstaub

Ich glaube, man missversteht mich hier etwas!-MK schrieb:Warum stellst du dir dann nicht einfach eine eigene Lüfterkurve oder dauerhaft fixe Drehzahl ein? Dafür jetzt die komplette Karte auseinander nehmen und ggf noch Probleme mit Garantie zu bekommen, ich weiß ja nicht. Oder ist ZOTAC da so kulant und dir der Aufwand den fraglichen Erfolg wert? 😅

Die Lüfterkurve/Steuerung von Zotec ist auch mit Fan Control bisher nicht "überschreibbar".

Eine dauerhaft fixe Drehzahl wären die minimalen 30 % mit 1200RPM

und das ist für mich sinnfrei, wenn sie auch dauerhaft 0 RPM halten könnte.

Die Karte schaltet bei genau 40 Grad auf 30 % also die 1200 RPM, das ist nicht einstellbar.

Hier mal drei Screenshots, die das in Fan Control verdeutlichen (leichte Grafiklast, damit sie einschaltet):

Zum Thema Garantie, die ist mir persönlich schon immer "relativ" egal gewesen!

Ich warte bestimmt nicht so lange, bis ich eine Grafikkarte "anzufassen darf",

nur, weil eine Garantie nach 3-5 Jahren abgelaufen ist.

Ich für mich selber kann unmöglich so lange die Finger still halten!

Mit dem Wissen, dass die Karte nicht "perfekt" ist.

Keine Karte ist perfekt, jeder Hersteller spart an den Modellen,

der eine mehr, der andere weniger, ergo ich werde nachhelfen.

Ich hatte bisher ganze 5 Garantiefälle (nach meinen Tests)

in meiner ganzen Zeit als Selbständiger (10 Jahre).

Bei der Menge an Hardware, die ich jedes Jahr in den Finger halte,

ist das Prozentual gesehen einfach sehr wenig.

Keinen dieser Garantiefälle hat eine Grafikkarte betroffen.

(Irgendwann wird dies auch sicher mal eintreffen,

dann hab ich auch damit kein Problem!)

Meine Vorgehensweise ist einfach,

ich teste jede Komponente, die ich verbaue, vorher einzeln,

bevor ich den Rechner zusammen baue,

dafür habe ich eine, ich nenne es mal "Wärmekammer"

(begehbar, diese hat etwa 20 Kubikmeter an Luftvolumen) gebaut.

Diese Kammer kann ich einstellen, sodass immer über 32 Grad gehalten werden.

Hiermit kann ich dann mit OC z. B. eine warme Sommerwohnung simulieren.

Stresstests über sehr viele Stunden sind hier für mich Pflicht.

Spätestens wenn hier Hardware ausfallen sollte,

kann ich die Garantie geltend machen,

bevor ich eben einen ganz zusammen gebauten PC ausliefere.

Würde ich so nicht vorgehen, könnte es sicher ganz anders aussehen.

Ich kann nicht mal eben einen PC, den ich nach Kuwait verschickt habe,

auf meine eigenen Kosten zurück hohlen.

Darum teste ich bis zum Umfallen,

die Kammer ist 24 Stunden 365 Tage im Jahr im Betrieb.

Netter Nebeneffekt im Winter, ich kann mit der Abwärme meine komplette Werkstatt (182 m²)

problemlos damit heizen.

Eine weitere Regel, ich warte 1-2 Wochen wie sich z. B. die Grafikkarten verhalten und laufen,

ob irgendwelche "Auffälligkeiten"sich zeigen.

Mit Auffälligkeiten meine ich z. B., ob sie vom Monitor immer sofort erkannt werden.

Etwa beim Rechner Neustart auch sofort ein Bild gebracht wird.

Hier verwende ich verschiedene Monitor Typen zum Testen.

Da hatte ich in der Vergangenheit mit den RTX 3000 so meine Probleme,

dies Karten gingen dann sofort zurück.

Wenn wir schon beim Thema "Temperatur" gelandet sind.

Ich möchte noch ein Thema zum Nachdenken da lassen!

Das Thema heißt "Hotspot-Temperatur"!

Nvidia hat bekanntlich die Hotspot-Temperatur bei den 5000er-Karten nicht mehr auslesbar gemacht,

mit den zur Verfügung stehenden Tools, die wir alle kennen.

Man kann jetzt viel spekulieren, warum und weshalb,

das bringt aber niemand wirklich weiter.

Ich für meinen Teil habe hier eine Theorie und auch paar Tests,

die ich euch nicht vorenthalten möchte.

Ich nehme hier die "ASUS GeForce RTX 4070 Ti Super TUF" als Testobjekt!

Warum eine "Ada Lovelace" (4000) Karte werdet ihr euch vielleicht fragen!

Ganz einfach, da das Fertigungsverfahren exakt gleich geblieben ist zu den

aktuellen "Blackwell" (5000) Karten.

Diese Karte habe ich bisher 16-mal verbaut und hier sehr viele Daten dazu gesammelt.

Dazu gehört sie zu den besten 4070 Ti Super Karten was den Kühler angeht!

Das sind alle 16 Datensätze zusammengefasst zu einer Durchschnittskurve,

logisch auf die Raumtemperatur normiert.

Was bei der Karte ein verhalten ist, dass ab etwa 90-92 Grad Hotspot die "Auto" Lüfterkurve bedeutend aggressiver agierte und auch ab hier Leistung in Benchmarks etwas einbrechen.

Ich gehe davon aus, dass ab hier Chiptakt etwas zurückgenommen wird,

kann ich aber anhand von den Softwaretools nicht sicher feststellen,

da das "heruntertakten" viel zu schnell geht, so dass die Tools nicht reagieren.

Man kann aber davon ausgehen, dass die "Blackwell" Architektur sich

etwas schlechter temperaturtechnisch verhält als noch "Ada".

Soll heißen die GPU Temperatur zu Hotspot "Schere" geht schneller etwas weiter auf.

Bei geringer GPU Temperatur wird schon ein etwas höherer Hotspot erreicht als noch bei "Ada"

Aber ab ca. 70-72 Grad GPU-Temp geht der Hotspot schneller auseinander,

meine Vermutung, die schwer nachzustellen ist,

da hier meist im Powertarget und der Takt dadurch auch zurückgenommen wird.

In der Theorie sollte Blackwell ab ca. 71-73 GPU-Temp mit dem Hotspot schon so warm sein,

dass aufgrund dieser Tatsache allein schon Takt zurückgenommen wird,

vorausgesetzt Blackwell verhält sich wie Ada.

"Theoretische" Temperatur verhalten "Blackwell" keine Messdaten!

Ich werde weiter Daten sammeln und vielleicht komme ich noch hinter

das Hotspot "Geheimnis" von "Blackwell".

Was ich aber soweit sagen kann, ich persönlich würde zusehen,

dass ich unter 70 Grad GPU Temperatur bleiben würde,

auch mit dem Hinblick das eben viele in einer Wohnung direkt unter dem Dach leben

und im Sommer dort hohe 30er-Grad Zahlen erreicht werden.

Die günstigen Karten erreichen schon die 70 Grad GPU Temperatur im Normalbetrieb,

somit würde ich hier unbedingt UV empfehlen.

Es hat wohl schon seinen Sinn, warum Nvidia die Hotspot-Temperatur nicht auslesbar gemacht hat!

Es würde wohl zu viele Kunden schocken, wenn Sie eine Hotspot-Temperatur

dauerhaft im dreistellige Bereich sehen müssten.

Ich mache wieder bubu!

Gruß

Mehlstaub

Snoopy69

Commodore

- Registriert

- März 2004

- Beiträge

- 4.446

Meins kam von "Ali" mit ordentlich Rabatt...Banger schrieb:Du bekommst also auch zu wenig Punkte in Steel Nomad. :-/ Scheint ja irgendwas einen Einfluss zu haben, sei es Windows-Update oder sonst was. Sollte ja eigentlich 8750 auf Stock etwa sein und UV und OC 8800.

Auf Stock bekomme ich auch nur noch 8600 und das mit geschlossenem Browser. Mit UV hatte ich die 8800 teilweise noch.

Wo bewegt sich die Boardpower auf Stock? durchgehend bei 360?

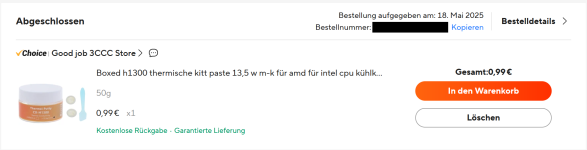

CX-H1300 für 99 Cent? Bei Amazon doch bisschen teurer, aber dennoch billiger als 24 für das TG Advanced, welches ich leider auch gekauft habe, weil ich das schnell verfügbar haben wollte und andere schlecht beschaffbar waren oder mit langen Lieferzeiten.

https://www.amazon.de/Maxtonser-Thermal-Conductive-Non-Conductive-Compound/dp/B0CZLKQXFY/?_encoding=UTF8&pd_rd_w=nwb1t&content-id=amzn1.sym.16038c01-cfea-4f09-a119-c9f8c051c46c:amzn1.symc.fc11ad14-99c1-406b-aa77-051d0ba1aade&pf_rd_p=16038c01-cfea-4f09-a119-c9f8c051c46c&pf_rd_r=R3VKTJ0KMW641BX92ZZK&pd_rd_wg=ZduaL&pd_rd_r=5638fd7e-b71b-44c1-8541-8fe92cd5a789&ref_=pd_hp_d_atf_ci_mcx_mr_ca_hp_atf_d&th=1

Normalerweise 9,39€ - bei Amazon würden 50g knapp 19€ kosten

btw:

Ich hatte es nicht eilig. Ab Bestellung bis Erhalt, dauerte es 12 Tage

Ergänzung ()

Danke für die Daten...MehlstaubtheCat schrieb:Es hat wohl schon seinen Sinn, warum Nvidia die Hotspot-Temperatur nicht auslesbar gemacht hat!

Es würde wohl zu viele Kunden schocken, wenn Sie eine Hotspot-Temperatur

dauerhaft im dreistellige Bereich sehen müssten.

Aber war das der Grund bei NV?

Ich persönlich hätte gerne GPU-Hotspot zurück, weil Hotspot bei evtl. fehlerhafter Montage bzw fehlerhaften Kühlern extrem hoch sein kann

Zuletzt bearbeitet:

MehlstaubtheCat schrieb:Das Thema heißt "Hotspot-Temperatur"!

Ich habe auch mal was getestet. Lüfter auf 30% fest (1000 1/min), Powertarget auf 110%, Startbildschirm von RE4-Demo. Bei 380W hielt Edge sich bei 87°C. Takt bei 26xx und Powertargetlimit angezeigt. Da sprang keine Schutzschaltung mit Lüfter auf 3500 1/min an.

Davon ab hatte ich die 4080 2x, die erste hatte rund 15K Differenz, die andere 12K.

Und auch da habe ich den Test gemacht, bewegte sich bei 88-89°C und es stand Limit wegen Thermal. Hotspot war bei der Differenz von 12K auf ca. 16K. Also 104 etwa. Auch da Lüfter auf 30% und keine 3500 1/min reingekickt.

Bei der 5080 kommt schon ab ca. 310W das Powertargetlimit, wo dann schon 1-2 Stufen runtergehen. Also bei 50W unterhalb der 360er-Begrenzung. Mache ich die Begrenzung auf 396, ist bei 310W dann entsprechend noch 1-2 Stufen höher. Bei Stellar Blade (Demo) in UHD machte das entsprechend den Unterschied ~330 und ~340W.

Diese Tests alle ohne UV.

Und auch da habe ich den Test gemacht, bewegte sich bei 88-89°C und es stand Limit wegen Thermal. Hotspot war bei der Differenz von 12K auf ca. 16K. Also 104 etwa. Auch da Lüfter auf 30% und keine 3500 1/min reingekickt.

Bei der 5080 kommt schon ab ca. 310W das Powertargetlimit, wo dann schon 1-2 Stufen runtergehen. Also bei 50W unterhalb der 360er-Begrenzung. Mache ich die Begrenzung auf 396, ist bei 310W dann entsprechend noch 1-2 Stufen höher. Bei Stellar Blade (Demo) in UHD machte das entsprechend den Unterschied ~330 und ~340W.

Diese Tests alle ohne UV.

MehlstaubtheCat

Vice Admiral

- Registriert

- Sep. 2013

- Beiträge

- 6.301

Hi@all!

bei den Blackwell Karten mit Tools auslesbar gemacht!

Und es wäre wirklich bei vielen Karten eine dreistellige Temperatur-Zahl bei den "Review Test" dabei herausgekommen.

Es wäre ein übelster "Shitstorm" losgebrochen, mit dem Ende,

dass die 5000er-Karten um einiges weniger verkauft werden würde als aktuell.

Nvidia möchte ja Geld verdienen, bedeutet je weniger der Kunde über die Karten weiß, desto besser.

Was der Kunde nicht weiß, macht ihn nicht heiß!

Schön unter den Teppich kehren und den Mund halten.

Ist bei sehr vielen Firmen meist besser etwas "auszusitzen" und sich nicht äußern,

als ehrlich zu sein und dafür Geld zu verlieren, so ist die Welt!

Verdrehen von Tatsachen und schweigen bei Problemen, das ist Marketing und Management!

Sieht man aktuell ganz gut, was die Treiber bei Nvidia angeht.

Da dringt so gut wie nichts an die Öffentlichkeit,

schön den Mund halten, das Problem klein halten.

Sodass sich möglichst wenig zukünftige Kunden aufregen,

oder am besten Kunden, die keine Ahnung von Hardware haben,

erst gar nichts von dem Treiber Problem gehört haben.

Das ist das Ziel von Nvidia!

Menschen sind einfach gestrickt:

"Nvidia baut die besten Grafikkarten, ich weil auch eine!"

Alles andere darum bekommt kein "Normalo" mit.

Nur wir hier in der "CB-Bubbel",

die nicht einmal 0,1 % ausmachen, sind "entsetzt"!

Ich habe so viele Kunden bei mir,

die haben Kohle, aber kennen sich absolut gar nicht mit Hardware und Software aus!

Lassen einen 5000 Euro PC bauen, wissen nicht was verbaut ist,

sie können ihn ein und wieder ausschalten und er sieht schön aus!

Das die beste Zielgruppe, die eine Firma wie Nvidia haben kann!

Solche Kunden stellen keine Fragen!

Nochmal zurück zu der "Hotspot-Temperatur".

Ich gehe schwer davon aus, dass die Grafikkartenhersteller Tools besitzen,

die Hotspot-Temperatur auslesen können.

Es wäre fatal nicht überprüfen zu können, ob der verbaute Kühler ordentlich "sitzt"!

Eine höhere Ausfallrate wäre die Folge, was viel Geld kosten würde,

also kann es eigentlich nicht sein das es keine Tools gibt.

Die "Marge" der Hersteller ist sowieso schon so klein,

da können die sich keine weiteren Probleme leisten, das unmöglich!

Ich halte es nur für eine Frage der Zeit, wann der "Code" mal "geleakt" wird

und findige Programmierer ihn in einem Softwaretool integrieren werden,

inoffiziell natürlich.

Bin schon gespannt was die folgen sein werden und wie Nvidia darauf reagiert!

Wohl auch mit beschwichtigen, klein reden oder besser gar nichts dazu sagen und Kleinschweigen.

Würde mich nicht wundern, die Taktik geht einfach zu oft sehr gut aus!

@Banger

Ich glaube nicht, dass es eine "Schutzschaltung" (ich würde es anders nennen!)

bei 4000 oder 5000 Karten gibt.

(Klar, Max Drehzahl ab 105 bis 110 Grad glaube, ich war es, ist Standard,

dann abschalten, das meine ich aber nicht damit!)

Ich habe bisher keine feststellen können,

das von mir oben genannte verhalten der ASUS Karte ist ASUS spezifisch.

Aber ich hab es angesprochen, als ob ASUS etwas weiß,

von dem "wir" also "Kunden" "Hardware-Freaks" noch nichts wissen.

Und es kommt mir so vor, als dass es mit der Hotspot-Temperatur zu tun hat.

Also auch schon bei den 4000 und nicht erst bei den 5000 Karten ein Thema gewesen sein muss,

das meine Vermutung, warum ich es oben mal beschrieben habe.

Das Ganze ist aber erst zum Thema geworden,

da ja bei den 5000er keine Hotspot-Temperatur mehr auslesbar ist.

Ich wollte damit nur ausdrücken, das "Problem" (wenn es denn eines sein sollte)

deutlich älter ist als das es aktuell war genommen wird.

Noch ein anderes Thema was ich ansprechen möchte!

"Wie bekommt Nvidia mehr Leistung aus dem gleichen Fertigungsprozess von 4000 zu 5000 Serie"

Ich möchte noch etwas "Background" hier lassen, was Nvidia getan hat,

um mehr Leistung zu erzielen, bei gleichem Fertigungsprozess.

Als Erstes auch hier wieder etwas "Bullshit Marketing" seitens Nvidia!

Nvidia gibt den Fertigungsprozess benannt als "4N FinFET" an.

Die "4" impliziert einen 4 Nanometer Prozess, das ist aber nicht korrekt,

da es in Wirklichkeit ein 5 Nanometer Prozess ist, mit dem Ende 2021-Anfang 2022

die Produktion bei TSMC aufgenommen wurde.

Bedeutet, die 5000er-Karten werden in einem Prozess gefertigt,

der mittlerweile mehr als 3 Jahre alt ist.

Das ist in der "Chipwelt" eine Ewigkeit und eigentlich schon fast veraltet!

Mal sehen, was passiert, wenn man in einen neueren Fertigungsprozess "switched"

Ich gehe davon aus, dass zuerst die AI Chips in das Fertigungs-Kontingent gefertigt werden

und wenn dieser sauber läuft, dann die Gamingchips langsam nachziehen.

Die 6000er-Serie wird auf keinem Fall mehr in 5 Nanometer gefertigt werden.

Der Fertigungsprozess ist "ausgelutscht"!

Aber mit Sicherheit wird Nvidia ganz stark die Produktion von Gaming Chips begrenzen,

sodass maximal viel von den "AI Chips" gefertigt werden können.

Alles, was möglich ist, in den AI Bereich zu stecken, wird Nvidia auch da rein stecken,

hier wird der Umsatz gemacht!

Also hier offensichtlich keine Liebe von Nvidia an ihre Gamer, was auch logisch ist,

wenn man die prozentuale Verteilung des Umsatzes von "Gaming" zu "AI" bei Nvidia anschaut.

Es wird absehbar keine Entspannung des Preises bei Gaming Grafikkarten geben,

ich gehe davon aus das es wohl noch etwas schlimmer als aktuell werden wird.

Für Nvidia lohnt es sich nicht Gaming Chips zu fertigen,

wenn man für die gleiche Chipfläche ein Vielfaches an Euros verdienen kann.

Das ist die Realität!

Sorry, da bin ich wohl etwas abgeschwiffen!

Jetzt aber 4000 zu 5000...

Vergleicht man die 4070 Ti Super mit der 5070Ti, was die wohl am vergleichbaren Grafikkarten sind.

Gehen wir hier von etwa 11-19 % an Leistungssteigerung aus, je nach Game für die 5070 Ti natürlich.

Erstens der verbaute VRAM > GDDR6X zu GDDR7, mehr Bandbreite = mehr Leistung,

Hier gewinnt man mehr Leistung, in dem man einfach einen neueren Speichertyp verbaut,

mit das einfachste überhaupt, ohne selber etwas dazuzutun zu müssen,

einfache Mehrleistung!

Ich gehe davon aus, dass hier allein je nach Game 4-10 % allein an Leistung erreicht werden.

5070Ti > 896 GB/s "theoretischer Brutto" zu 4070Ti Super > 672,3 GB/s.

99 % aller 5070Ti erreichen +375 auf dem Speicher (1750 MHz>2125)

Bei den 4070Ti Super ist bei + 200-300 Schluss. (1313 MHz >1500-1600 etwa)

Ich werde bis heute ausgelacht, als ich im September 2022 schon gesagt habe,

dass die RTX 4090 massiv Bandbreiten-limitiert ist mit ihren 1 TB/s!

Dann hatte ich Kundenkarten hier und ich konnte das bestätigen,

bis jetzt wird mir nicht geglaubt! Schon lustig irgendwie!

Ich liege damit aber zu 100 % richtig!

Würde man 30 Gbps (1875 MHz) GDDR7 auf eine 4090 verbauen können,

wäre der Vorsprung der 5090 noch viel geringer als er jetzt schon ist!

Zweitens das leicht erhöhte Power Target offizielle 285Watt zu 300Watt.

Die 5 % mehr am Powertarget für die 5070 Ti könne hier und da schon ins Gewicht fallen.

Hier ist es schwer abzuschätzen, wie oft man im Spielen im Powertarget landet.

Aber was man sagen kann, das Boostverhalten ist bei Blackwell (5000) aggressiver (höher) als bei Ada (4000).

Darum hat hier Nvidia die 5 % extra auch "zugelassen",

da es bei Blackwell etwas mehr bringt als bei Ada, ganz einfach betrachtet.

Dazu ist der Boost auch deutlich höher von Blackwell zu Ada.

Jede 5070Ti auch die aller günstigsten Modelle erreichen einen "OC Chiptakt"

von mindestens 3100 MHz durch die Bank weg!

Bei Ada ist bei minimal 2800 bis maximal 2900MHz das absolute Ende auf dem Chip erreicht!

5 % mehr Powertarget bei Blackwell sind mehr als 5 % extra Leistung,

je nach Game im Vergleich zu Ada! (Erklärt in Drittens)

Drittens, ich gehe davon aus, da "Pro Takt" (Clock zu Clock) gesehen Blackwell je nach Game etwa 3-6 % schneller ist als Ada allein durch die "Architektur Verbesserungen".

Mit der Architektur ist Nvidia ganz offensichtlich an das thermische Limit des Fertigungsprozesses gegangen.

Darum keine besagte Hotspot-Temperatur auslesbar wird.

Jetzt bitte nicht einfach "Plump" die von mir genannten Prozente zusammen addieren!

Ein Game profitiert mehr von Bandbreite, das andere mehr von der verbesserten Architektur,

das andere rennt früher in das Powertarget, das andere wiederum nicht!

Die Varianz aller Games ist sehr groß!

Es wird selten alle von mir genannten Punkte zu 100 % voll auf einmal in einem Spiel eintreffen.

Wer bis jetzt alle hier gelesen hat, bekommt von mir einen Orden! 🙌

So wieder bubu machen! 😴

Gruß

Mehlstaub

Überlege mal 5 Sekunden, was passiert wäre, hätte Nvidia die "Hotspot-Temperatur"Snoopy69 schrieb:Danke für die Daten...

Aber war das der Grund bei NV?

Ich persönlich hätte gerne GPU-Hotspot zurück, weil Hotspot bei evtl. fehlerhafter Montage bzw fehlerhaften Kühlern extrem hoch sein kann

bei den Blackwell Karten mit Tools auslesbar gemacht!

Und es wäre wirklich bei vielen Karten eine dreistellige Temperatur-Zahl bei den "Review Test" dabei herausgekommen.

Es wäre ein übelster "Shitstorm" losgebrochen, mit dem Ende,

dass die 5000er-Karten um einiges weniger verkauft werden würde als aktuell.

Nvidia möchte ja Geld verdienen, bedeutet je weniger der Kunde über die Karten weiß, desto besser.

Was der Kunde nicht weiß, macht ihn nicht heiß!

Schön unter den Teppich kehren und den Mund halten.

Ist bei sehr vielen Firmen meist besser etwas "auszusitzen" und sich nicht äußern,

als ehrlich zu sein und dafür Geld zu verlieren, so ist die Welt!

Verdrehen von Tatsachen und schweigen bei Problemen, das ist Marketing und Management!

Sieht man aktuell ganz gut, was die Treiber bei Nvidia angeht.

Da dringt so gut wie nichts an die Öffentlichkeit,

schön den Mund halten, das Problem klein halten.

Sodass sich möglichst wenig zukünftige Kunden aufregen,

oder am besten Kunden, die keine Ahnung von Hardware haben,

erst gar nichts von dem Treiber Problem gehört haben.

Das ist das Ziel von Nvidia!

Menschen sind einfach gestrickt:

"Nvidia baut die besten Grafikkarten, ich weil auch eine!"

Alles andere darum bekommt kein "Normalo" mit.

Nur wir hier in der "CB-Bubbel",

die nicht einmal 0,1 % ausmachen, sind "entsetzt"!

Ich habe so viele Kunden bei mir,

die haben Kohle, aber kennen sich absolut gar nicht mit Hardware und Software aus!

Lassen einen 5000 Euro PC bauen, wissen nicht was verbaut ist,

sie können ihn ein und wieder ausschalten und er sieht schön aus!

Das die beste Zielgruppe, die eine Firma wie Nvidia haben kann!

Solche Kunden stellen keine Fragen!

Nochmal zurück zu der "Hotspot-Temperatur".

Ich gehe schwer davon aus, dass die Grafikkartenhersteller Tools besitzen,

die Hotspot-Temperatur auslesen können.

Es wäre fatal nicht überprüfen zu können, ob der verbaute Kühler ordentlich "sitzt"!

Eine höhere Ausfallrate wäre die Folge, was viel Geld kosten würde,

also kann es eigentlich nicht sein das es keine Tools gibt.

Die "Marge" der Hersteller ist sowieso schon so klein,

da können die sich keine weiteren Probleme leisten, das unmöglich!

Ich halte es nur für eine Frage der Zeit, wann der "Code" mal "geleakt" wird

und findige Programmierer ihn in einem Softwaretool integrieren werden,

inoffiziell natürlich.

Bin schon gespannt was die folgen sein werden und wie Nvidia darauf reagiert!

Wohl auch mit beschwichtigen, klein reden oder besser gar nichts dazu sagen und Kleinschweigen.

Würde mich nicht wundern, die Taktik geht einfach zu oft sehr gut aus!

@Banger

Ich glaube nicht, dass es eine "Schutzschaltung" (ich würde es anders nennen!)

bei 4000 oder 5000 Karten gibt.

(Klar, Max Drehzahl ab 105 bis 110 Grad glaube, ich war es, ist Standard,

dann abschalten, das meine ich aber nicht damit!)

Ich habe bisher keine feststellen können,

das von mir oben genannte verhalten der ASUS Karte ist ASUS spezifisch.

Aber ich hab es angesprochen, als ob ASUS etwas weiß,

von dem "wir" also "Kunden" "Hardware-Freaks" noch nichts wissen.

Und es kommt mir so vor, als dass es mit der Hotspot-Temperatur zu tun hat.

Also auch schon bei den 4000 und nicht erst bei den 5000 Karten ein Thema gewesen sein muss,

das meine Vermutung, warum ich es oben mal beschrieben habe.

Das Ganze ist aber erst zum Thema geworden,

da ja bei den 5000er keine Hotspot-Temperatur mehr auslesbar ist.

Ich wollte damit nur ausdrücken, das "Problem" (wenn es denn eines sein sollte)

deutlich älter ist als das es aktuell war genommen wird.

Noch ein anderes Thema was ich ansprechen möchte!

"Wie bekommt Nvidia mehr Leistung aus dem gleichen Fertigungsprozess von 4000 zu 5000 Serie"

Ich möchte noch etwas "Background" hier lassen, was Nvidia getan hat,

um mehr Leistung zu erzielen, bei gleichem Fertigungsprozess.

Als Erstes auch hier wieder etwas "Bullshit Marketing" seitens Nvidia!

Nvidia gibt den Fertigungsprozess benannt als "4N FinFET" an.

Die "4" impliziert einen 4 Nanometer Prozess, das ist aber nicht korrekt,

da es in Wirklichkeit ein 5 Nanometer Prozess ist, mit dem Ende 2021-Anfang 2022

die Produktion bei TSMC aufgenommen wurde.

Bedeutet, die 5000er-Karten werden in einem Prozess gefertigt,

der mittlerweile mehr als 3 Jahre alt ist.

Das ist in der "Chipwelt" eine Ewigkeit und eigentlich schon fast veraltet!

Mal sehen, was passiert, wenn man in einen neueren Fertigungsprozess "switched"

Ich gehe davon aus, dass zuerst die AI Chips in das Fertigungs-Kontingent gefertigt werden

und wenn dieser sauber läuft, dann die Gamingchips langsam nachziehen.

Die 6000er-Serie wird auf keinem Fall mehr in 5 Nanometer gefertigt werden.

Der Fertigungsprozess ist "ausgelutscht"!

Aber mit Sicherheit wird Nvidia ganz stark die Produktion von Gaming Chips begrenzen,

sodass maximal viel von den "AI Chips" gefertigt werden können.

Alles, was möglich ist, in den AI Bereich zu stecken, wird Nvidia auch da rein stecken,

hier wird der Umsatz gemacht!

Also hier offensichtlich keine Liebe von Nvidia an ihre Gamer, was auch logisch ist,

wenn man die prozentuale Verteilung des Umsatzes von "Gaming" zu "AI" bei Nvidia anschaut.

Es wird absehbar keine Entspannung des Preises bei Gaming Grafikkarten geben,

ich gehe davon aus das es wohl noch etwas schlimmer als aktuell werden wird.

Für Nvidia lohnt es sich nicht Gaming Chips zu fertigen,

wenn man für die gleiche Chipfläche ein Vielfaches an Euros verdienen kann.

Das ist die Realität!

Sorry, da bin ich wohl etwas abgeschwiffen!

Jetzt aber 4000 zu 5000...

Vergleicht man die 4070 Ti Super mit der 5070Ti, was die wohl am vergleichbaren Grafikkarten sind.

Gehen wir hier von etwa 11-19 % an Leistungssteigerung aus, je nach Game für die 5070 Ti natürlich.

Erstens der verbaute VRAM > GDDR6X zu GDDR7, mehr Bandbreite = mehr Leistung,

Hier gewinnt man mehr Leistung, in dem man einfach einen neueren Speichertyp verbaut,

mit das einfachste überhaupt, ohne selber etwas dazuzutun zu müssen,

einfache Mehrleistung!

Ich gehe davon aus, dass hier allein je nach Game 4-10 % allein an Leistung erreicht werden.

5070Ti > 896 GB/s "theoretischer Brutto" zu 4070Ti Super > 672,3 GB/s.

99 % aller 5070Ti erreichen +375 auf dem Speicher (1750 MHz>2125)

Bei den 4070Ti Super ist bei + 200-300 Schluss. (1313 MHz >1500-1600 etwa)

Ich werde bis heute ausgelacht, als ich im September 2022 schon gesagt habe,

dass die RTX 4090 massiv Bandbreiten-limitiert ist mit ihren 1 TB/s!

Dann hatte ich Kundenkarten hier und ich konnte das bestätigen,

bis jetzt wird mir nicht geglaubt! Schon lustig irgendwie!

Ich liege damit aber zu 100 % richtig!

Würde man 30 Gbps (1875 MHz) GDDR7 auf eine 4090 verbauen können,

wäre der Vorsprung der 5090 noch viel geringer als er jetzt schon ist!

Zweitens das leicht erhöhte Power Target offizielle 285Watt zu 300Watt.

Die 5 % mehr am Powertarget für die 5070 Ti könne hier und da schon ins Gewicht fallen.

Hier ist es schwer abzuschätzen, wie oft man im Spielen im Powertarget landet.

Aber was man sagen kann, das Boostverhalten ist bei Blackwell (5000) aggressiver (höher) als bei Ada (4000).

Darum hat hier Nvidia die 5 % extra auch "zugelassen",

da es bei Blackwell etwas mehr bringt als bei Ada, ganz einfach betrachtet.

Dazu ist der Boost auch deutlich höher von Blackwell zu Ada.

Jede 5070Ti auch die aller günstigsten Modelle erreichen einen "OC Chiptakt"

von mindestens 3100 MHz durch die Bank weg!

Bei Ada ist bei minimal 2800 bis maximal 2900MHz das absolute Ende auf dem Chip erreicht!

5 % mehr Powertarget bei Blackwell sind mehr als 5 % extra Leistung,

je nach Game im Vergleich zu Ada! (Erklärt in Drittens)

Drittens, ich gehe davon aus, da "Pro Takt" (Clock zu Clock) gesehen Blackwell je nach Game etwa 3-6 % schneller ist als Ada allein durch die "Architektur Verbesserungen".

Mit der Architektur ist Nvidia ganz offensichtlich an das thermische Limit des Fertigungsprozesses gegangen.

Darum keine besagte Hotspot-Temperatur auslesbar wird.

Jetzt bitte nicht einfach "Plump" die von mir genannten Prozente zusammen addieren!

Ein Game profitiert mehr von Bandbreite, das andere mehr von der verbesserten Architektur,

das andere rennt früher in das Powertarget, das andere wiederum nicht!

Die Varianz aller Games ist sehr groß!

Es wird selten alle von mir genannten Punkte zu 100 % voll auf einmal in einem Spiel eintreffen.

Wer bis jetzt alle hier gelesen hat, bekommt von mir einen Orden! 🙌

So wieder bubu machen! 😴

Gruß

Mehlstaub

Snoopy69

Commodore

- Registriert

- März 2004

- Beiträge

- 4.446

@MehlstaubtheCat

Genau das war auch mein Gedanke. Wollte aber noch andere Meinungen lesen/hören (Gewinn vor Transparenz)

Trotzdem finde ich Hotspot nicht unwichtig, bei falscher/fehlerhafter Montage bzw. alternder Paste. Ich wäre schon mit nur 4 Hotspot-Sensoren - jeweils einer an jeder Ecke zufrieden

Genau das war auch mein Gedanke. Wollte aber noch andere Meinungen lesen/hören (Gewinn vor Transparenz)

Trotzdem finde ich Hotspot nicht unwichtig, bei falscher/fehlerhafter Montage bzw. alternder Paste. Ich wäre schon mit nur 4 Hotspot-Sensoren - jeweils einer an jeder Ecke zufrieden

MehlstaubtheCat

Vice Admiral

- Registriert

- Sep. 2013

- Beiträge

- 6.301

Wieso an den Ecken?

Hotspot Sensoren sind an den Ecken komplett sinnfrei,

dort hat der Chip bei keinem Hersteller die meiste Abwärme.

Die müssen da positioniert sein, an den Punkten mit der meisten Abwärme.

Das Ganze wird ja vorher auch simuliert, an welche Plätzen das je nach Architektur dann auch ist.

Das kann man sehr präzise, sogar vorher sehen.

Wäre dem nicht so, würde das "Delta" zur GPU Temperatur viel kleiner ausfallen.

Jeder Hersteller versucht so gut wie möglich auf der gesamten Chipfläche die Wärme zu verteilen.

Je kleiner die Struktur, umso wichtiger wird das ganze.

Btw, ich bin mir sicher das Nvidia wieder die Hotspottemperatur anzeigen wird,

mit der nächsten Generation, wenn die Temperatur wieder in einem Kundenverträglichen "Fenster" ist.

Gruß

Mehlstaub

Hotspot Sensoren sind an den Ecken komplett sinnfrei,

dort hat der Chip bei keinem Hersteller die meiste Abwärme.

Die müssen da positioniert sein, an den Punkten mit der meisten Abwärme.

Das Ganze wird ja vorher auch simuliert, an welche Plätzen das je nach Architektur dann auch ist.

Das kann man sehr präzise, sogar vorher sehen.

Wäre dem nicht so, würde das "Delta" zur GPU Temperatur viel kleiner ausfallen.

Jeder Hersteller versucht so gut wie möglich auf der gesamten Chipfläche die Wärme zu verteilen.

Je kleiner die Struktur, umso wichtiger wird das ganze.

Btw, ich bin mir sicher das Nvidia wieder die Hotspottemperatur anzeigen wird,

mit der nächsten Generation, wenn die Temperatur wieder in einem Kundenverträglichen "Fenster" ist.

Gruß

Mehlstaub

Snoopy69

Commodore

- Registriert

- März 2004

- Beiträge

- 4.446

Hat seine GründeMehlstaubtheCat schrieb:Wieso an den Ecken?

Hotspot Sensoren sind an den Ecken komplett sinnfrei,

dort hat der Chip bei keinem Hersteller die meiste Abwärme.

Natürlich hätte ich gerne jeden mm² einen Sensor bestenfalls für JEDEN Transistor

MehlstaubtheCat schrieb:Ich glaube nicht, dass es eine "Schutzschaltung" (ich würde es anders nennen!)

bei 4000 oder 5000 Karten gibt.

(Klar, Max Drehzahl ab 105 bis 110 Grad glaube, ich war es, ist Standard,

dann abschalten, das meine ich aber nicht damit!)

Schutzschaltung:

https://www.computerbase.de/forum/t...100-bei-einer-temperatur-von-65-grad.2242980/

Ich meine das schon mit Schutzschaltung: Lüfter bei zu hohem Hotspot auf 3500 1/min. Schutzschaltung sozusagen, damit der Chip nicht kaputt geht. Auch alle Einstellungen im AB an den Lüftern werden umgangen.

Das konnte ich bei 4080 und 5080 nicht erzeugen. Edge bei 87 bis 89°C und die auf 30% festgesetzten Lüfter blieben dort. Daher sollte die kritische Hotspot-Temperatur nicht erreicht gewesen sein. Hier dann Takt runter, um die Einstellung im AB nicht zu umgehen und um Edge trtzdem zu halten. Wobei GPU-Z bei der 5080 Powertarget angezeigt hat, die gleichzeitig auch erreicht waren im Test. Die 4080 hatte Thermathrottling angezeigt. Die 5080 war beim Takt bei 26xx und auch die 4080 irgendwo in dem Bereich.

Bei der Hotspot-Theorie muss ja bei 85°C Edge der Hotspot dann bei 120°C und bei meinen 87 muss der Hotspot theoretisch bei ~125°C gewesen sein.

Entweder muss Nvidia die erlaubte Hotspot-Temperatur erhöht haben oder die Differenzen sind doch nicht so groß und sind "nur" bei um die 15-20K, um knapp unter der Begrenzung von 110 zu bleiben, bei meiner Karte.

Damals hatte ich eine Gainward 2080, nach knapp einem Jahr irgendwo bei 76°C Lüfter auch auf die 3500 1/min, mit Sicherheit war es auch der Hotspot. Auch testweise Lüftersteuerungseinstellungen, auch da wurden sie umgangen.

Früher die legendäre Thermi-Serie, 480 konnte man auf 105°C bringen. Wenn das Edge war und es auch da die Karte schon intern Hotspot kannte, kann man dann sicherlich auch von 120-140°C ausgehen, es sei denn, es gab die Unterscheidung nicht und 105 war bereits die höchste Temperatur. Entsprechende Karte hat sich nicht abgeschaltet, bzw. der PC.

Eine 465, die ich 2014 rum als Notkarte hatte und sie zur 470 flashte, ging hingeben bei rund 100°C einfach aus, statt Lüfter hochzudrehen, bzw. der PC ging aus.

Was ist eigentlich die aktuelle FOTM Vorgehensweise für das Editieren der Kurve beim Undervolting? Seit der 30x0 Serie verfolge ich das und irgendwie gibt es immer wieder neue Varianten die angeblich besser oder schlechter sein sollen. Aktuell orientiere ich mich an diesem Guide hier (im Wesentlichen nur die Punkte von 810 bis 890 mV hochziehen und anschließend alles rechts der Punkte glätten). Zuvor hatte ich aber z.B. die Variante genutzt erst mit +Core die komplette Kurve hochzuziehen und dann von da weiterzuarbeiten (was dann aber auch die Idle Clocks hochzieht).

Ist man sich hier mittlerweile über eine allgemeine Vorgehensweise einig?

Ist man sich hier mittlerweile über eine allgemeine Vorgehensweise einig?

So, neue Karte, neues Spiel! :-)

Anbei meine ersten Ergebnisse mit der 5090 FE. Ich habe bisher nur UV betrieben und den RAM nicht angefasst (der wird so schon ausreichend warm und der Mehrwert im Gaming ist eher homöopathisch).

Stabilität wurde nicht getestet, lt. Reddit kann man bei der FE aber diese Werte problemlos laufen lassen, ich werde in den nächsten Wochen berichten, inwieweit das auch meinen Erfahrungen entspricht.

Key Takeaways:

Insgesamt ist die Karte ein Monster und auch von der 5080 kommend ein großes Upgrade. Cyberpunk mit DLLS Quality und Path-Tracing kommt mit 2x MFG auf meinem Samsung G9 auf über 120 FPS. Das ist schon beeindruckend.

Thermisch habe ich keinerlei Probleme, oben kommt halt viel warme Luft raus, aber die CPU liegt auch nach in einer 2h Cyberpunk-Session in Stock Settings (etwa 530W Verbrauch im Mittel) bei 77 Grad. Der VRAM wird wie erwartet recht warm (immer mal wieder auch über 90 Grad), aber das ist ja so spezifiziert.

Anbei meine ersten Ergebnisse mit der 5090 FE. Ich habe bisher nur UV betrieben und den RAM nicht angefasst (der wird so schon ausreichend warm und der Mehrwert im Gaming ist eher homöopathisch).

Stabilität wurde nicht getestet, lt. Reddit kann man bei der FE aber diese Werte problemlos laufen lassen, ich werde in den nächsten Wochen berichten, inwieweit das auch meinen Erfahrungen entspricht.

| Spannung (eingestellt in AB) | Takt (eingestellt in AB) | Takt Steel Nomad (Schnitt) | Score | Änderung Score | Power (ca. im Schnitt) | Änderung Verbrauch |

|---|---|---|---|---|---|---|

| Stock | Stock | 2.590 MHz | 13824 | 0 | 575W | 0 |

| 0.895V | 2.897 MHz | 2.630 MHz | 14303 | +3,46% | 505W | -12,17% |

| 0.875V | 2.572 MHz | 2.445 MHz | 13584 | -1,74% | 450W | -21,74% |

| 0.845V | 2.152 MHz | 2.109 MHz | 11788 | -14,73% | 365W | -36,52% |

| Stock (PL 104%) | +250 MHz | 2.810 MHz | 14384 | +4,05% | 600W | +4,35% |

Key Takeaways:

- Undervolting ist bei der Karte ein Must. Die Karte läuft sogar schneller bei weniger Verbrauch. 12,17% weniger Verbrauch klingt jetzt erstmal nicht so wahnsinnig viel. In absoluten Zahlen sind gesparte 70 Watt einfach mal mehr als ein Viertel (28%) des gesamten TDP einer RTX 5070!

- Man kann etwa 20% Verbrauch (=115 Watt oder 46% des gesamten TDP einer RTX 5070) einsparen, bevor man Leistung verliert.

- Auf dem TDP-Level einer 5080 (in meinem Fall im Schnitt 5 Watt drüber) ist die Karte etwa 37% schneller (Vergleichswert 8.550, siehe hier, wobei die Werte mit den neueren Treibern wieder leicht runtergegangen sind, so zumindest meine Erfahrung mit der AORUS "damals"). Allerdings kommt man dafür nicht in die Verbrauchsregionen einer 5080 mit UV.

- OC führt zumindest bei mir zu wenig. Ich vermute, dass meine Karte thermisch limitiert ist und daher den hohen Takt nicht konstant halten kann/will und es daher Abzüge im Benchmark gibt. Anders kann ich mir nicht erklären, dass die Karte mit 95 Watt und 180 MHz höheren Durchschnittstakt einen kaum höheren Score als die UV-Variante mit 0.895V liefert. Durchschnittliche Temperatur sieht mit 70 Grad allerdings grds. nicht so schlecht aus.

Insgesamt ist die Karte ein Monster und auch von der 5080 kommend ein großes Upgrade. Cyberpunk mit DLLS Quality und Path-Tracing kommt mit 2x MFG auf meinem Samsung G9 auf über 120 FPS. Das ist schon beeindruckend.

Thermisch habe ich keinerlei Probleme, oben kommt halt viel warme Luft raus, aber die CPU liegt auch nach in einer 2h Cyberpunk-Session in Stock Settings (etwa 530W Verbrauch im Mittel) bei 77 Grad. Der VRAM wird wie erwartet recht warm (immer mal wieder auch über 90 Grad), aber das ist ja so spezifiziert.

Zuletzt bearbeitet:

Da würde ich standardmäßig mit 0.845V starten und nur bei Bedarf auf 0.875V oder 0.895V gehen.

Die Hotkeys in Afterburner sind schon extrem praktisch. Starte auch mit den niedrigsten bzw sparsamsten Settings. Kann mich jedoch kaum erinnern bei einem Spiel mal höher geschaltet zu haben - Meist sieht man nur massiv mehr Watt und effektiv ein paar Frames mehr.

Die Hotkeys in Afterburner sind schon extrem praktisch. Starte auch mit den niedrigsten bzw sparsamsten Settings. Kann mich jedoch kaum erinnern bei einem Spiel mal höher geschaltet zu haben - Meist sieht man nur massiv mehr Watt und effektiv ein paar Frames mehr.

MehlstaubtheCat

Vice Admiral

- Registriert

- Sep. 2013

- Beiträge

- 6.301

FoXz schrieb:Der VRAM wird wie erwartet recht warm (immer mal wieder auch über 90 Grad), aber das ist ja so spezifiziert.

Also haben wir mit UV 70°C Edge und 90°C VRAM? Und wie ist es bei Stock?

Die Speichertemperatur ist fast schon enttäuschend dafür, dass der Nvidia-Referenzkühler doch der geile Shit ist.

Zuletzt bearbeitet:

Nein, das sind die Stock-Werte bei/nach 2h Cyberpunk. Hatte das mal getestet, um zu schauen, ob mein Setup ausreichend gut belüftet ist für die Karte in Stock.Banger schrieb:Also haben wir mit UV 70°C Edge und 90°C RAM? Und wie ist es bei Stock?

Aber ja, RAM-Temp ist ohne Zweifel enttäuschend. Auch mit 70W weniger Belastung kommen da gerne 82 Grad raus.

@MehlstaubtheCat Mache ich die Tage, bin gerade nicht zu Hause.

@MehlstaubtheCat: Um nochmal auf die Hotspot-These zu kommen. Ich habe mal nachgetestet, weil Raumtemp. mit 27°C unnötig hoch.

RE4 Demo, Startbildschirm, Stock-Einstellungen, aber mit Powertarget 110%. Lüfter auf 30% / 1000 1/min im AB festgesetzt. Takt am Anfang rund 2775. Hat sich mit steigender Temperatur auf rund 2670MHz abgesenkt, während es an der am Rand zu den 88°C verblieb. Die Boardpower sank von rund 385W auf rund 375W und entsprechend die Spannung leicht runter. Jetzt der Clou, ich habe die TDP-Begrenzung auf 100% zurückgesetzt. Boardpower ging zurück auf 360W, die Temperatur auf 86°C, der Takt leicht hoch auf rund 2700MHz.

Für mich sieht das nach Thermal Throttle aus, anhand von GPU-Edge. Die Lüfter sprangen nicht auf 3500 1/min, also kickte keine Schutzschaltung rein, die es theoretisch geben müsste, da es die bei 4080 und 2080 gab.

2 Thesen, entweder der Abstand zwischen Edge und Hotspot ist doch nicht so groß und die Begrenzung ist weiterhin 110°C und der nicht auslesbare Hotspot ist bei ca. 105-108°C bei dieser Karte.

Andere These, die Begrenzung wurde auf ca. 130°C erhöht und war bei der Karte dann ca. bei 125°C und weil es den User verunsichern kann, zensiert Nvidia den Hotspot.

Satte 8°C Ersparnis durch UV. Meine Ersparnis beim Speicher ist bei 0-2°C. Da der Speichersensor keine Zwischenwerte kann, kann man im Durchschnitt von 1°C Ersparnis ausgehen. Beim GPU-Edge sind 4°C weniger üblich. Aber jetzt der Punkt, Speichertemperatur ist im GPU-Limit dann auch eher bei um die 70°C+- bei Stock-Settings.

Achso, Cyberpunk in welcher Auflösung? Spiele in UHD lasten auch den Speichercontroller stärker aus und höhere Speichercontrollerauslastung erzeugt eine höhere Speichertemperatur.

RE4 Demo, Startbildschirm, Stock-Einstellungen, aber mit Powertarget 110%. Lüfter auf 30% / 1000 1/min im AB festgesetzt. Takt am Anfang rund 2775. Hat sich mit steigender Temperatur auf rund 2670MHz abgesenkt, während es an der am Rand zu den 88°C verblieb. Die Boardpower sank von rund 385W auf rund 375W und entsprechend die Spannung leicht runter. Jetzt der Clou, ich habe die TDP-Begrenzung auf 100% zurückgesetzt. Boardpower ging zurück auf 360W, die Temperatur auf 86°C, der Takt leicht hoch auf rund 2700MHz.

Für mich sieht das nach Thermal Throttle aus, anhand von GPU-Edge. Die Lüfter sprangen nicht auf 3500 1/min, also kickte keine Schutzschaltung rein, die es theoretisch geben müsste, da es die bei 4080 und 2080 gab.

2 Thesen, entweder der Abstand zwischen Edge und Hotspot ist doch nicht so groß und die Begrenzung ist weiterhin 110°C und der nicht auslesbare Hotspot ist bei ca. 105-108°C bei dieser Karte.

Andere These, die Begrenzung wurde auf ca. 130°C erhöht und war bei der Karte dann ca. bei 125°C und weil es den User verunsichern kann, zensiert Nvidia den Hotspot.

Ergänzung ()

FoXz schrieb:Aber ja, RAM-Temp ist ohne Zweifel enttäuschend. Auch mit 70W weniger Belastung kommen da gerne 82 Grad raus.

Satte 8°C Ersparnis durch UV. Meine Ersparnis beim Speicher ist bei 0-2°C. Da der Speichersensor keine Zwischenwerte kann, kann man im Durchschnitt von 1°C Ersparnis ausgehen. Beim GPU-Edge sind 4°C weniger üblich. Aber jetzt der Punkt, Speichertemperatur ist im GPU-Limit dann auch eher bei um die 70°C+- bei Stock-Settings.

Ergänzung ()

Achso, Cyberpunk in welcher Auflösung? Spiele in UHD lasten auch den Speichercontroller stärker aus und höhere Speichercontrollerauslastung erzeugt eine höhere Speichertemperatur.

Zuletzt bearbeitet:

Auflösung war 5120x1440, das ist ein bisschen weniger anspruchsvoll als 4K. Allerdings inkl Path Tracing und auch sonst alles auf Anschlag - dafür hab ich die Karte ja geholt.

Ich halte das Kühlerdesign trotz der für meinen Geschmack zu hohen Temperaturen bzw. Zu hoher Lautstärke für ein Meisterwerk.

Die Karte ist einfach winzig im Vergleich zu AIB-Karten und funktioniert trotzdem völlig problemlos und kühlt 575W leiser weg, als eine 5070 Ti Ventus deren 300W.

Hier mal im Vergleich zu meiner vorherigen Aorus Master. Im Quervergleich der AIBs eine sehr wertige Karte, ggü. der FE ein plumper Klotz.

Nvidia ist mit dem krassen SFF aus meiner Sicht dabei lediglich etwas übers Ziel hinaus geschossen. Einerseits geil, wenn man wirklich einen superschnellen, offenen SFF-Build plant. Man hätte die Karte und das PCB aber ansonsten einfach ein kleines bisschen größer machen können, um dem RAM ein bisschen mehr Platz für Abwärme zu geben und auf 120mm-Lüfter zu gehen. 2,5cm in der Länge und 1cm in der Breite hätten dann wahrscheinlich schon gereicht, um die Lautstärke auf die einer Mittelklasse-AIB-Karte zu senken. Das wäre dann immer noch eine sehr kleine 2-Slot-Karte gewesen.

Ich halte das Kühlerdesign trotz der für meinen Geschmack zu hohen Temperaturen bzw. Zu hoher Lautstärke für ein Meisterwerk.

Die Karte ist einfach winzig im Vergleich zu AIB-Karten und funktioniert trotzdem völlig problemlos und kühlt 575W leiser weg, als eine 5070 Ti Ventus deren 300W.

Hier mal im Vergleich zu meiner vorherigen Aorus Master. Im Quervergleich der AIBs eine sehr wertige Karte, ggü. der FE ein plumper Klotz.

Nvidia ist mit dem krassen SFF aus meiner Sicht dabei lediglich etwas übers Ziel hinaus geschossen. Einerseits geil, wenn man wirklich einen superschnellen, offenen SFF-Build plant. Man hätte die Karte und das PCB aber ansonsten einfach ein kleines bisschen größer machen können, um dem RAM ein bisschen mehr Platz für Abwärme zu geben und auf 120mm-Lüfter zu gehen. 2,5cm in der Länge und 1cm in der Breite hätten dann wahrscheinlich schon gereicht, um die Lautstärke auf die einer Mittelklasse-AIB-Karte zu senken. Das wäre dann immer noch eine sehr kleine 2-Slot-Karte gewesen.

Ähnliche Themen

- Antworten

- 1.634

- Aufrufe

- 190.755

- Antworten

- 2.318

- Aufrufe

- 348.048

- Antworten

- 3.792

- Aufrufe

- 350.055