Also wenn ich das jetzt nach den ganzen Tests die ich gemacht habe richtig interpretiere dann kommt man mit dem Furmark-Stresstest durch die gesamte Auslastung der GPU früher ins Powerlimit und dies ist dann wohl auch der Grund weshalb die Taktfrequenzen niedriger sind als "normal".^^

Ich bin so vorgegangen das ich erst geschaut habe auf welche Taktfrequenz Furmark meine GPU mit 100% PL limitiert.

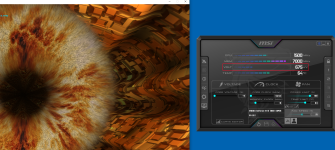

Die lagen immer zwischen 1400 MHz und 1600 MHz, danach habe ich getestet wie weit ich mit 1500 MHz als max. Taktfrequenz per Afterburner undervolten kann, das waren dann 700 mV.

Und dann bin ich mit dem Powerlimit soweit heruntergegangen wie möglich ohne das die Karte ins Powerlimit läuft, das waren 85%.

Dachte ich, aber Furmark zeigt mir trotzdem noch "Powerlimit: 1" an, was bedeutet das ich trotzdem im Powerlimit bin?^^

Zumindest wenn ich die Benchmark-Ergebnisse vergleiche ist das die Erklärung für mich, ich habe mit 100% PL, 1650 MHz @ 750 mV (Afterburner) 158 FPS im Durchschnitt.

Und mit 85% PL, 1500 MHz @ 700 mV (Afterburner) 140 FPS im Durchschnitt.

Das interessante dabei waren die tatsächlichen Taktfrequenzen, bei dem Benchmark mit 1650 MHz (Afterburner) lagen die laut Furmark nur zwischen 1300 MHz und 1400 MHz, bei dem mit 1500 MHz (Afterburner) zwischen 1400 MHz und 1500 MHz.

Und die angezeigten TDP, bei 1650 MHz 99% und bei 1500 MHz 83%.

Also wenn ich das richtig verstehe dann wird je nach verfügbarer Leistung diese unterschiedlich aufgeteilt, so das trotz niedrigerem tatsächlichen Core-Takt mehr FPS erzielt werden als mit einem im Vergleich höheren Core-Takt.^^

Ich hoffe das war jetzt nicht zu verwirrend beschrieben.^^