- Registriert

- Mai 2011

- Beiträge

- 22.756

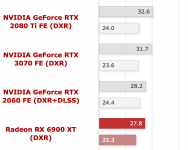

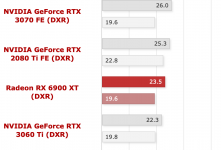

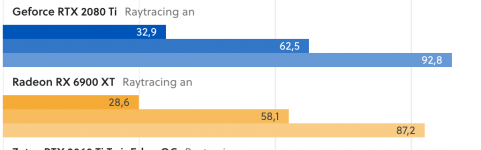

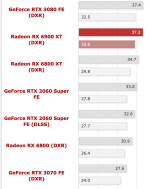

MMIX schrieb:rein von der nativen Leistung (also was die Architektur ohne "Tricks" her gibt) sind die Radeons sogar schneller und drittschnellste Kraft - für die erste RT Generation wohlgemerkt.

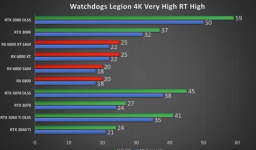

Drittschnellste Kraft ist man auch ohne DLSS nicht durchweg. Die 3070 liegt im Mittel bei CB genau gleichauf mit der 6800XT und dabei kommen die Radeons hier bei CB im Schnitt noch besser weg als bei anderen Reviews. Bei PCGH mit anderer Spieleauswahl ist die 3070 im RT z.B. 10% schneller als die 6800XT.

Und die 2080Ti, die auf dem Niveau der 3070 liegt, gibts dann auch noch.