144 Hz Desktop und YTDark Soul schrieb:Schalt bitte auch mal auf 144Hz zurück ob der Verbrauch auch bei dir raufgeht?

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Adrenalin 23.5.2: AMD rüstet Radeon-Grafikkarten für Diablo IV

- Ersteller Vitche

- Erstellt am

- Zur News: Adrenalin 23.5.2: AMD rüstet Radeon-Grafikkarten für Diablo IV

Dark Soul schrieb:Vielen Dank.

Gerne, gehe immer Konservativ an die Sache ran, Treiber immer drüber bügeln, Windows Ernergiesparmodus auf "Ausbalanciert" und der große Strahlen - Enthusiast bin ich auch nicht von daher habe ich definitiv Freude an der 7900XT.

Ich glaube in diesem Fall ist wirklich erst mit UHD die nötige Pixelmenge erreicht, damit die RX 7900 XT(X) dann den Speicher hochtaktet und entsprechend viel verbraucht. Wenn ich mich recht erinner haben wir das auch irgendwann mal getestet, aber das finde ich gerade auf die Schnelle nicht.

Hast du mal versucht beim ReLive das Desktop-Aufnehmen abzustellen?CastorTransport schrieb:@Taurus104

Ausprobiert, GescheitertWeiter ~60W Verbrauch... Hatte eh schon den Desktop auf nur 60Hz laufen. CVT nutzt auch nix leider. CVT Reduced Blanking bringt es runter auf knapp 52W... Das war es aber dann auch

Ergänzung ()

Dadurch falle ich bei der 5700xt und 6800xt von 40 auf 12 Watt.

Zuletzt bearbeitet:

Majestro1337

Commander Pro

- Registriert

- Sep. 2008

- Beiträge

- 2.981

snaapsnaap

Rear Admiral

- Registriert

- Apr. 2005

- Beiträge

- 5.202

Vitche schrieb:Ich glaube in diesem Fall ist wirklich erst mit UHD die nötige Pixelmenge erreicht, damit die RX 7900 XT(X) dann den Speicher hochtaktet und entsprechend viel verbraucht. Wenn ich mich recht erinner haben wir das auch irgendwann mal getestet, aber das finde ich gerade auf die Schnelle nicht.

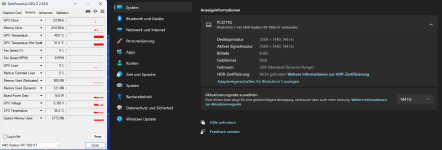

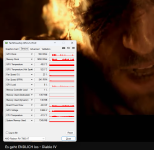

Hab aktuell schon 2x UHD und meine 7900XT braucht ~20W im "richtigen" idle wenn einer mit 60Hz läuft und der andere mit 120Hz, wichtig ist nur, das Adaptiv Sync beim 120Hz Monitor aktiv ist, sonst sind es auch 70W.

Laufen beide auf 60Hz ist es egal ob Adaptiv Sync aktiv ist oder nicht, solange GPU-Z nicht läuft, das erzeugt genug Last damit der Speichertakt hochgeht...

Anhänge

Hallo erstmal an alle

Auch ich hatte das Problem mit dem hohen idle Verbrauch.

Hatte meine XFX 7900XT Merc in Kombination mit 10850K + Asus Z590E und LG34GN850B am laufen.

Die Karte lief im Idle permanent mit Pcie 3.0 16X . Speichertakt konstant 909Mhz.

Verbrauch im Idle 42-50W.

Vor einigen Tagen, hab ich auf 13600KF +MSI Z790 Tomahawk DDR4 gewechselt.

Problem blieb dasselbe.

Konnte bei mir jetzt das Problem lösen, durch das Aktivieren vom Package C-State Limit im Bios.

Package C-State Limit Auto: Karte läuft konstant mit Pcie 4.0 16X. 909MHZ im Idle. 42-50W Board Power Draw.

Package C-State LImit C6, C8 oder C10 manuell gesetzt:

Karte taktet Pcie Anbindung runter. Speichertakt minimum 3 Mhz. Minimaler Verbrauch im Idle 9W.

Getestet mit 23.4.3, 23.5.1, 23.5.2

Auch ich hatte das Problem mit dem hohen idle Verbrauch.

Hatte meine XFX 7900XT Merc in Kombination mit 10850K + Asus Z590E und LG34GN850B am laufen.

Die Karte lief im Idle permanent mit Pcie 3.0 16X . Speichertakt konstant 909Mhz.

Verbrauch im Idle 42-50W.

Vor einigen Tagen, hab ich auf 13600KF +MSI Z790 Tomahawk DDR4 gewechselt.

Problem blieb dasselbe.

Konnte bei mir jetzt das Problem lösen, durch das Aktivieren vom Package C-State Limit im Bios.

Package C-State Limit Auto: Karte läuft konstant mit Pcie 4.0 16X. 909MHZ im Idle. 42-50W Board Power Draw.

Package C-State LImit C6, C8 oder C10 manuell gesetzt:

Karte taktet Pcie Anbindung runter. Speichertakt minimum 3 Mhz. Minimaler Verbrauch im Idle 9W.

Getestet mit 23.4.3, 23.5.1, 23.5.2

Zuletzt bearbeitet:

MehlstaubtheCat

Vice Admiral

- Registriert

- Sep. 2013

- Beiträge

- 6.334

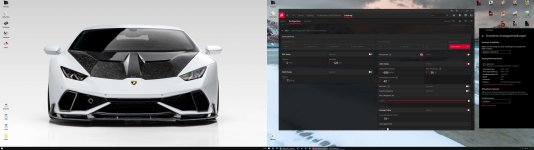

Treiber läuft Problemlos von heute Nacht 1Uhr bis 19 Uhr am Stück!

Wer noch Bock hat auf einen Diablo IV Clan

"Computerbase" <CB> der Clan ist öffentlich einsehbar.

"Diablo IV Sammerthread" in der Signatur

Danke!

Wer noch Bock hat auf einen Diablo IV Clan

"Computerbase" <CB> der Clan ist öffentlich einsehbar.

"Diablo IV Sammerthread" in der Signatur

Danke!

H

HierGibtsNichts

Gast

Sie testen es nicht mit jedem neuen Treiber. Das Diagramm ist aus einem der älteren Tests etwas nach Release von RX7900er Karten.Majestro1337 schrieb:Danke @Vitche, dass ihr das Thema idle Verbrauch immer wieder ansprecht und mit jedem Treiber testet - denn das hält mich ehrlich gesagt mit tripple Monitor setup vom Kauf ab...

Ergänzung ()

Interessant weil der Package C State eine Bios Einstellung für die CPU ist, nicht GPU.Johaho schrieb:Konnte bei mir jetzt das Problem lösen, durch das Aktivieren vom Package C-State Limit im Bios.

Package C-State Limit Auto: Karte läuft konstant mit Pcie 4.0 16X. 909MHZ im Idle. 42-50W Board Power Draw.

Package C-State LImit C6, C8 oder C10 manuell gesetzt:

Karte taktet Pcie Anbindung runter. Speichertakt minimum 3 Mhz. Minimaler Verbrauch im Idle 9W.

Getestet mit 23.4.3, 23.5.1, 23.5.2

ComputerJunge

Captain Pro

- Registriert

- Sep. 2018

- Beiträge

- 3.942

Genau. In der Umkehrung darf dies aber dann genauso kritisiert werden. Mann/Frau kann ja dennoch kaufen - oder es eben lassen.Wechhe schrieb:warum sollte AMD die Preise nicht marktüblich anpassen?

Ich habe dieses Jahr zum ersten Mal AMD bei einer Grafikkarte "den Rücken gekehrt" (für mich und mein Anforderungsprofil ist RDNA3 dieses Mal einfach das schlechtere Gesamtpaket*), auch wegen des möglichen Risikos, vom hohen Idle-Energieumsatz betroffen sein zu können.

Mittlerweile stellt dieses Thema sich ja aber nachweislich als deutlich differenzierter dar, als von mir zu Anfang befürchtet. Und Gegenmittel der einen oder anderen Art scheint es ja auch zu geben. Für die Betroffenen macht ist dies dadurch allerdings auch nicht besser - aber es reduziert unter Kaufinteressenten statistisch den Kreis möglich Betroffener, da man für das eigene Betriebsszenario "gute" Referenzen finden könnte.

Unschön ist es trotzdem - auch weil sich AMD dazu bisher nicht richtig offiziell geäußert hat (was aber im Falle eines nicht per Treiber zu behebenden Problems realistischerweise nicht zu erwarten ist).

Seit Februar bin ich nun erstmals Nvidia-Nutzer, soweit bisher alles ok (und die Effizienz ist beeindruckend). Das UI des nicht-Account-gebundenen Treibers hingegen ist von der erwarteten Altbackenheit (Catalyst nostalgia

*: Seit nun allen Treiberversionen seit Kauf listet Nvidia in den known issues Increase in DPC latency observed in Latencymon.

Dass dies in der Juni-Version (ok, vom 30.05.2023) immer noch der Fall ist, stimmt mich allerdings langsam nachdenklich. In meinem (Spiele-)Alltag spüre ich dadurch keine Auswirkungen. Aber ab Herbst werde ich mein "Studio" wieder ab und an "anschmeißen".

Sollte dies dann immer noch nicht gefixt sein, kann das für mich ein major bummer werden. Aus meiner (mittlerweile verdammt langen) Erfahrung frisst die Kompensation einer derartig hohen DPC-Latenz nämlich in der Regel einfach so mindestens 25% CPU-Leistung - mehr geht auch ohne Probleme (abhängig vom Gesamtsystem). Und DPC-Latenz optimiert sich nicht "mal eben so". Es wäre jedenfalls mehr als ätzend, wenn das im September immer noch bei den issues gelistet würde.

Majestro1337

Commander Pro

- Registriert

- Sep. 2008

- Beiträge

- 2.981

Was ich vermisse ist ein Tool wie damals der multi display power saver im nvidia inspector nur eben für die AMD Karten. Der hat mir immer treue Dienste geleistet.Taurus104 schrieb:Interessant weil der Package C State eine Bios Einstellung für die CPU ist, nicht GPU.

Entweder kann oder will das hier aber keiner programmieren...

maikrosoft

Commander

- Registriert

- Mai 2007

- Beiträge

- 2.464

Bin gespannt wann es AMD endlich mal hin bekommt das Flackern von Videos in chromiumbasierten Browsern mit aktivierter Hardwarebeschleunigung zu fixen.

Auf Hardwarebeschleunigung 2023 zu verzichten mag für AMD ne Lösung sein, für mich nicht.

Einzige Abhilfe bisher, im Browser chrome://flags oder edge://flags eingeben, nach Angle suchen und den Wert auf D3D9 zu setzen.

Auf Hardwarebeschleunigung 2023 zu verzichten mag für AMD ne Lösung sein, für mich nicht.

Einzige Abhilfe bisher, im Browser chrome://flags oder edge://flags eingeben, nach Angle suchen und den Wert auf D3D9 zu setzen.

H

HierGibtsNichts

Gast

@maikrosoft Ist wohl kein bekanntes oder weitverbreitetes Problem denn es steht nicht in den Known Issues. Schon mal einen Bug Report über die Report Funktion dazu gemacht?

Davon ab, was macht es für einen Unterschied ob die CPU oder GPU ein Video beschleunigt in Chrome. Denn nichts weiter als das ist die Hardwarebeschleunigung. Aus - Cpu, an GPU.

Davon ab, was macht es für einen Unterschied ob die CPU oder GPU ein Video beschleunigt in Chrome. Denn nichts weiter als das ist die Hardwarebeschleunigung. Aus - Cpu, an GPU.

maikrosoft

Commander

- Registriert

- Mai 2007

- Beiträge

- 2.464

@Taurus104 Der Bug ist schon ewig bekannt und wurde "laut AMD" mit irgend nem 22er Treiber gefixt.

Aktuell ist es so das bei einem laufenden Video das Bild weis flackert wenn man zum Beispiel durch Ordner im Dateiexeplorer navigiert, oder bissi im Taskmanager arbeitet.

Und hardwarebasierte- (GPU) Video(de)kodierung sieht halt besser aus wie sofatwarebasierte (CPU)

Aktuell ist es so das bei einem laufenden Video das Bild weis flackert wenn man zum Beispiel durch Ordner im Dateiexeplorer navigiert, oder bissi im Taskmanager arbeitet.

Und hardwarebasierte- (GPU) Video(de)kodierung sieht halt besser aus wie sofatwarebasierte (CPU)

H

HierGibtsNichts

Gast

Wie gesagt Bugreport. Dafür gibt es die Option/Funktion ja. Weil der Bug ist eben längst behoben. Ich persönlich habe da 3x AMD GPU Systeme mit 7900XTX, 6750XT und Radeon VII und hier ist noch seit dem Fix nie mehr was Auffälliges gewesen. Ich denke mal das ist wenn bei dir etwas "individuelles" an Problem.maikrosoft schrieb:Der Bug ist schon ewig bekannt und wurde "laut AMD" mit irgend nem 22er Treiber gefixt.

Aktuell ist es so das bei einem laufenden Video das Bild weis flackert wenn man zum Beispiel durch Ordner im Dateiexeplorer navigiert, oder bissi im Taskmanager arbeitet.

Und hardwarebasierte- (GPU) Video(de)kodierung sieht halt besser aus wie sofatwarebasierte (CPU)

Das man hier einen Unterschied erkennt mit bloßem Auge bei der Darstellung von Videos auf YT, von Netflix etc auf 27, 32 Zoll egal ob 2k/4k Monitoren bezweifle ich. Alleine wegen der Kompressionsrate der Daten des einzelnen Bildes.

NoNameNoHonor

Lt. Commander

- Registriert

- Nov. 2020

- Beiträge

- 1.078

Da ich nur einen Ultrawide-Monitor habe, und auch keine AMD 7900er Karte, sondern nur eine 6800XT, kann ich das irgendwie nicht nachvollziehen. Ich habe allerdings auch keine 144Hz für den Windows-Desktop eingestellt, sondern nur 75Hz. Bei mir sind es im Idle unter 10W.CastorTransport schrieb:@Taurus104

Ausprobiert, GescheitertWeiter ~60W Verbrauch... Hatte eh schon den Desktop auf nur 60Hz laufen. CVT nutzt auch nix leider. CVT Reduced Blanking bringt es runter auf knapp 52W... Das war es aber dann auch

Anhänge

darkbreeze

Lt. Commander

- Registriert

- Jan. 2008

- Beiträge

- 1.265

H0chi schrieb:Die Werte im Artikel sind einfach lächerlich. Ich hab hier auch eine 7900 XTX und im Desktop Idle bewege ich mich bei 4k und 144Hz zwischen 14 Watt und 45 Watt.

Dem kann ich nur zustimmen. Habe mein System die Tage aufgerüstet auf ein 5800X3D und eine Sapphire Pulse 7900 XT. Fürs Gaming habe ich die Grafikkarte undervolted und das Power Limit gesenkt.

Im Idle verbrauche ich bei 4k@60Hz zwischen 12-25W.

Anhänge

Ähnliche Themen

- Antworten

- 348

- Aufrufe

- 28.278

- Antworten

- 187

- Aufrufe

- 24.087

- Antworten

- 140

- Aufrufe

- 16.813

- Antworten

- 60

- Aufrufe

- 10.881

- Antworten

- 41

- Aufrufe

- 6.432