Nach dem Update 2: NVIDIA produziert jetzt echte Verluste, das weißt auf eine tiefgreifende Fehleinschätzung des Managements hin. Könnte sein, daß man vorbeugend auf AMD reagieren wollte und nun die die Reaktionen, die man bereit war hinzunehmen, unterschätzt hatte.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News GeForce RTX 4080 12GB: Nvidia streicht Grafikkarte wegen falscher Bezeichnung

- Ersteller SVΞN

- Erstellt am

- Zur News: GeForce RTX 4080 12GB: Nvidia streicht Grafikkarte wegen falscher Bezeichnung

X8Koenig

Lt. Junior Grade

- Registriert

- Aug. 2019

- Beiträge

- 465

Lamaan schrieb:Danke für Deinen Beitrag, das ist interesant.

Ich denke aber, dass dieses Diagramm die Kosten für Neueinsteiger zeigt.

Als längjähriger Kunde hat man bestimmt über die Zeit brauchbare Software sowie andere Werkzeuge und Knowhow gesammelt und vlt. auch bessere Preise.

Danke für den Link. Ist schon erstaunlich was Nvidia zeitweise an Margen eingefahren hat. Natürlich hast Du recht, diese Diagramme bezeichnen vermutlich ein SoC/ASIC Design was man von "Scratch" aus entwickelt.

Im Falle von GPU Designs von Nvidia oder AMD ist das natürlich eine stetige Entwicklung wo z.B. Verifikationsumgebung, Testumgebung, SW Entwicklung, etc ... an das jeweilige neuste Design angepasst wird bzw diese Kosten nicht im vollen Umfang anfallen. das eigenliche HW Design bleibt aber, da verschiedene Derivate einer Architektur aber auf gleichen HW Blöcken bzw IPs basieren ist nicht jeder Chip ein komplett neues Design.

Zuletzt bearbeitet:

Simanova

Vice Admiral

- Registriert

- Dez. 2012

- Beiträge

- 6.642

Mein Gott. Ungeborene Kinder dürfen von ihren Eltern auch beliebig oft umbenannt werden. Der Name wird halt dann festgelegt, wenn die Hardware in trockenen Tüchern ist. Ist natürlich blöd wenn ein Elternteil schon blaue Klamotten gekauft hat und was anderes bei rausspringt.

AuroraFlash

Lt. Commander

- Registriert

- Juni 2007

- Beiträge

- 1.585

"Recession session! Give me better days, give me better days."Haggi20 schrieb:Wenn die Karte alle Spieler begeistern soll, dann muss Nvidia davon absehen in einer Rezession Mondpreise zu verlangen.

Gaming ist ein Dauermordopfer. _______ Psychologen versuchen, Glücksspielverhaltensmuster mit der Brechstange zu implementieren und NVIDA ________ die Geldbörsen enthusiastischer Spieler. Wie fühlt sich das an? ********* !11!!!!

Aber der PC-Boom 20/21 ist vorbei und das bedeutet. dass sie noch verzweifelter sind, jetzt den letzten Groschen aus den Beuteln der Gebeutelten zu schütteln.

Gr33nHulk

Commodore

- Registriert

- Mai 2007

- Beiträge

- 5.082

Creeper777 schrieb:Nur weil ein paar Klugscheißer meinen da müsste eine 70 statt einer 80 stehen, wird jetzt so ein Aufriss gemacht.

Sowas ist einfach nur Bullshit.

Keiner ist verpflichtet die Karten zu kaufen!

Und ich glaube anhand der RAM konnte man gut erkennen das es sich um eine schwächere Karte handelt.

Hat ja schließlich auch keiner einen Aufriss gemacht, als eine 3080 mit 10Gb, eine 3080 mit 12GB und eine 3080 Ti mit 12 GB erschienen ist.

Anhang anzeigen 1271698

Leute wie Du können echt froh sein, daß es diese "Klugscheißer" gibt, würdest dich mal schön blöd umschauen in was für einer Welt wir leben würden, wenn jeder sich auch noch herzlich Bedanken würde nachdem er einen Haufen Mist beigefahren bekommt.

Und noch mal für die begriffstutzigen:

- was sagt denn der RAM einer Karte über deren Chip aus........ah warte, gar nichts

- Die 3080 12GB kam viel später wie die 10GB auf den Markt und war eine Reaktion auf die mal wieder Krüppel-Ausstattung seitens Nvidia -> zudem basiert eben jede 3080 auf dem selben Chip, die 4080 nicht! Mit großen Performanceunterschieden als Resultat!

- Das Ti im Namen gibt schlussendlich jedem einen Hinweis darauf, daß es sich hier um eine andere Klasse handelt, bei der 3080 Ti passt das also, da hat der VRAM gar nichts mit zu tun, auch wenn der immer noch zu wenig ist

- Warum sollte man etliche Jahre lange Klasseneinstufungen, Namensgebungen und Performancesegmente auf einmal komplett unnütz machen, Preise hoch treiben für Hardware die weniger Leistung bringt wie das Produkt suggeriert........richtig, um Leute wie dich erfolgreich zu melken und das klappt auch noch prima!

Wintermute

Fleet Admiral

- Registriert

- Feb. 2003

- Beiträge

- 14.729

Danke für deine Mühe. Klar, da bin ich dabei, der Markt ist anspruchsvoller geworden. Wir können dazu auch leider nicht in die Firmen reingucken, um eine abschließende Bewertung vorzunehmen. Ein paar Sachen liegen ja offen, wie die von dir angesprochenen Margen. Nvidia hatte teils Nettomargen über 40%. Da sind wir in einem Bereich, wo es schwer zu erklären ist, dass er für nachhaltiges Wirtschaften notwendig ist. Speziell nach dem Industrie-Boom während COVID. AMD hängt bei im Schnitt 15% und kommt auch über die Runden. In meinen Augen wird hier Geld verdient, weil man es kann. Ist ja auch kein Problem normalerweise - bloß diese Ausmaße sind langsam over the top. Eine 3080 für 1200+ ist einfach nicht als "die Entwicklung ist so teuer geworden" verkaufbar. Zumindest mir nicht..Sentinel. schrieb:Zudem bitte ich, die Nettomargen als Bewertungsmaßstab zu bemühen.

Hier wird das "Leid" besonders gut sichtbar:

Dabei auch zu sehen, dass Gaming mehr als Data Center macht:

Um sicher zu gehen müsste man da viel tiefer buddeln. Ich wage mich aber so weit aus dem Fenster zu lehnen und zu vermuten, dass diese Gewinne für den reinen zukünftigen Geschäftsbetrieb mindestens 2x ausreichen.

Zuletzt bearbeitet:

Gortha

Banned

- Registriert

- Jan. 2017

- Beiträge

- 3.877

So ist das nunmal bei Oligopolen und stillem Einverständnis über Preisgestaltungen^^ Leider.Wintermute schrieb:In meinen Augen wird hier Geld verdient, weil man es kann. Ist ja auch kein Problem normalerweise - bloß diese Ausmaße sind langsam over the top.

ArrakisSand

Lieutenant

- Registriert

- Dez. 2019

- Beiträge

- 988

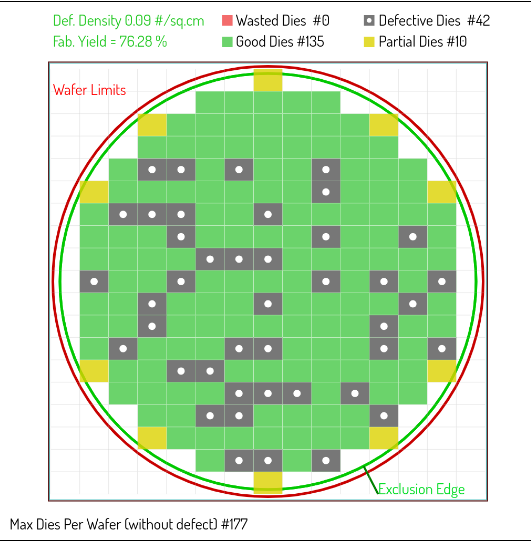

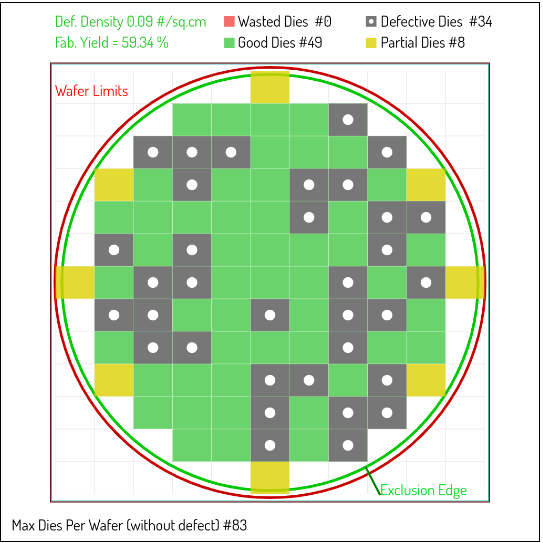

Nvidia hat sich einfach verkalkuliert. Hat zur Zeit massig Karten im Abverkauf, die niemanden so wirklich interessieren und zu gleich massig extrem teure Wafer bei TSMC bestellt, bei denen die Ausbeute an Dies bzw. die Yield-Rate sagen wir mal freundlich ausgedrückt ziemlich unterirdisch ist.

Der crypto mining boom ist auch vorbei und bei den Leuten sitzt das Geld auch nicht mehr so locker wie auch schon.

Das kann nur im Desaster enden und zu guter Letzt werden sie förmlich von AMD aus Preis-Leistungstechnischer Sicht pulverisiert und ins Nirvana geblasen. Ich würde mal behaupten das die Zeiten auf Sturm in Santa Clara stehen und wenn nicht bereits jetzt dann spätestens nächstes Jahr.

Gutes Beispiel RTX4080 12GB für 1099€ und wenn EVGA noch 4000er Karten verkaufen würde, würden sie wahrscheinlich noch draufzahlen.

Das Designziel das sich AMD mit RDNA3 wiederum auf die Fahnen geschrieben hat, ist im Gegensatz offensichtlich, aus einem extrem teuren Prozess so viel Performance / mm2 herauszuholen als möglich.

Mit anderen Worten in diesen schwierigen Zeiten, genau die richtige Entscheidung auch der einzig sinnvolle Weg in Anbetracht das die Design-Kosten von Prozess zu Prozess immer wie teurer werden.

Man muss sich bei AMD's Ansatz die im Raum stehenden Zahlen einfach mal auf de Zunge zergehen lassen:

NAVI 31: GCD mit 308mm2 (TSMC 5nm) mit 12288 Shading units.

Die zusätzlichen MCD's, die unter anderem die Speichercontroller und den IF-Cache beinhalten, sowie das wafer level packaging dürfte nur noch peanuts an den Gesamtkosten verursachen.

In Summe, dürfte NAVI31 wohl für in etwa für die Hälfte der Kosten eines AD102 zu fertigen sein.

Selbst wenn es sich am Ende herausstellen sollte, dass die RTX4090 10 -20% schneller ist, würde die voraussichtliche RX7900, wie auch die RTX7800 die jeweiligen Nvidia counterparts aus Preis/Leistungs Sicht förmlich zerstören.

NAVI 31: GCD mit 308mm2 (TSMC 5nm)

AD102: 608mm2 (TSMC 4nm)

Auch bei NAVI 32: GCD mit 200mm2 (TSMC 5nm) sieht es nicht besser aus.

AD103: 379mm2 (TSMC 4nm)

AD104: 295mm2 (TSMC 4nm)

Der crypto mining boom ist auch vorbei und bei den Leuten sitzt das Geld auch nicht mehr so locker wie auch schon.

Das kann nur im Desaster enden und zu guter Letzt werden sie förmlich von AMD aus Preis-Leistungstechnischer Sicht pulverisiert und ins Nirvana geblasen. Ich würde mal behaupten das die Zeiten auf Sturm in Santa Clara stehen und wenn nicht bereits jetzt dann spätestens nächstes Jahr.

Gutes Beispiel RTX4080 12GB für 1099€ und wenn EVGA noch 4000er Karten verkaufen würde, würden sie wahrscheinlich noch draufzahlen.

Das Designziel das sich AMD mit RDNA3 wiederum auf die Fahnen geschrieben hat, ist im Gegensatz offensichtlich, aus einem extrem teuren Prozess so viel Performance / mm2 herauszuholen als möglich.

Mit anderen Worten in diesen schwierigen Zeiten, genau die richtige Entscheidung auch der einzig sinnvolle Weg in Anbetracht das die Design-Kosten von Prozess zu Prozess immer wie teurer werden.

Man muss sich bei AMD's Ansatz die im Raum stehenden Zahlen einfach mal auf de Zunge zergehen lassen:

NAVI 31: GCD mit 308mm2 (TSMC 5nm) mit 12288 Shading units.

Die zusätzlichen MCD's, die unter anderem die Speichercontroller und den IF-Cache beinhalten, sowie das wafer level packaging dürfte nur noch peanuts an den Gesamtkosten verursachen.

In Summe, dürfte NAVI31 wohl für in etwa für die Hälfte der Kosten eines AD102 zu fertigen sein.

Selbst wenn es sich am Ende herausstellen sollte, dass die RTX4090 10 -20% schneller ist, würde die voraussichtliche RX7900, wie auch die RTX7800 die jeweiligen Nvidia counterparts aus Preis/Leistungs Sicht förmlich zerstören.

NAVI 31: GCD mit 308mm2 (TSMC 5nm)

AD102: 608mm2 (TSMC 4nm)

Auch bei NAVI 32: GCD mit 200mm2 (TSMC 5nm) sieht es nicht besser aus.

AD103: 379mm2 (TSMC 4nm)

AD104: 295mm2 (TSMC 4nm)

Gortha

Banned

- Registriert

- Jan. 2017

- Beiträge

- 3.877

@ArrakisSand Wenn dem so ist/wird, dann kann RDNA3 für uns alle ja nur ein Segen werden, gerade in Hinsicht Preis/Leistung.

.Sentinel.

Admiral

- Registriert

- Okt. 2007

- Beiträge

- 8.666

Ich bin mit allem einverstanden, zumal es keine Aufschlüsselungen der Nettomarge auf die einzelnen Geschäftbereiche gibt (zumindest habe ich bis jetzt diesbezüglich nichts öffentlich zugängliches gefunden).Wintermute schrieb:Anhang anzeigen 1271845

Um sicher zu gehen müsste man da viel tiefer buddeln. Ich wage mich aber so weit aus dem Fenster zu lehnen und zu vermuten, dass diese Gewinne für den reinen zukünftigen Geschäftsbetrieb mindestens 2x ausreichen.

Insofern ja- da müsste man viel tiefer buddeln.

Das einzige, was ich diesbezüglich eben "rausziehen" konnte, war dass das Datencenter- Geschäft die prozentuale Verteilung nach oben gezogen hat. Problem ist, dass man von den Einzelposten durch Vermischung unterschiedlichster Kennzahlen und keiner trennscharfen Aufschlüsselung nicht sehen kann, wie die Gesamtnettomarge für Gaminggrafikkarten aussieht.

Umsatz, Erlöse, Bruttomarge, Nettomarge und deren Betrachtungsweise in der Gesamtverrechnung in die Geschäftszahlen lassen enorm viel Spielraum für Zahlenschieberei.

Was man mit hoher Wahrscheinlichkeit sagen kann ist, dass sie die Nettomargen von 17-20% im Gaming auf 25-30% gesteigert haben.

Ob das jetzt aber in Anbetracht der aktuellen Lage so verwerflich ist, wage ich aus den von mir aufgeführten Gründen zu bezweifeln. Sie werden diesbezüglich meines Erachtens aber sicher auch für sich selbst großzügig kalkulieren und nicht so, dass sie auf Risiko fahren oder am Hungertuch nagen.

Zuletzt bearbeitet:

ThirdLife

Captain

- Registriert

- Aug. 2019

- Beiträge

- 3.966

Die Karte kam lediglich um die Marge bei den 3080ern zu erhöhen, man hat weniger 10G Modelle produziert und vermehrt die 12er auf den Markt geschmissen zu entsprechend höheren Preisen.Gr33nHulk schrieb:

- Die 3080 12GB kam viel später wie die 10GB auf den Markt und war eine Reaktion auf die mal wieder Krüppel-Ausstattung seitens Nvidia

Nightmar17

Lt. Commander

- Registriert

- Feb. 2020

- Beiträge

- 1.877

Wird es auch noch neue Karten für 300-500€ geben oder sind diese Zeiten vorbei?

B

Beg1

Gast

Ich kann natürlich nur meine Einschätzung abgeben, bestätigt ist bisher nur die 4080 16GB für 1469€.

Das aktuelle Lineup lässt nur schwer eine 4050/4060 zu und diese Karten würden EVENTUELL (selbst das ist beim aktuellen Preisgefüge unklar) in deinem Preisrahmen liegen, eventuell wird nvidia für die größte Käuferschicht nur Last-Gen (also z.B. RTX 3060/Ti) anbieten?

Kommt sicherlich auch darauf an, was AMD vorstellt, man darf gespannt in die Zukunft blicken.

Das aktuelle Lineup lässt nur schwer eine 4050/4060 zu und diese Karten würden EVENTUELL (selbst das ist beim aktuellen Preisgefüge unklar) in deinem Preisrahmen liegen, eventuell wird nvidia für die größte Käuferschicht nur Last-Gen (also z.B. RTX 3060/Ti) anbieten?

Kommt sicherlich auch darauf an, was AMD vorstellt, man darf gespannt in die Zukunft blicken.

ArrakisSand schrieb:In Summe, dürfte NAVI31 wohl für in etwa für die Hälfte der Kosten eines AD102 zu fertigen sein.

Selbst wenn es sich am Ende herausstellen sollte, dass die RTX4090 10 -20% schneller ist, würde die voraussichtliche RX7900, wie auch die RTX7800 die jeweiligen Nvidia counterparts aus Preis/Leistungs Sicht förmlich zerstören.

Schön dargelegt. Und wie sehr spielt das für den Endverbraucher eine Rolle, wenn sich AMD dem Markt anpasst und sich auch nur 10% preislich unter nVidia positioniert?

Die technische Seite ist die eine-, aber die betriebswirtschaftliche eine völlig andere.

Wintermute

Fleet Admiral

- Registriert

- Feb. 2003

- Beiträge

- 14.729

Der gesamte Unternehmenswert ist der Krise um dreistellige Prozente gestiegen. Jensen Huang verdient 13,6 Millionen im Jahr und sein Privatvermögen dürfte 2022 die 20 Milliarden-Grenze durchbrochen haben, das kam ja auch nicht aus dem Nichts. Nvidia geht's gerade so gut wie nie zuvor. In meinen Augen hat es also niemand nötig, derartige Margen zu fahren. Da kann man aber denke ich durchaus getrennter Meinung sein..Sentinel. schrieb:Ob das jetzt aber in Anbetracht der aktuellen Lage so verwerflich ist, wage ich aus den von mir aufgeführten Gründen zu bezweifeln.

ArrakisSand schrieb:

Dumme Frage: Ist es nicht möglich, da eckige Wafer zu machen, sodass die gelb markierten abgeschnittenenes Dies dann nicht mehr gibt?

S.Kara schrieb:Nur die Kartonagen wandern auf den Müll.

Kühler sind ja möglicherweise auch produziert, mit evl. 4080-Aufdrucken oder als Leuchtelemente. Müssen die auch noch endern. Möglicherweise der ganze Kühle in den Müll?

Wintermute

Fleet Admiral

- Registriert

- Feb. 2003

- Beiträge

- 14.729

Das liegt dran, dass der "Barren" aus einer Schmelze entsteht und dort unter Rotation wächst. Die einzelnen Wafer werden wie Wurstscheiben abgeschnitten.Banger schrieb:Dumme Frage: Ist es nicht möglich, da eckige Wafer zu machen

Ähnliche Themen

- Antworten

- 783

- Aufrufe

- 103.134

- Antworten

- 319

- Aufrufe

- 37.529