Hardware_Hoshi

Lt. Commander

- Registriert

- Jan. 2008

- Beiträge

- 1.486

Rock Lee schrieb:Und die PS5 ist jetzt eine Spielekonsole, oder ein Mini-Computer fürs professionelle Segment?

Kann sich doch nur positiv auswirken?

Ich werde das weiter unten beantworten.

Prinzipielel ist "Spiele... nicht gleich Spiele"

Darüber hinaus frage ich mich, was ein "Mini-Computer fürs professionelle Segment" ist. Kannst du mir das genauer erklären?

Rock Lee schrieb:Jetzt kann natürlich das Argument kommen, warum Nvidia trotzdem beim PC-Gaming besser performt, obwohl in der PS4 und Xbox One ein AMD-Chip werkelt.

Hier ging es in erster Linie wohl nur um Semi-Custom und deren Kostenvorteile. Die Architektur dahinder war wohl nebensächlich solang der Preis stimmt.

Kosten sind aber genau das Stichwort.

Wenn eine Plattform nur für Kosten getrimmt ist, wird da wohl kaum das non-plus-Ultra an Leistung dabei herauskommen.

Die Ergebnisse sind von vorher herein ein Kompromiss. Beim PC-Gaming hast du die diese Beschränkungen nicht, weil die Käufer bereit sind für Leistung auch mehr Geld zu investieren.

Rock Lee schrieb:Kommt drauf an in welchem Zeitraum. In den nächsten 1,5 Jahren mindestens 2.

Eine gute Frage!

Ich weiß es eherlich gesagt nicht. AMD hat im Laufe der Zeit die Produktpalette verkleinert. Es gab immer weniger Chips pro Generation. AMD hat vieles Recycled und z.B. als Rebranding erneut gebracht.

Sie haben finanziell eine ziemliche Durststrecke hinter sich. Das hat sich ebenfalls auf die Entwicklung ausgewirkt. Da die Variannten pro Chip weiter in Gaming- und Profisegment unterteilt sind, befürchte ich, AMD bevorzugt die Profiseite. Einfach weil dort mehr Geld zu erwirtschaften ist. Im schlimmsten Fall hat man halbgare Hybriden, die nicht wirklich für die Gamingseite gemacht sind, sondern hauptsächlich die Profis bedienensollen.

Heißt kurz gesagt also, nicht jede Variante ist automatisch gut.

Rock Lee schrieb:Vega hat zwar nichts verschlimmert, aber wenn der generelle Architekturaufbau gleich bleibt, kann auch nicht wirklich was verbessert werden. Volle Zustimmung!

Du musst das anders sehen.

Es fängt damit an, wenn eine Architektur wie Fiji mit Schwächen und kleinere Unzulänglichkeiten zu kämpfen hat. Vergrößert man diese Architektur weiter und pumpt sie in z.B. Takt und Chipgröße weiter auf, verschlimmern sich logischerweise auch die Probleme.

Bei Vega ist das passiert und es kamen sogar neue Probleme wie überproportionaler Stromverbrauch und Abwärme hinzu.

Rock Lee schrieb:Quelle? Und warum ist Konsole = schlecht?

Schlecht ist vielleicht nicht der richtige Ausdruck. Konsolen sind lediglich nicht für das Maximum oder das Beste gemacht. Du hast z.B. kleinere Texturen, oft keine Filtertechniken wie AF und MSAA / SMAA schon garnicht. Der Speicher ist prinzipiell kleiner .. usw....

Wenn du das alles auf dem PC nicht hättest, wäre das eine Katastrophe.

Rock Lee schrieb:So wie es aussieht wird man das wohl auch. Vega und dessen Nachfolger wird weiter in Richtung Profi-Segment fixiert und spätestens der Navi-Nachfolger wird wohl die professionellen Eigenschaften zugunsten von Gaming-Performance verlieren.

Ich wage diesbezüglich keine Prognose, da selbst Navi zurzeit noch Zukunftsmusik ist. Es wäre jedoch logisch, wenn AMD sich mehr auf die professionellen Eigenschaften konzentriert. Vega war da ein Hinweis. Jetzt mit Vega 20 konzentriert sich AMD auf Felder wie Machine Learning. Solche Felder nutzen dem Gaming quasi nichts. Zumindest soweit wir heut wissen.

AMD wird sich darauf konzentrieren müssen um nicht vollständig den Anschluss zu verlieren. Nvidia gibt hier die Marschrichtung mit unerhörten Wachstumsraten vor.

Rock Lee schrieb:Warum ist es kompletter Unsinn zu erwarten, dass es H1 2019 einen ~200mm² Chips fürs Consumer-Segment geben wird, wenn jetzt schon ein ~300mm² Vega 20 fürs Profi-Segment in 7nm gezeigt wurde?

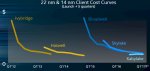

7nm ist nach momentanem Stand nicht ausgereift und jeder will ihn haben. Die kleineren Geräte wie IoT und Smartphones melden bereits Bedarf an, wie es letztens hieß. Neben den technischen Aspekten spielen auch die Kosten, die Yields und Verfügbarkeit ganz sicher eine entscheidende Rolle. AMD ist nicht alleine auf dem Markt.

Vega 20 wird wohl auch nicht in großer Menge produziert werden. Man sollte eher damit rechnen, diese Chips kämem wie einst Fiji stark limitert.

Alle anderen technischen Möglichkeiten von 7nm zu besprechen, wären leider nur pure Theorie.

Rock Lee schrieb:Quelle? Unter einer Mischarchitektur gegenüber zwei spezialisierten Architekturen leiden meiner Meinung nahc beide Marktsegmente. Daher gilt es auch sich auf beide Segmente gleichermaßen zu konzentrieren.

Du kannst meine Kommentare gerne nachlesen. Ich sprach speziell vom P100 und V100 - zwei Nvidia Tesla, die wahrliche Spezialisten sind. Eine solche Speziallösung wid die Mischarchitektur in der Regel immer schlagen. Es gibt darin keine Kompromisse, sondern den Drang zur puren Aufgabenerfüllung dieses Segments.

Nvidia hat das frühzeitig erkannt und Gaming sowie Profi getrennt. AMD leidet jetzt darunter, weil dieser Wechsel für den Konzern finanziell nicht machtbar ist. Zusätzlich rennt AMD die Zeit davon. Je länger man wartet oder neu entwickeln muss, desto mehr Abstand gewinnt Nvidia. Das ist eine regelrechte "Alles oder Nichts"-Situation. Das ist wie beim Glücksspiel, man kann sehr leicht alles verlieren.

Ein Fehlgriff und man verliert im Schlimmsten Fall Jahre in der Entwicklung bis ein Nachfolger kommt.

Rock Lee schrieb:2022 sind 4 Jahre. Da hast du schon 5nm bei TSMC.

Nvidia kann auch nicht zaubern und ist abhängig von den Fertigungstechnologien ihrer Zulieferer.

Ihr versteift euch alle zu sehr auf die Fertigungstechnologie. Zwar hat diese zugegebnermaßen einen großen Einfluss, doch mittlerweile wird die darunter liegende Architektur immer wichtiger.

Diverse Kerntechnologien sind natürlich wichtig. Ich kann dir allerdings das genaue Gegenteil aufzeigen. Sieh dir an, wie wenig AMD "die Wundertechnik HBM" gebracht hat. Wurde überall über alle Maße hochgelebt. Trotzdem gelang es Nvidia mit technischer Finesse die wesentlich unterlegenen GDDR5 und GDDR5X gleichwertig oder sogar besser hinzubekommen.

Spätesten hier sollte man hellhörig werden. Da die Entwicklungszeiten für GPUs im Durchschnitt irgendwo zwischen 4-5 Jahren liegen, kommt der Nachfolger von Navi wohl irgendwann 2020-2022. Navi ist wohl oder übel in den letzten Entwicklungsphase. Das Konzept kann man derart spät nicht mehr ändern. Würde es nicht passen, hätte sich AMD in den Sand gesetzt wie bei ... sagen wir Bulldozer.

Rock Lee schrieb:Das gab es jetzt genau einmal. Eine Schwalbe macht noch keinen Sommer

Natürlich!

Sie zeigen trotzdem was technisch möglich ist, wenn man genug Zeit, Geld und Personalaufwand investiert. Die richtige Kombination aus Technik und Konzept kann Wunder bewirken. Dafür muss man halt auch entsprechend investieren, um sämtliche Möglichkeiten auszuschöpfen.

Rock Lee schrieb:Jetzt vergleichst du Business-only mit einer Gaming-Architektur mit Business-Anhang

Nein, ich meinte folgendes:

-Volta hatte viele Verbesserungen und Tricks auf Lager. Was bisher nicht wirklich bekannt ist, dass Volta ein Async Compute Monster ist.

Nvidia hat in diesen Businessmodellen die Lösung für die Async Computeschwäche unter DX12 & co. gefunden. Nennt sich "Independent Scheduling"

Das heißt Nvdia muss die Tasks/Threads nicht mehr in 32er Stacks stapeln, sondern jeder Shader (CUDA-Core) kann sich die Aufgaben beliebig selbst zuordnen. Das ist besser als die Async Compute Lösung von AMD, weil diese auf ihrem GPU-Chip überall die ASync Compute Shader einbauen müssen, also extra Hardwareeinheiten. Nvidia spart sich diese Chipfläche, regelt alles per Software und ist wahrscheinilch troztdem schneller.

Du kannst Gift darauf nehmen, dass diese Technik in ähnlicher Weise auch für die Gamingarchitekturen kommen wird. Das wäre ein Beispiel wie die Businesssegmente die Gamingseite beinflussen können.

Nimm noch ein paar andere solche Entwicklungen wie z.B. GDDR6 hinzu und das Ergebnis kann sich bestimmt sehen lassen. In Summe können viele solcher kleineren Techniken sogar einen Vorsprung in Fertigungsgröße ausgleichen. Anstelle von Bruteforce kontert man mit intelligenten Lösungen.

Zuletzt bearbeitet: