-

Mitspieler gesucht? Du willst dich locker mit der Community austauschen? Schau gerne auf unserem ComputerBase Discord vorbei!

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Bericht Quo vadis, Cyberpunk 2077?: Die SMT-Problematik mit und ohne „Hack“ im Community-Test

Eigentlich ist die Sache doch ganz einfach:

Wenn ein Kern ohne SMT läuft, wird der eine virtuelle Kern immer effizienter und schneller laufen. SMT kann zwar die Gesamtleistung der CPU steigern, wenn jeder Thread den Kern voll auslastet. Jeder Thread für sich gesehen, läuft mit SMT aber immer schlechter als ohne SMT.

Das ist nichts neues und lange bekannt.

Bei Programmen, bei denen die Performance einzelner Threads wichtiger ist als die Gesamtleistung aller Threads zusammen, kann SMT deswegen ein Problem darstellen. Und das gilt für die allermeisten Spiele.

Dazu kommen noch Effekte wie Cache-Lines, Chiplets und E/P-Cores die das ganze nochmal komplexer machen.

Im Prinzip muss ein Spiel genau für jeden Prozessor einzeln optimiert werden, in dem man jeden Typ von Thread auf eine bestimmte Konstellation festtackert. Also z.B. die kritischen Threads auf einzelne Kerne, die sonst frei von anderen Threads bleiben müssen. Threads, die nur teilauslasten und nicht kritisch laufen aber z.B. durchaus frei per SMT verteilen usw.

Das ist aber erstens kaum machbar und zweitens wiederspricht das der offenen PC Architektur. Selbst wenn man es heute auf die verbeitesten CPUs optimiert, kann es einem morgen bei einer neuen CPU Architektur um die Ohren fliegen.

Also: Da ist kein böser Wille oder Unfähigkeit dahinter, es ist einfach ein technisches Problem. Ich kann Spielern nur empfehlen, auf SMT zu verzichten. Speziell wenn man über 6 oder mehr echte Kerne verfügt. Das kann auch Nachteile haben, aber meistens bringt es ein deutlich besseres Spielgefühl. Selbiges gilt übrigens auch für E-Cores.

Wenn ein Kern ohne SMT läuft, wird der eine virtuelle Kern immer effizienter und schneller laufen. SMT kann zwar die Gesamtleistung der CPU steigern, wenn jeder Thread den Kern voll auslastet. Jeder Thread für sich gesehen, läuft mit SMT aber immer schlechter als ohne SMT.

Das ist nichts neues und lange bekannt.

Bei Programmen, bei denen die Performance einzelner Threads wichtiger ist als die Gesamtleistung aller Threads zusammen, kann SMT deswegen ein Problem darstellen. Und das gilt für die allermeisten Spiele.

Dazu kommen noch Effekte wie Cache-Lines, Chiplets und E/P-Cores die das ganze nochmal komplexer machen.

Im Prinzip muss ein Spiel genau für jeden Prozessor einzeln optimiert werden, in dem man jeden Typ von Thread auf eine bestimmte Konstellation festtackert. Also z.B. die kritischen Threads auf einzelne Kerne, die sonst frei von anderen Threads bleiben müssen. Threads, die nur teilauslasten und nicht kritisch laufen aber z.B. durchaus frei per SMT verteilen usw.

Das ist aber erstens kaum machbar und zweitens wiederspricht das der offenen PC Architektur. Selbst wenn man es heute auf die verbeitesten CPUs optimiert, kann es einem morgen bei einer neuen CPU Architektur um die Ohren fliegen.

Also: Da ist kein böser Wille oder Unfähigkeit dahinter, es ist einfach ein technisches Problem. Ich kann Spielern nur empfehlen, auf SMT zu verzichten. Speziell wenn man über 6 oder mehr echte Kerne verfügt. Das kann auch Nachteile haben, aber meistens bringt es ein deutlich besseres Spielgefühl. Selbiges gilt übrigens auch für E-Cores.

- Registriert

- Juli 2021

- Beiträge

- 3.798

System: 5800X3D, RX 7900 XTX

Szene 1, 720p, Ultra, ZUWACHS (Prozent) FPS, Durchschnitt: 9

Szene 1, 720p, Ultra, ZUWACHS (Prozent) FPS, 1 %-Perzentil: 18

Szene 1, 720p, Ultra, ZUWACHS (Prozent) FPS, 0,2 %-Perzentil: 15

@Jan ich liefere mal für die 7900XTX und den 5800X3D die Werte. 3 Durchläufe, gemittelt.

Szene 1, 720p, Ultra, ZUWACHS (Prozent) FPS, Durchschnitt: 9

Szene 1, 720p, Ultra, ZUWACHS (Prozent) FPS, 1 %-Perzentil: 18

Szene 1, 720p, Ultra, ZUWACHS (Prozent) FPS, 0,2 %-Perzentil: 15

@Jan ich liefere mal für die 7900XTX und den 5800X3D die Werte. 3 Durchläufe, gemittelt.

- Registriert

- Mai 2011

- Beiträge

- 22.755

Wenn es aber mit dem Fix bei einem 8 Kerner alle 8 Kerne samt SMT threads benutzt und ohne nur 6 und deutlich schlechter läuft und CDPR mehrmals drauf hingewiesen wurde und immer noch sagt, die Performance der 8 Kerner sei „as expected“…..Grestorn schrieb:Also: Da ist kein böser Wille oder Unfähigkeit dahinter, es ist einfach ein technisches Problem. Ich kann Spielern nur empfehlen, auf SMT zu verzichten.

Dann ist es entweder böser Wille oder Unfähigkeit

Ergänzung ()

Ich hab mit meinen bisherigen 8 Kernern in den meisten Spielen die Erfahrung gemacht, dass 8C8T in erster Linie schlechtere lows hatten als 8C16TGrestorn schrieb:Das kann auch Nachteile haben, aber meistens bringt es ein deutlich besseres Spielgefühl.

Das könnte sein. Auf der anderen Seite scheinen sie ja aktuell nicht die verschiedenen Ryzen-Generationen zu unterscheiden. Und der aktuelle Hack gilt ja dann für alle 8-Kerner aus allen Generationen.Taxxor schrieb:Dann ist es entweder böser Wille oder Unfähigkeit

Und wir haben doch schon gesehen, dass gerade die ganz alten Ryzens nicht unbedingt unbedingt davon profitieren.

Sie können also vermutlich nicht einfach den "Hack" hier einbauen. Weil Ryzen 1 und 2 doch vermutlich so schon viel knapper sind als 5000er und 7000er. Sie müssten also eine weitere Unterscheidung einbauen. Und wenn man es nur anschalten wollte, für die Konfigs wo hier gezeigt wurde, dass es gewinnbringend ist, dann müsste man vermutlich explizit diese Konfigs erkennen, so dass man nicht ausversehen andere Konfigs dabei schlechter macht. Also noch viel mehr Unterscheidungen einbauen.

Und das ist dann nunmal nicht mehr gaanz so trivial. Kann immer noch faul sein von den Entwicklern, aber einfach die Ausnahme ausbauen, wird das Problem vermutlich nur verschieben, nicht beheben.

Wenn das Spiel auf 8 Kernen läuft und es Hintergrundanwendungen gibt, können sie im 2. Fall auf die virtuellen Kerne mit HW Support gepackt werden. Im anderen Fall müssen sie auf die gleichen Kerne wie das Spiel und es muss in SW hin und her gewechselt werden.Taxxor schrieb:8C8T in erster Linie schlechtere lows hatten als 8C16T

Wenn das Spiel nur 6 von 8 Kernen nutzen würde, wäre SMT vollständig aus vermutlich wieder im Vorteil. Wobei ich für AMD nicht weiß, in wie fern sie statisch geteilte Ressourcen überhaupt ohne SMT dann dem einen Kern zu schlagen. Nur wenn das überhaupt passiert, wäre SMT im BIOS aus ein Vorteil gegenüber die virtuellen Kerne einfach auszusparen bei der Verteilung der Threads, wie ein OS das ja auch schon macht, solange genügend Kerne da sind.

CrAzYLuKe

Lt. Junior Grade

- Registriert

- Nov. 2007

- Beiträge

- 482

System: 3900x, 3070ti (UV)

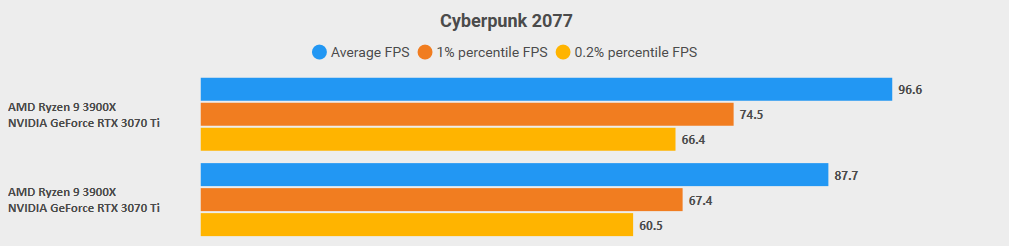

Szene 1, 720p, Ultra, ZUWACHS (Prozent) FPS, Durchschnitt: 10,1

Szene 1, 720p, Ultra, ZUWACHS (Prozent) FPS, 1 %-Perzentil: 10,5

Szene 1, 720p, Ultra, ZUWACHS (Prozent) FPS, 0,2 %-Perzentil: 9,8

Nicht schlecht.

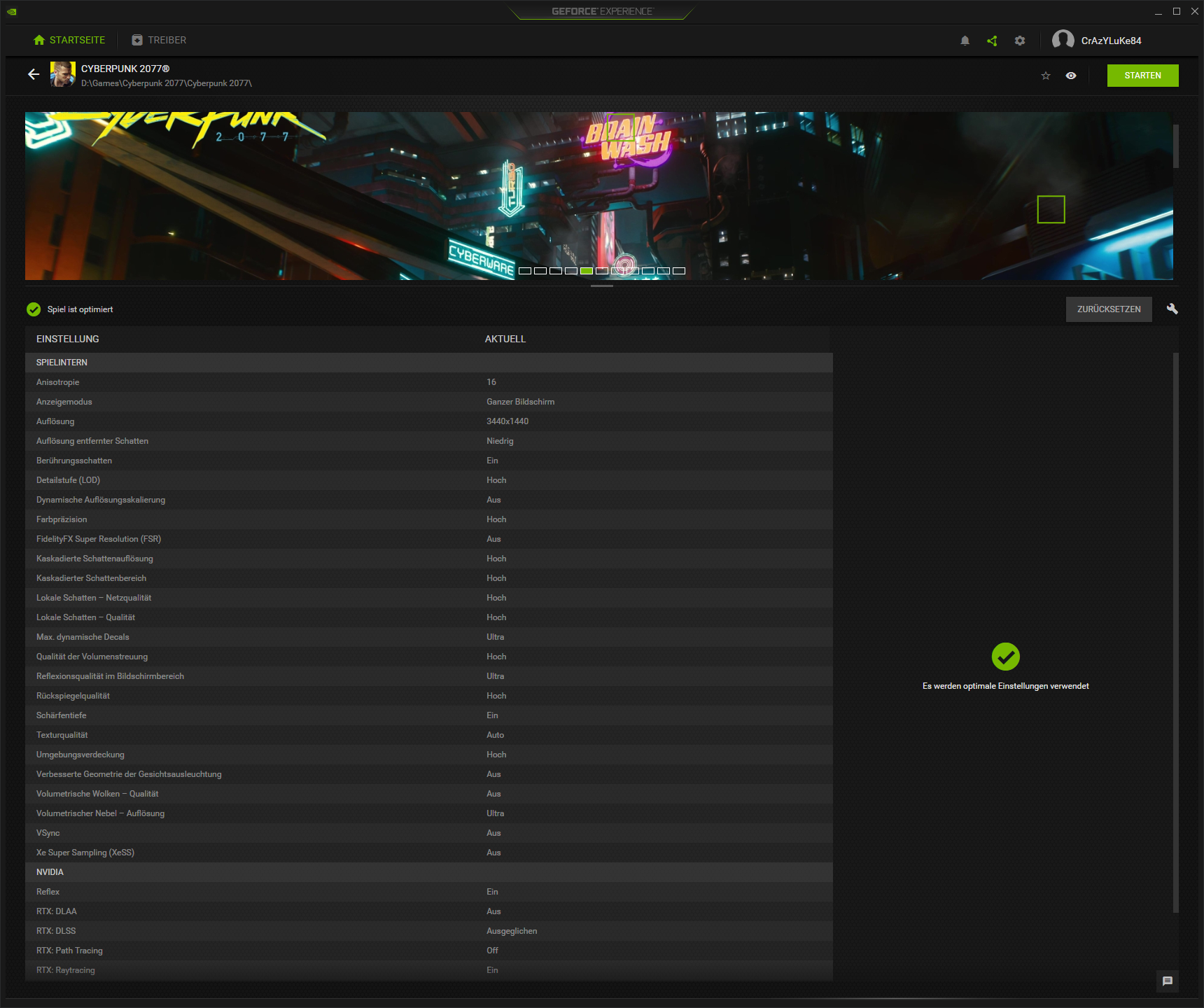

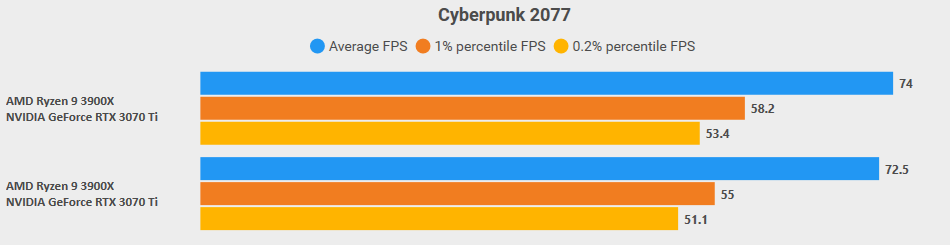

Zum Spaß mache ich das auch nochmal mit meinen Setting in 3440x1400 um ein Real-Life-Szenario zu haben:

System: 3900x, 3070ti (UV)

Szene 1, 3440x1440, GeForce Experience Presets (seieh Screenshot weiter unten), ZUWACHS (Prozent) FPS, Durchschnitt: 2,1

Szene 1, 3440x1440, GeForce Experience Presets (seieh Screenshot weiter unten), ZUWACHS (Prozent) FPS, 1 %-Perzentil: 5,8

Szene 1, 3440x1440, GeForce Experience Presets (seieh Screenshot weiter unten), ZUWACHS (Prozent) FPS, 0,2 %-Perzentil: 4,5

Szene 1, 720p, Ultra, ZUWACHS (Prozent) FPS, Durchschnitt: 10,1

Szene 1, 720p, Ultra, ZUWACHS (Prozent) FPS, 1 %-Perzentil: 10,5

Szene 1, 720p, Ultra, ZUWACHS (Prozent) FPS, 0,2 %-Perzentil: 9,8

Nicht schlecht.

Zum Spaß mache ich das auch nochmal mit meinen Setting in 3440x1400 um ein Real-Life-Szenario zu haben:

System: 3900x, 3070ti (UV)

Szene 1, 3440x1440, GeForce Experience Presets (seieh Screenshot weiter unten), ZUWACHS (Prozent) FPS, Durchschnitt: 2,1

Szene 1, 3440x1440, GeForce Experience Presets (seieh Screenshot weiter unten), ZUWACHS (Prozent) FPS, 1 %-Perzentil: 5,8

Szene 1, 3440x1440, GeForce Experience Presets (seieh Screenshot weiter unten), ZUWACHS (Prozent) FPS, 0,2 %-Perzentil: 4,5

Millennial_24K

Lt. Commander

- Registriert

- Dez. 2021

- Beiträge

- 1.636

Für mich ist die fehlende oder fehlerhafte SMT-Unterstützung von Ryzen 8C+ CPUs in CP2077 nach so langer Zeit ein eindeutiger Beweis dafür, dass man bei CD Project Red absichtlich wenig für eine vernünftige Hardwareoptimierung auf Seiten AMD macht bzw. jemals im Sinn hatte. RDNA 3 performt zwar recht gut, aber das ist reiner Zufall. Zum Releasezeitpunkt war RDNA 2 ganz neu, und wie schlecht RX 6000 im Vergleich zu RTX 3000 in CP2077 performt, auch bei reinem Rasterizing, war mir schon damals nicht geheuer... Dann kam noch der ewig nicht vorhandene FSR-Support dazu, welcher dann nach über 2 Jahren mit der Version 2.1 nicht einmal gut ins Spiel implementiert worden ist.

Auf jeden Fall ist eine Schande, wenn man die große Verbreitung von Ryzen-CPUs in Gaming-PCs (und den Konsolen!) sieht. Außerdem frage ich mich immer ob es nur Zufall ist, dass Cyberpunk 2077 ausgerechnet DER Nvidia Vorzeigetitel ist.

Man könnte meinen: kein Wunder also, dass sich AMD bei Bethesda eingekauft hat. Wenn Starfield eine gute FSR-2-Implementierung bietet, wäre das natürlich ein gute Werbung für diese Upscaling-Technologie.

Auf jeden Fall ist eine Schande, wenn man die große Verbreitung von Ryzen-CPUs in Gaming-PCs (und den Konsolen!) sieht. Außerdem frage ich mich immer ob es nur Zufall ist, dass Cyberpunk 2077 ausgerechnet DER Nvidia Vorzeigetitel ist.

Man könnte meinen: kein Wunder also, dass sich AMD bei Bethesda eingekauft hat. Wenn Starfield eine gute FSR-2-Implementierung bietet, wäre das natürlich ein gute Werbung für diese Upscaling-Technologie.

Zuletzt bearbeitet:

CrAzYLuKe

Lt. Junior Grade

- Registriert

- Nov. 2007

- Beiträge

- 482

Eno77 schrieb:wie sieht der Zuwachs bei 1440p oder 2160p aus?

Dafür habe ich leider keine Zeit. Da musst du wohl selber ran.

- Registriert

- Mai 2011

- Beiträge

- 22.755

Du vergisst hier wohl, dass der aktuell im Spiel enthaltene Fix in Zusammenarbeit mit AMD entstanden istTigerherzLXXXVI schrieb:Für mich ist die fehlende oder fehlerhafte SMT-Unterstützung von Ryzen 8C+ CPUs in CP2077 nach so langer Zeit ein eindeutiger Beweis dafür, dass man bei CD Project Red absichtlich wenig für eine vernünftige Hardwareoptimierung auf Seiten AMD macht

8-core, 12-core and 16-core processors remain unchanged and behaving as intended. This change was implemented in cooperation with AMD and based on tests on both sides

Eine 3080 war in 1440p Raster, 8% schneller als eine 6800XT, der Schnitt vom CB Performancerating war 6%.TigerherzLXXXVI schrieb:Zum Releasezeitpunkt war RDNA 2 ganz neu, und wie schlecht RX 6000 im Vergleich zu RTX 3000 in CP2077 performt, auch bei reinem Rasterizing, war mir schon damals nicht geheuer..

Mit Patch 1.5 waren die beiden dann sogar exakt gleichauf in 1440p.

FSR1 kam 8 Monate nach dessen Release ins Spiel(Cyberpunk kam schon raus bevor es FSR gab), bei FSR2 hat es 5 Monate gedauert.TigerherzLXXXVI schrieb:Dann kam noch der ewig nicht vorhandene FSR-Support dazu, welcher dann nach über 2 Jahren mit der Version 2.1 nicht einmal gut ins Spiel implementiert worden ist.

Cyberpunk Release: 12/20 (FidelityFX CAS zum Start vorhanden)

FSR1 Release auf Github: 06/21

Hinzugefügt in 02/22(Patch 1.5)

FSR2 Release auf Github: 06/22

Hinzugefügt in 11/22 (Patch 1.61)

Eine gute Werbung wäre es dann, wenn man den direkten Vergleich mit anderen Upscalern ziehen könnte und hier als Sieger hervorgeht.TigerherzLXXXVI schrieb:Man könnte meinen: kein Wunder also, dass sich AMD bei Bethesda eingekauft hat. Wenn Starfield eine gute FSR-2-Implementierung bietet, wäre das natürlich ein gute Werbung für diese Upscaling-Technologie.

FSR2 in Cyberpunk wurde mMn auch besser implementiert, als z.B. in Jedi Survivor, wo es nur FSR gibt^^

Zuletzt bearbeitet:

Manegarm

Vice Admiral

- Registriert

- Juni 2015

- Beiträge

- 6.921

Hää??Caramelito schrieb:Eher nicht - Das Game war immer top. Einige Bugs und vor allem Konsolen Technik war UNSPIELBAR. Deshalb wurde das Spiel weitestgehend "vernichtet".. Konsolen > PC und so

Was ist daran top? Ich erinnere dich lieber mal an das erste Gameplayvideo, was vor 4 Jahren rauskam. Das jetzige Spiel ist dagegen, was im Video zu sehen ist ein flacher bunter Gaugummi Activision oder Ubisoft-shooter. Es wurde so viel gestrichen, gelöscht, zum schlechteren geändert, darüber bin ich bis heute baff.

Das was im Video zu sehen ist ist top. An diesem Spiel heute ist aber überhaupt nichts top.

Und das hat einfach nichts mit den Bugs zu tun. Auch wenn das Spiel immer noch verbuggt ist

Cyberpunk ist der heftigste Downgrad der Geschichte, da kommt bisher nichts ran.

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

Zuletzt bearbeitet:

Caramelito

Admiral

- Registriert

- Juni 2016

- Beiträge

- 9.111

Dafür sind die Wertungen, auch von Usern, aber sehr gut im Vergleich zu anderen AAA Games

Wenn ich dir jetzt erzähle, das mein laptop nur 1080p (mit einer 3070) und mein desktop 4k (mit einer 6900) hat und sage, das auf dem desktop die spiele einfach besser aussehen. Glaubst du mir das dann?Manegarm schrieb:Noch schärfere Aufösung bis 4k hat keinen Nutzen. Genauso wie noch bessere Grafik nichts mehr zu einem noch besseren Spiel beiträgt. Das ist wie mit Geld, viel mehr Geld zu haben macht einen nicht NOCH glücklicher.

Es ist schlicht kompletter Firlefanz. Klar, wer nur in 4k spielt hat sich dran gewöhnt, aber dann ist er selber schuld. Er kann sich auch wieder an 1080p oder wqhd gewöhnen, nach 2 Stunden würde ihn das nicht mehr stören.

Glaubst du mir auch, das ich die 1080p wissend so gekauft habe und es mich nicht wirklich stört, das unterwegs am laptop manches nicht so geil aussieht?

Und ja, ich mag es auf dem desktop spiele mit geiler grafik zu spielen. Factorio macht in 4k aber auch deutlich mehr spaß (weil mehr übersicht)

Tatsächlich vermeide ich es inzwischen aufm laptop factorio zu spielen, weil mir dann die übersicht fehlt :/

Millennial_24K

Lt. Commander

- Registriert

- Dez. 2021

- Beiträge

- 1.636

Das stimmt. Allerdings liegt die Verantwortung nicht bei AMD, dass die Spieleengine von CP2077 besser für Ryzen 8C+ CPUs angepasst wird, sondern bei CD Project Red. Sie müssen die notwendigen Anpassungen vornehmen, schließlich ist es ihre Engine. AMD kann in diesem Fall nur oberflächlich Hilfestellungen geben, jedoch nicht an der Wurzel des Problems anpacken.Taxxor schrieb:Du vergisst hier wohl, dass der aktuell im Spiel enthaltene Fix in Zusammenarbeit mit AMD entstanden ist

Wenn das die Werte sind, dann hätte ich übertrieben. Ich schaue mir das noch einmal an.Taxxor schrieb:Eine 3080 war in 1440p Raster, 8% schneller als eine 6800XT, der Schnitt vom CB Performancerating war 6%.

OK. Da habe ich FSR 1.0 glatt verdrängt. Damit gehen die Zeiträume für die Implementierung wohl in Ordnung.Taxxor schrieb:FSR1 kam 8 Monate nach dessen Release ins Spiel(Cyberpunk kam schon raus bevor es FSR gab), bei FSR2 hat es 5 Monate gedauert.

FSR 2 hat den Vorteil, dass es für alle PC-Gamer nutzbar ist. Mal angenommen die Implementierung wird aufgrund der Zusammenarbeit zwischen Bethesda und AMD nahezu perfekt, dann wäre die Empörung über fehlendes DLSS Jammern auf hohem Niveau.Taxxor schrieb:Eine gute Werbung wäre es dann, wenn man den direkten Vergleich mit anderen Upscalern ziehen könnte und hier als Sieger hervorgeht.

Schon möglich. Aber so wie bereits das Ryzen-Problem für CP2077 auf ein fehlendes Engagement auf Seiten des Entwicklers schließen lässt, so wird CD Project Red sicherlich auch nicht den größten Aufwand für FSR 2 betrieben haben. Und genau das möchte AMD natürlich nicht haben.Taxxor schrieb:FSR2 in Cyberpunk wurde mMn auch besser implementiert, als z.B. in Jedi Survivor, wo es nur FSR gibt^^

FSR2 muss prinzipbedingt sehr sparsam mit Rechenleistung umgehen, weil es diese Rechenleistung von den Shader Cores abzieht. DLSS hingegen hat Hardwarebeschleunigung für diese Berechnungen, zusätzlich zu den Shader Cores. Sie haben also schlicht mehr Rechenleistung zu geringeren FPS-Kosten zur Verfügung.TigerherzLXXXVI schrieb:Mal angenommen die Implementierung wird aufgrund der Zusammenarbeit zwischen Bethesda und AMD nahezu perfekt,

Selbst wenn AMD FSR2 verbessern werden kann um zur aktuellen Qualität von DLSS aufzuschließen, könnte DLSS vermutlich ähnliche Verbesserungen auch machen und haben immer noch mehr Rechenleistung übrig.

Diesen Unterschied, das FSR2 möglichst sparsam designt wurde, sehen wir auch bei XeSS. Das wurde auch für spezielle HW-Einheiten designt, steht aber auch (sogar in einer runter gedummten Fassung) generisch zur Verfügung. Und wie wir in Tests gesehen haben, bringt XeSS auf AMD und Nvidia GPUs nicht viel, weil es eben wie DLSS deutlich mehr rechnet, was nur mit dem passenden HW-Beschleuniger auch wirklich schnell genug geht.

Klar, AMD kann das dynamisch anpassen, aber dann frist FSR evtl. den Vorteil der niedrigeren Renderauflösung wieder auf...

Der größte Vorteil von AMDs Ansatz ist einfach, dass sie mehr Chipfläche für Shader Cores übrig haben und deshalb im Rastern auch vorne liegen. Schlechtere Performanz in den spezifischen Anwendungsgebieten (wie RayTracing und Upscaling), dafür mehr generische Performance. Aber Wunder kann man damit nicht vollbringen, alles ein Tradeoff.

DLSS wurde auch schon durch fleißige Bienchen auf älteren Grafikkarten aktiviert. Ich glaube da ist einfach viel Hokuspokus um die Software. Das meiste läuft anscheinend über die CPU und die normalen Recheneinheiten. Und über die treiberseitigen Ausschluss anderer Generationen.

nVidia hatte einfach viel mehr Zeit dafür ihre Technik zu verfeinern. Ich glaube als das angekündigt wurde, gab es bei AMD noch keinen, der sich überhaupt damit beschäftigt hatte. Die wurden komplett überrumpelt.

nV hat also einen riesigen zeitlichen Vorsprung. Dazu kommt, dass sie nur für 2 Generationen optimieren müssen. Im Gegensatz zum allübergreifenden Ansatz von FSR. Aber ist auch arg OT hier, merke ich gerade.

Gibt genug Threads in denen das Thema besprochen wird.

nVidia hatte einfach viel mehr Zeit dafür ihre Technik zu verfeinern. Ich glaube als das angekündigt wurde, gab es bei AMD noch keinen, der sich überhaupt damit beschäftigt hatte. Die wurden komplett überrumpelt.

nV hat also einen riesigen zeitlichen Vorsprung. Dazu kommt, dass sie nur für 2 Generationen optimieren müssen. Im Gegensatz zum allübergreifenden Ansatz von FSR. Aber ist auch arg OT hier, merke ich gerade.

Gibt genug Threads in denen das Thema besprochen wird.

Ja? So auf die Schnelle finde ich da nichts. Hast du mal einen Link dazu?Kommando schrieb:auf älteren Grafikkarten aktiviert. Ich glaube da ist einfach viel Hokuspokus um die Software.

Grundsätzlich glaube ich gerne, dass nicht 100% von DLSS Berechnungen auf den Inferenz-Beschleunigern laufen. Und alles ist einfach nur Mathe. Wenn du die Formeln hast, kannst du das auf jeder Art von Recheneinheit / Prozessor berechnen. Die Frage ist nur wie schnell...

RTX lief auch auf GPUs ohne RT Recheneinheiten - brutal langsam.Kommando schrieb:DLSS wurde auch schon durch fleißige Bienchen auf älteren Grafikkarten aktiviert.

Hast Du eine Quelle wo jemand DLSS (und nicht einfach nur eine Brücke zu FSR2) auf einer nicht RTX Karte zum Laufen gebracht hat, mit Qualitäts und Performance-Vergleichen?

Sonst ist das nur eine dieser raunenden Behauptungen, die man immer wieder bekommt "Ich hab gehört, NVidia nutzt die Tensor Cores gar nicht... alles nur Lug und Trug..."

(Klar, man verschwendet massiv Transistoren für Lug und Trug... Wer's glaubt)

Ich könnte jetzt auch nur die Quellen wieder raussuchen, die damals zur Einführung von DLSS gezeigt wurden. Irgendwer hatte das bei einem Spiel aktiviert. Habe den Stand nicht weiter verfolgt.

Wenn Ihr da weiter seid und nichts aktuelles findet, bzw. sagt, dass es nur inzwischen wiederlegte Behauptungen waren, dann glaube ich euch da eher.

Ist hier aber eh OT.

Wenn Ihr da weiter seid und nichts aktuelles findet, bzw. sagt, dass es nur inzwischen wiederlegte Behauptungen waren, dann glaube ich euch da eher.

Ist hier aber eh OT.