Krautmaster schrieb:

Edit. Das was nicht stimmt mag sein, aber so ist nunmal der Umstand. Ich glaube jetzt weniger dass das an CB liegt als an Wolfenstein, Vulkan, AMD oder Nvidia

CB ist wahrscheinlich nicht schuld am "worst case" - aber der umgang damit ist mehr als fragwürdig.

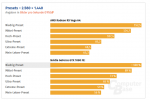

man sollte sich anstelle von CB gedanken machen, wo die FPS einbrüche herkommen, die komplett alle amd karten betreffen und KEINE nvidia karte, und nicht die zahlen als benchmarkwerte übernehmen oder gar für das preset scaling verwursten. das geht überhaupt nicht und ist mal wieder ein neuer tiefpunkt.

im artikel liest sich das so, als ob amd in der szene schlecht/fehlerhaft performt und nvidia gut - aber ich darf mal an AotS erinnern, als nvidia treiberseitig die eigenen gpus von etwas rechenlast befreit hat (aka nvidia karten rendern nicht alle effekte bzw. nicht so, wie sie sein sollten). ist die szene tatsächlich nicht "verbugt" und extrem anspruchsvoll, gibts immernoch die möglichkeit, dass amd hier die "baseline performance" zeigt und nvidia sich schlicht von rechenlast "befreit".

wobei verbugt hier ein weiter begriff ist - hier braucht nur jemand im dev team einmal nicht aufpassen und es stacken sich irgendwelche effekte/shader übereinander, bspw. 100 layer schattenwurf oder transparenzeffekte. irgendwelche meshes, die kollidieren oder zu oft gespawnt werden. cpu last im worst case geprüft - natürlich nicht.....? kann auch ein physik-effekt sein, der nicht richtig berechnet wird.

ich will damit nicht sagen, dass es nicht auch ein problem seitens amd sein kann, aber dafür, dass man nichtmals ein video oder wenigstens einen screenshotvergleich bekommt, ist mir die conclusio "amd bricht ein, nvidia hält performance in worstcase" zu weit hergeholt.

CB ist auch davon ausgegangen, dass async compute auf amd karten ab release aktiviert ist, tatsächlich hatten nvidia karten den support zuerst. ein bisschen komisch, oder? bei einem gemeinschaftsprojekt von bethesda und amd.