Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News GeForce RTX 3080 und 3070: Nvidia kontert Navi 21 vorerst nicht mit mehr Speicher

Cpt.Willard

Commander

- Registriert

- Juni 2005

- Beiträge

- 2.434

Das würde mich sehr verwundern, wenn Du da schon zu einer Trixx (Nitro+/Tocic) Infos hättest, als Annahme - okay, doch wie bei Navi1 würde es mich nicht irritieren, wenn wir mit einer solchen Performancekarte seitens Sapphire erst 3-4 Monate nach Release der anderen Karten rechnen könnten.Mcr-King schrieb:Noch was die Saphire Trixx wird ein richtiges Monster (hust) mit ca. 2,6 GHz Core Clock.

Freuen würd´s mich auf alle Fälle

Aber ich wäre schon zufrieden, wenn die Werte stimmen, plus ein kleiner Bonus durch finale Treiber... UND Qualität in der Bildwiedergabe... bloß nicht overhypen - doch den Werten vertraue ich schon.

Dann müsste man wohl in/mit DLSS spielen.ArrakisSand schrieb:Richtig die wird wegknicken wie Neymar wenn er dem Strafraum etwas zu nahe kommt.

Wenn es ein hypthetischer Preis von 20€ mehr (damals) wäre, würde TSMC halt dann 30€+ mehr verlangen - ist ja nicht so, dass das Pflegekräfte sind, die für Spotlöhne die notwendige Arbeit verrichten - die sind da schon schlauer nach einer AbsageShrimpy schrieb:Ich hoffe NV kanns jetzt erstmal vergessen bei TSMC

O

Oneplusfan

Gast

ArrakisSand schrieb:Ach ja, ich nehme gerade die Wetten entgegen bzgl. einer PS5 pro die in spätestens 3 Jahren mit voraussichtlich 24GB erscheinen wird.

Hier, ich. Also habe ich gewonnen wenn ab Release der PS5 die PS5 Pro 3 Jahre + 1 Tag später released wird? Sind die 24GB auch Teil der Wette?

Ich denke schon, dass Nvidia ab nächstes Jahr wieder auf TSMC switcht. Die Kapazität sollte durch den Huawei Wegfall doch eigentlich da sein. Zumal die wirklich großen Abnehmer alle schon in 5nm produzieren lassen.

ArrakisSand

Lieutenant

- Registriert

- Dez. 2019

- Beiträge

- 988

Eine performantere Deep Learning upscaling alternative von AMD scheint diesen Dez. möglicherweise auch erst im Jan. nächsten Jahres zu kommen. (Siehe Video)foo_1337 schrieb:Und @ArrakisSand Die FPS bei 4k/RT werden ohne DLSS beschissen genug sein, so dass jeder AMD User, der RT nutzen will, sich das wünscht. Wenn man kein RT will/braucht, sind die AMD Karten jedoch (voraussichtlich, echte Benchmarks abwarten) eine sehr gute Wahl. Deine VRAM Aussichten teile ich keineswegs. Jedenfalls nicht nicht die nächsten 3 Jahre.

RT wird es von AMD ebenfalls geben. (Möglicherweise leicht schlechter, doch oberhalb 2080ti level, aber wir werden sehen)

Bei der rasterization performance scheint die 6800XT in 4k

bei 5 von 10 Spielen im Vergleich zur 3080 in Führung zu liegen.

Bei 2 Spielen Gleichstand und bei dreien ein Rückstand zu haben.

Bei 1440p liegt sie in 8 von 10 Spielen vorne.

Und so nebenbei hat sie noch 16GB

Ich glaube wir werden uns schon deutlich früher als erst in 3 Jahren wieder über dieses Thema unterhalten.

Das lustige ist ja das die 3080 eigentlich ja ihre Stärken erst bei 4k so richtig ausspielen kann, wird allerdings aufgrund seiner nur 10GB schon bald kein Land mehr bei höheren Einstellungen sehen können und bei niedrigeren Auflösungen scheint eh kein Kraut gegen Navi gewachsen zu sein.

Hat die 3080 daher ein Auslastungsproblem?

YouTube

An dieser Stelle steht ein externer Inhalt von YouTube, der den Forumbeitrag ergänzt. Er kann mit einem Klick geladen und auch wieder ausgeblendet werden.

Ich bin damit einverstanden, dass YouTube-Embeds geladen werden. Dabei können personenbezogene Daten an YouTube übermittelt werden. Mehr dazu in der Datenschutzerklärung.

F

foo_1337

Gast

Danke, dass du mir das Video zeigst, dass ich bereits zusammengefasst habe (darauf hast du ja schon geantwortet). Meinst du das jetzt ernst?

https://www.computerbase.de/forum/t...p-pcbs-mit-big-navi-gpu.1976501/post-24784611

https://www.computerbase.de/forum/t...p-pcbs-mit-big-navi-gpu.1976501/post-24784611

ArrakisSand

Lieutenant

- Registriert

- Dez. 2019

- Beiträge

- 988

Wieso schreibst du dann "werden ohne DLSS beschissen genug sein..." wenn doch allem Anschein nach eine DLSS Alternative kommen wird.foo_1337 schrieb:Danke, dass du mir das Video zeigst, dass ich bereits zusammengefasst habe (darauf hast du ja schon geantwortet). Meinst du das jetzt ernst?

https://www.computerbase.de/forum/t...p-pcbs-mit-big-navi-gpu.1976501/post-24784611

Und sorry mein Namensgedächtnis ist leider nicht das beste.

F

foo_1337

Gast

Weil:

Aber ich lasse mich gerne Überraschen und wie gesagt würde ich es sehr befürworten, wenn AMD was Adäquates an Bord hat. Denn in den letzten Jahren war nvidia der Innovationstreiber (Ich meine jetzt nicht Performance). Wenn AMD jetzt wieder mehr Erfolg im oberen Segment hat, werden von da auch wieder Innovationen kommen. Und das ist gut für uns alle.foo_1337 schrieb:Es wäre gut, wenn AMD was im Gepäck hat. Aber bis die Studios das vernünftig adaptieren und die Technologie selbst ausgereift ist, sind wir schon bei der nächsten Generation oder später. Siehe DLSS.

Bairok

Lt. Junior Grade

- Registriert

- Juli 2015

- Beiträge

- 315

Mitesser schrieb:freu mich, dass in deiner Welt, wie für 50% in den letzten 20 Seiten, die 2080ti 11gb schneller läuft als die 3080 10gb, und die 1080ti 11gb schneller läuft als 2080 8gb und 5700xt 8gb.

In "deiner Welt" scheinst du die Zukunft zu vergessen. Die Leistungsentfaltung kommt erst in hohen Auflösungen und evtl. mit Raytracing zur Geltung. In künftigen Veröffentlichungen könnte das zu Zielkonflikten führen.

Übrigens schön, wenn man direkt subtil beleidigt wird. Danke dafür. Weitermachen.

F

foo_1337

Gast

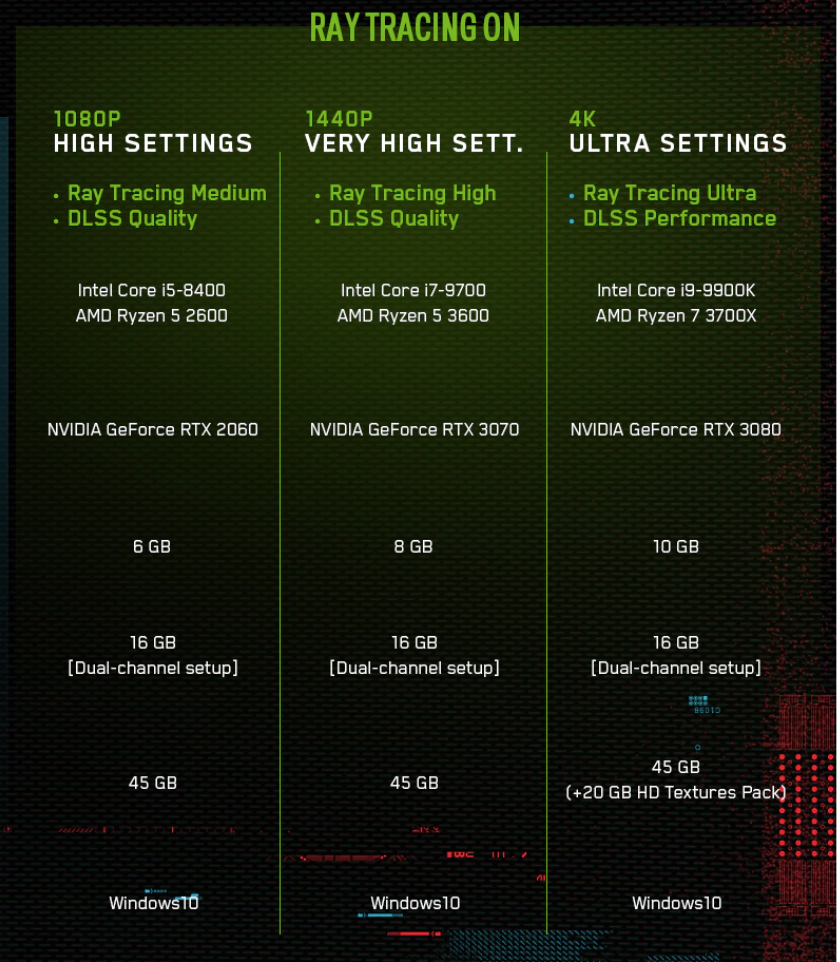

RT wird vermutlich mit dieser GPU Generation eh nicht oft in hohen Auflösungen gerendert werden, sondern auf DLSS & Alternativen angewiesen sein. Siehe z.B. die Requirements von Watchdogs Legion.

Für die nächsten 3 Jahre würde ich mir bei der 3070 (ist aus meiner Sicht keine 4k Karte) und 3080 keine Gedanken machen. Und auch die 6/8/10GB auf den Screenshot werden wohl nicht benötigt werden, denn vor der Vorstellung von Ampere standen da noch 11GB bei 4k

Für die nächsten 3 Jahre würde ich mir bei der 3070 (ist aus meiner Sicht keine 4k Karte) und 3080 keine Gedanken machen. Und auch die 6/8/10GB auf den Screenshot werden wohl nicht benötigt werden, denn vor der Vorstellung von Ampere standen da noch 11GB bei 4k

Vendetta

Commander

- Registriert

- Okt. 2007

- Beiträge

- 2.139

Was ja nichts macht, denn DLSS im Performance Mode ist auf 4K ca. gleich gut wie natives 4K und schluckt einen Bruchteil der Leistung und ermöglicht Raytracing. Wenn man sich von den hirnrissigen Ultra Presets verabschiedet, kann man wohl sogar 60FPS im 4k Qualitymode mit Raytracing auf hohen Settings erzielen.foo_1337 schrieb:RT wird vermutlich mit dieser GPU Generation eh nicht oft in hohen Auflösungen gerendert werden, sondern auf DLSS & Alternativen angewiesen sein.

Es wird immer alles schwarz und weiß behandelt, dabei gibts bei den Settings bei so gut wie jedem Spiel viele Möglichkeiten viel Performance mit wenig Qualitätsverlust zu erzielen.

ArrakisSand

Lieutenant

- Registriert

- Dez. 2019

- Beiträge

- 988

Sorry aber was du hier verbreitest könnten ebenso gut aus einer Marketing Folie von NVIDIA entstammen.foo_1337 schrieb:RT wird vermutlich mit dieser GPU Generation eh nicht oft in hohen Auflösungen gerendert werden, sondern auf DLSS & Alternativen angewiesen sein. Siehe z.B. die Requirements von Watchdogs Legion.

Für die nächsten 3 Jahre würde ich mir bei der 3070 (ist aus meiner Sicht keine 4k Karte) und 3080 keine Gedanken machen. Und auch die 6/8/10GB auf den Screenshot werden wohl nicht benötigt werden, denn vor der Vorstellung von Ampere standen da noch 11GB bei 4k

Anhang anzeigen 983275

Aber halt ist das nicht eben eine solche?

Ahh jetzt kapier ich es du meinst das ironisch.

Vor Ampere standen dort 11GB bei 4k und wenn die 3080 nur 6GB hätte würde da eben 6GB stehen und bei den anderen Karten halt 3 und 4GB. NVIDIA macht sich die Welt wie es ihr gefällt und wird wohl auch den Qualitätsregler entsprechend leicht feinjustieren (natürlich so das es nicht gleich so offensichtlich auffällt)

Was ist mit den 2000 an kommenden Spielen die kein DLSS unterstützten werden?

Werden es da die 20 die es unterstützen raushauen können?

Ist die Artefaktbildung, welche sich besondere bei Bewegungen bemerkbar macht mittlerweile komplett verschwunden?

Aber zum Glück scheint die 6800XT ja auch eine (anscheinend performantere) DL upscaling tech. zu beherschen und dank ihrer 16GB

sollte das auch bis mindestens Ende 2040 reichen.

Wie soll da dann erst eine NVIDIA like präs. Folie von AMD dafür aussehen?

In etwa so?

AMD Radeon 6800XT

8K Ultra Settings

Ray tracing high

DLXX Quality

Intel core 10900K

AMD Ryzen 7 5800X

16GB

32GB Dual Channel

45GB

+80GB Texture Pack)

- Deep learning revolution.

- Artificial neural networks.

- Deep neural networks.

- Automatic speech recognition.

- Electromyography (EMG) recognition.

- Image recognition.

- Visual art processing.

- Neural net training for Ampers DLSS 2.0 (trained on extremely high-quality 16K)

Daher lass dich nicht verarschen von herstellerspezifischen Präsentationsfolien, es gibt nichts besseres als reichlich Speicher und natives 4K.

Das ändern auch keine 2-3 Vorzeigespiele wo DLSS 2.0 anscheinend gut implementiert wurden etwas daran.

Zuletzt bearbeitet:

F

foo_1337

Gast

Nein, die Aussage war: Die Studios schreiben exakt die VRAM Menge in die Anforderungen, die die Grafikkarte ht, die sie nennen. Das ist jedoch oft nicht die benötigte Menge.ArrakisSand schrieb:Vor Ampere standen dort 11GB bei 4k und wenn die 3080 nur 6GB hätte würde da eben 6GB stehen und bei den anderen Karten halt 3 und 4GB. NVIDIA macht sich die Welt wie es ihr gefällt und wird wohl auch den Qualitätsregler entsprechend leicht feinjustieren (natürlich so das es nicht gleich so offensichtlich auffällt)

Auf den Rest von dir gehe ich dieses mal nicht ein. Wenn du mir Markedinggeblubber unterstellst, ist das deine Sache, mir egal.

Eine Sache noch zum VRAM. Der Text hier ist zwar von NV, aber er ist korrekt und nicht mit Marketingblabla gleichzusetzen:

There are a number of hardware monitoring tools and utilities that claim to report GPU Memory Usage. Note that these tools do not report actual GPU memory usage. Instead, they report memory allocation, the amount of memory requested by the application.

Source: https://videocardz.com/newz/nvidia-geforce-rtx-3070-reviewers-guide-leaked

Ein Beispiel dazu gibt es da auch (The Divison2)

Ich selbst habe bisher keine Berührungspunkte zu VRAM gehabt, aber genug mit malloc(), vm_page_t & co zu tun gehabt. Daher maße ich mir mal an, dies beurteilen zu können.

Zuletzt bearbeitet von einem Moderator:

Vendetta

Commander

- Registriert

- Okt. 2007

- Beiträge

- 2.139

Sieht auf jeden Fall danach aus bei Watchdogs und vielleicht reserviert das Game ja auch die vollen 10GB, vielleicht nutzt es aber trotz dem 20GB Texturpack nur 7-8GB? Wird man ja bald sehen, das Spiel erscheint ja lustigerweise einen Tag nach dem AMD Lauchevent...foo_1337 schrieb:die Aussage war: Die Studios schreiben exakt die VRAM Menge in die Anforderungen, die die Grafikkarte ht, die sie nennen. Das ist jedoch oft nicht die benötigte Menge.

FatalFury

Lt. Commander

- Registriert

- Juli 2017

- Beiträge

- 1.317

F

foo_1337

Gast

Dafür gibt es bereits einen eigenen Thread

F

foo_1337

Gast

Tja, @FatalFury sind wohl eher gute Nachrichten für die 3080: https://www.reddit.com/r/nvidia/comments/jspy61/godfall_requires_only_6gb8gb_vram_at_4k_maxed_out/

F

foo_1337

Gast

Die Settings sind im Video zu sehen

F

foo_1337

Gast

Würde mich sehr wundern, wenn das 5-6 GB ausmachen sollte

Ähnliche Themen

- Antworten

- 380

- Aufrufe

- 58.324

- Antworten

- 457

- Aufrufe

- 69.770

- Antworten

- 464

- Aufrufe

- 84.877

- Antworten

- 83

- Aufrufe

- 12.218